Ehningen, Starnberg, 27. April 2021 - IBM stellt Neuerungen innerhalb seines Storage-Portfolios vor: Datenverwaltung mit container-nativer Lösung künftig vereinfachen...

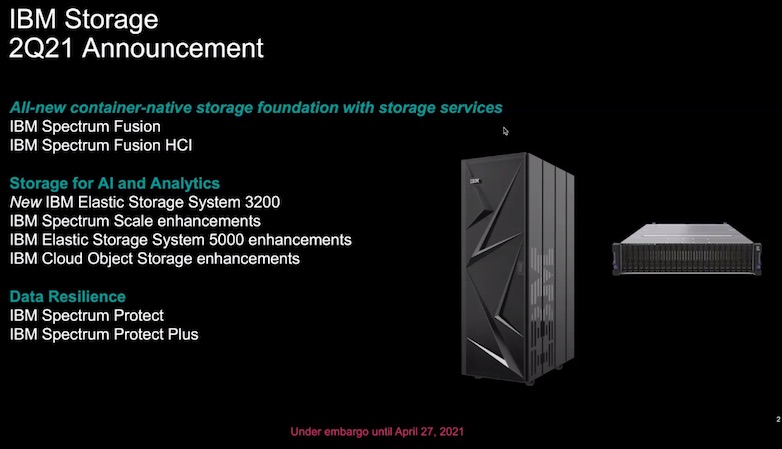

Zur Ankündigung: IBM stellt heute neue Software Defined Storage-Lösungen vor, um die Erkennung, den Zugriff und die Verwaltung von Daten in zunehmend komplexen Hybrid-Cloud-Umgebungen zu erleichtern und KI-Workloads besser unterstützen zu können. 1. IBM Spectrum Fusion ist eine neue Container-native (Software-definierte) Storage Lösung, die laut Anbieter in der zweiten Hälfte des Jahres 2021 verfügbar sein wird und zuerst als integrierte Lösung in Form einer (HCI-)Appliance mit Red Hat OpenShift auf den Markt kommen soll.*** Die Neuerung wird IBMs paralleles Filesystem (Spectrum Scale) mit spezieller Erasure-Coding Technologie so zusammenführen, dass Unternehmen mit ihren Anwendungen einen weniger komplexen Ansatz für den nahtlosen Zugriff auf Daten im Rechenzentrum, im Edge-Bereich und in hybriden Cloud-Umgebungen erreichen können. IBM Spectrum Fusion ist speziell für containerisierte Workloads vorgesehen und in der Lage, verschiedene Datenquellen wie NFS oder S3-Speicher zu integrieren; eine GPU-Unterstützung für KI-Workloads ist ebenfalls geplant.

2. Darüber hinaus wurden Updates für die IBM Elastic Storage Systemfamilie (ESS) vorgestellt. Das überarbeitete Modell ESS 5000 bietet nach vorliegenden Angaben zehn Prozent mehr Speicherkapazität [1], während das neue ESS 3200 System über die doppelte Leseleistung (bis 80 GB/s Durchsatz auf 2U) seines Vorgängers verfügt. [2]

Mit der zunehmenden Verbreitung der Hybrid-Cloud wächst die Notwendigkeit, den Edge des Netzwerks zu verwalten

Oftmals geografisch verstreut und nicht mit dem Rechenzentrum verbunden, kann Edge Computing riesige Datenmengen blockieren. Diese könnten auf andere Weise für Analysen und KI genutzt werden. Wie das digitale Universum wächst auch der Edge-Bereich weiter und schafft immer mehr voneinander getrennte Datenquellen und -silos. Laut einem aktuellen Bericht von IDC [3] soll die Anzahl der neuen betrieblichen Prozesse, die auf Edge-Infrastrukturen eingesetzt werden, von heute weniger als 20 Prozent auf über 90 Prozent im Jahr 2024 ansteigen [4], da die digitale Technik die IT-/OT-Konvergenz beschleunigt. Und bis 2022 schätzt z.B. IDC, dass 80 Prozent der Unternehmen, die auf ein hybrides Business-by-Design umstellen, ihre Ausgaben für KI-fähige und sichere Edge-Infrastrukturen um das Vierfache erhöhen werden [5], um geschäftliche Agilität und Erkenntnisse in nahezu Echtzeit zu liefern.

Industrieanwendung am Beispiel Guardant Health: Das US-Unternehmen im Bereich der Präzisionsonkologie hat sich zum Ziel gesetzt, durch den Einsatz seiner proprietären Bluttests, umfangreicher Datensätze und fortschrittlicher Analytik zur weltweiten Bekämpfung von Krebs beizutragen. Die Daten- und High-Performance-Computing-Plattformen des Unternehmens verwandeln riesige Mengen an genomischen Daten in verwertbare Erkenntnisse für Onkologen, Forscher und die biopharmazeutische Industrie. Anwenderzitat Kumud Kalia, CIO bei Guardant Health: „Wir verwalten große Compute-Cluster, die einen hohen Datendurchsatz auf einer großen Anzahl von Dompute-Knoten erfordern. Das parallele Dateisystem von IBM Spectrum Scale liefert hohe Leistung, während die ESS-Systeme den Datendurchsatz liefern, den unsere genomischen Pipelines benötigen. Ich freue mich auf die weitere Zusammenarbeit mit IBM, um weitere Innovationen auf dieser Plattform zu entwickeln.“

IBM Spectrum Fusion

Die erste Veröffentlichung von IBM Spectrum Fusion ist laut Anbieter in Form eines Container-nativen, hyperkonvergenten Infrastruktur-Systems (HCI) geplant. Wenn es in der zweiten Hälfte des Jahres 2021 auf den Markt kommt, wird es Compute, Storage und Networking innerhalb einer Lösung integrieren und mit Red Hat OpenShift ausgestattet sein. Damit können Unternehmen Umgebungen sowohl für virtuelle Maschinen als auch für Container unterstützen und softwaredefinierten Speicher für Cloud-, Edge- und containerisierte Rechenzentren bereitstellen. Anfang 2022 ist die Veröffentlichung einer reinen SDS-Version von IBM Spectrum Fusion geplant.

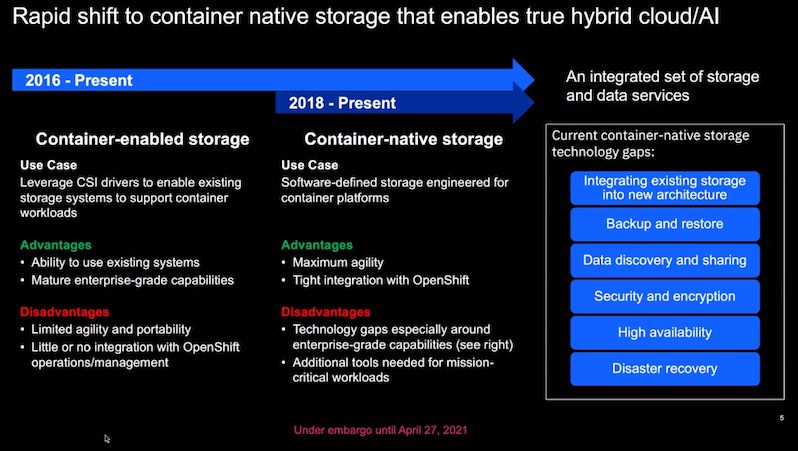

Abb. 1: IBM Spectrum Fusion, container-native storage technology gaps (Bildquelle: IBM)

Durch die Integration einer vollständig containerisierten Version des parallelen Filesystems und der Datensicherungssoftware von IBM kann IBM Spectrum Fusion Unternehmen eine optimierte Möglichkeit bieten, Daten aus dem gesamten Unternehmen zu finden. Darüber hinaus sollen sich bestehende Datensätze einfacher virtualisieren und beschleunigen lassen, indem sie die am besten geeignete Speicherebene (Tier) nutzen.

Mit den IBM Spectrum Fusion-Lösungen werden Unternehmen in der Lage sein, nur eine einzige Kopie der Daten zu verwalten. Sie müssen keine doppelten Daten mehr erstellen, wenn sie Anwendungs-Workloads über das Unternehmen hinweg verschieben, was die Verwaltungsfunktionen vereinfacht und gleichzeitig Analysen und KI rationalisiert. Darüber hinaus können Compliance-Aktivitäten (z. B. DSGVO) durch eine einzige Datenkopie verbessert werden, während das Sicherheitsrisiko durch das Vorhandensein mehrerer Kopien reduziert wird.

Zusätzlich zu seinen globalen Verfügbarkeitsfunktionen wird IBM Spectrum Fusion für die Integration mit IBM Cloud Satellite entwickelt, um Unternehmen die vollständige Verwaltung von Cloud-Services am Edge, im Rechenzentrum oder in der Public Cloud über eine zentrale Verwaltungsschnittstelle zu ermöglichen. IBM Spectrum Fusion wird auch für die Integration mit Red Hat Advanced Cluster Manager (ACM) zur Verwaltung mehrerer Red Hat OpenShift-Cluster weiterentwickelt.

Abb. 2: Übersicht zur Ankündigung, 2Q21* (Bildquelle: IBM)

Die Weiterentwicklung der IBM Elastic Storage Systeme umfasst:

Globaler Daten-Boost: Der IBM ESS 3200, eine neue 2U-Speicherlösung, bietet einen Datendurchsatz von 80 GB/Sekunde pro Knoten – eine Steigerung der Leseleistung um 100 Prozent gegenüber dem Vorgängermodell [6] ESS 3000. Zur weiteren Leistungssteigerung unterstützt der 3200 bis zu 8 InfiniBand HDR-200 oder Ethernet-100 Ports für hohen Durchsatz und niedrige Latenz. Das System kann außerdem bis zu 367 TB Speicherkapazität pro 2U-Knoten bereitstellen.

Petabytes on top: Darüber hinaus wurde das IBM ESS 5000-Modell aktualisiert, um 10 Prozent mehr Dichte als zuvor zu unterstützen, was eine Gesamtspeicherkapazität von 15,2 PB ergibt. Darüber hinaus sind alle ESS-Systeme jetzt mit optimierten containerisierten Bereitstellungsfunktionen ausgestattet, die mit der neuesten Version von Red Hat Ansible automatisiert werden.

Sowohl ESS 3200 als auch ESS 5000 bieten containerisierte Systemsoftware und Unterstützung für Red Hat OpenShift und Kubernetes Container Storage Interface (CSI), CSI-Snapshots und -Klone, Red Hat Ansible, Windows, Linux und Bare Metal-Umgebungen. Die Systeme sind außerdem mit IBM Spectrum Scale ausgestattet.

Darüber hinaus arbeiten der 3200 und 5000 auch mit IBM Cloud Pak for Data, einer vollständig containervisierten Plattform des Unternehmens für integrierte Daten- und KI-Services, für die Integration mit IBM Watson Knowledge Catalog und DB2. WKC ist ein cloudbasiertes Metadaten-Repository für Unternehmen, das Informationen für KI, maschinelles Lernen und Deep Learning aktiviert. Benutzer verlassen sich darauf, um auf Daten, Wissensbestände und deren Beziehungen zuzugreifen, sie zu kategorisieren und zu teilen.

IBM Db2 for Cloud Pak for Data ist ein KI-unterstütztes Datenmanagementsystem, das auf Red Hat OpenShift aufbaut. Um Edge-Computing, Core-Rechenzentren sowie private und öffentliche Cloud-Umgebungen noch besser zusammenzuführen, sind der ESS 3200 und 5000 laut Anbieter auch vollständig in IBM Cloud Satellite integriert.

*** Quelle / Link > https://www.ibm.com/blogs/systems/making-storage-simple-for-containers-edge-and-hybrid-cloud/

Zitat Denis Kennelly, General Manager bei IBM Storage Systems: „Es ist klar, dass die Erstellung, Bereitstellung und Verwaltung von Anwendungen fortschrittliche Funktionen erfordert, die eine schnelle Verfügbarkeit von Daten im gesamten Unternehmen ermöglichen – vom Edge über das Rechenzentrum bis hin zur Cloud. Es ist nicht so einfach, wie es klingt, aber es beginnt mit dem Aufbau einer grundlegenden Datenschicht, einer containervisierten Informationsarchitektur und der richtigen Speicherinfrastruktur.“

Fußnoten (Quelle IBM):

- [1] Total capacity per node of previous 5000 was 13.5PB

- [2] The ESS 3200 performance was measured using the IBM Large File Sequential Read Bandwidth test, which is based on industry standard benchmark, IOR; ESS 5000 capacity percentage is based on the inclusion of an additional disk enclosure, which supports up to 1.7PB of capacity.

- [3] IDC FutureScape: Worldwide Future of Operations 2021 Predictions, October 2020.

- [4] Ibid / [5] Ibid

- [6] The ESS 3200 performance was measured using the IBM Large File Sequential Read Bandwidth test, which is based on the industry standard benchmark, IOR.

*Rechtlicher Hinweis: "Aussagen über die zukünftige Richtung und Absicht von IBM können ohne Vorankündigung geändert oder zurückgezogen werden und stellen lediglich Ziele und Absichten dar."

Querverweis:

Unser Beitrag > IBM erweitert Support zur persistenten Speicherung und Sicherung für Container-Workloads

Unser Beitrag > Ausfallsicherheit für Kubernetes-Daten auf Basis von Red Hat OpenShift Container Storage 4.6

Unser Beitrag > Raus aus den Datensilos – Die Tool-Konsolidierung hat für Unternehmen Priorität