Starnberg, 13. Febr. 2013 – Zur Entwicklung von Software Defined Datacenter mit Hilfe von Virtual Storage Appliances auf Hypervisor-Ebene...

Die Server Virtualisierung ist den Kinderschuhen entwachsen und hat sich auf breiter Front in den Rechenzentren etabliert – nun auch vermehrt bei unternehmenskritischen Anwendungen. Das gleiche kann man von der Storage Virtualisierung nicht behaupten – zu sensitiv war bislang der Bereich Daten- und Storage Management für viele Unternehmen, Neben den üblichen Kriterien wie Verfügbarkeit, Leistung oder Skalierbarkeit spielt dabei auch der Kostenfaktor eine Rolle. Womit wir beim Thema wären... den „versteckten Kosten“ bei der Server Virtualisierung. Sie wollen wissen, was das mit Storage zu tun hat?

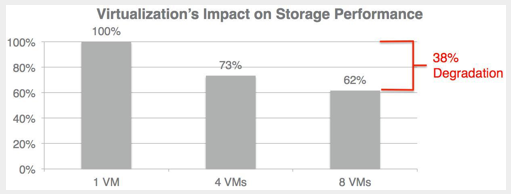

Mit Hilfe der Virtualisierung läßt sich die Serverlandschaft konsolidieren und hierbei werden neben diversen betrieblichen Vorteilen direkte Einsparungen erzielt (Server CAPEX, Wartungskosten etc.); leider werden diese jedoch auf Grund des schnellen Wachstums (VM’s / Daten) / Anwendungen) rasch durch den Kapazitätszuwachs auf der Speicherseite wieder kompensiert (versteckte Kosten). Auch sind Performance-Aspekte kritisch zu sehen, da ein optimales Zusammenspiel von Storage und VM’s bei anspruchsvollen IO-Workloads keine simple Angelegenheit ist (IOPS-Optimierung bei Write-Commands, Disk-Latency etc.). Die Gesamtleistung des virtuellen Systems ist jedoch entscheidend und nicht nur eine Optimierung einzelner Komponenten (balanced system); übrigens kein großer Unterschied zu früheren Architekturen, wo sie systembedingt auch diverse „Hotspots“ oder Engpässe hatten.

Software-basierte Storage Hypervisor (Virtual Storage Appliance, VSA) lösen prinzipiell die komplexen Abhängigkeiten durch einen transparenten (Caching-) Layer auf Virtual Machine - Ebene, der zusätzlich verschiedene Storage Management - Funktionen zusammenfasst und I/O-seitig gegenüber Shared Storage Arrays transparent optimiert (sequential block-I/O anstelle Random-Acces-IOPS profiles über block-mapping). Weitere Vorteile ergeben sich aus der plattform-unabhängigen Storage-Unterstützung des "Systems", welches Data-Services wie Thin Provisioning, Migration, Desaster Recovery oder VM-optimierte Snapshots für alle angeschlossenen Speicherarrays integriert im Hypervisor bereitstellen kann.

Bildquelle: Virsto Software 2013 - Storage Performance Degradation

Ein weiterer Aspekt in diesem Zusammenhang betrifft den Einsatz von FLASH-SSDs. Auf Grund der Performance-Optimierung durch den Storage Hypervisor wird weniger SSD-Storage (Faktor 2 bis 3) für die I/O-Beschleunigung benötigt. Teurer Speicherzukauf in diesem Bereich wird somit gespart, da die Storage-Effizienz durch weniger SSDs bzw. Ausnutzung vorhandener Ressourcen optimiert werden kann (kein "Fat Provisioning").

Da wird die aktuelle Aquise von Virsto durch VMware im Kontext von Software Defined xxx schnell verständlich: Mit einem dominanten Marktanteil im mittleren Leistungssegment (Windows O/S) adressiert die VMware-Storagelösung einen wachsenden Bedarf gerade bei kleineren und mittelständischen Unternehmen, die oft weder über das Know-How noch das Budget für teure und komplexe Storagelösungen verfügen. VMware baut sein Portfolio damit konsequent in Richtung SW-Definded-Datacenter aus (neben Storage wird der Bereich Netzwerke – siehe Nicira-Aquise - wichtiger und VMware ist dabei, ein komplettes Framework zu entwickeln. Der Vorteil aus Anwendersicht liegt in der verbesserten Portabilität von Workloads bzw. automatisierter Private- zu Public-Cloud Integrations-Möglichkeiten.

Es wird interessant sein zu beobachten, wie VMware die Integration von Virsto nicht nur technologisch, sondern auch aus Sicht der Beschaffungs-/Lizenz-/Wartungskosten weiterentwickeln wird. Schon heute sind die Ausgaben beim Betrieb, dem Unterhalt und der Verwaltung von VM-Umgebungen auf Grund der Menge und des schnellen Wachstums spürbar gestiegen. Deshalb und auf Grund weiterer Argumente (Standards / geringere Herstellerabhängigkeit) erfreuen sich Open Source Lösungen von Red Hat, KVM oder XEN zunehmender Beliebtheit. Analog dazu entwickelt sich auch hier das Storage Software – Angebot funktional weiter (siehe Red Hat / Gluster Storage Server, Nexenta (open ZFS), Oracle usw).

Für komplexe Rechenzentrums-Anwendungen mit Tausenden von VMs und komplexen SAN-Architekturen spielt das Thema Software Defined Storage aus meiner Sicht derzeit hier noch kaum eine Rolle (außer für dedizierte Applikationen), da kommerzielle virtuelle Storage Appliances aus Leistungs- und Verfügbarkeitsgründen ihre Robustheit im high-end-RZ Betrieb erst nachhaltig unter Beweis stellen müssen bzw. die Belastung auf der Serverseite unvorhersehbar erhöhen können (Kriterien betreffen auch: n-Node-Cluster Support / Block & File Access / SAN Fabric Unterstützung). Kritisch ist ferner die Integration in bestehende Management-Systeme (Systeme-/Anwendungen) zu sehen.

Als Lösung für diese Aufgaben bieten sich derzeit neben den "klassischen" Enterprise Arrays auch Appliance-basierte Storage Virtualisierungs-Systeme (Hardware-/Software) wie der speziell für den RZ-Betrieb konzipierte, hochintegrierte Storage Volume Controller (SVC) von IBM bzw. auch zunehmend Appliances von DataCore oder FalconStor (Schwerpunkt Data Protection) für einen breiteren Anwenderkreis an.