Starnberg, 6. Juli 2012 – Der Markt für Backup-Recovery-Lösungen beginnt sich zu verändern – Neue Snapshot- und Replikationsverfahren für virtuelle Ressourcen…

Zum Hintergrund: Wer kennt die Anbieter nicht? CommVault, EMC, Symantec, IBM, HP Autonomy, CA Technologies, NetApp, Asigra, Quest Software (vRanger), Quantum, FalconStor Software, Arcronis, Evault (Seagate), Veeam Backup and Replication, Fujitsu, Dell (Quest), VMware Data Recovery 2.0 usw... Klassische und auch neue Player … Aber was ist die "richtige" Anbieterlösung für meine Anforderungen im Unternehmen? Nicht einfach zu beantworten, zu Mal sich nicht alle Anwender unbedingt gerne mit der Thematik Enterprise Backup beschäftigen... Auch ist zu beachten, dass Backup-Lösungen nicht "mal" so einfach gewechselt werden; sie weisen typischerweise einen Life-cycle von 5 - 10 Jahren oder mehr auf; Hier spielt dann auch weniger die Technologie- sondern die Prozess- und Mind-Set-Komponente beim Anwender eine dominierende Rolle.

Andererseits beginnt die Dynamik bei der Nutzung von Server-Virtualisierungstechnik, sowohl die Komplexität und auch den Backup-Markt selbst nachhaltig zu verändern (neue Anbieter, Funktionalitäten, Firmenübernahmen…). Unter dem Druck steigender Datenmengen = geringere Zeit, engen SLA's bei modernen Apps in Verbindung mit der dynamischen Entwicklung bei virtualisierten Server-Instanzen kommen klassische Sicherungsverfahren, vielfach noch auf Tape, inzwischen auch bei kleineren Umgebungen schnell an ihre Leistungsgrenzen.

Backup-to-Disk (D2D) mit integrierter DeDuplizierung-/Compression – kombiniert mit Snapshots und Data Replication – etabliert sich als bevorzugte Technologie zum Schutz von Unternehmensdaten. Moderne Lösungen sind als (virtuelle) Appliance oder Software und einige Agent-less ausgeführt. Natürlich bedeutet dies auf die Medien bezogen nicht, dass Tapes generell überflüssig werden… aber in der "line of defense" nehmen sie als Sicherungsmedium in der Speicherhierarchie inzwischen einen anderen Platz ein (Siehe: Active Archiving, Deep archives, Complianceaspekte, Desaster Recovery Architekturen, Tape-Vaults etc.).

Deshalb ist es auch notwendig, zwischen Snapshots, Backup-/Restore und Disaster Recovery – Prozessen sauber zu differenzieren: Snapshots z.B. allein sind noch keine 100% Garantie gegen mögliche Datenverluste und sollten aus meiner Sicht derzeit immer mit weiteren Sicherungsstrategien (Software, Hardware) begleitet werden. Allerdings ist absehbar – weiter steigende Datenmengen und kürzere RTO-/RPO vorausgesetzt – dass neue Technologien (Next Gen. Thin, infinite Snapshots, Thin Replication etc.), kombiniert mit Cloud-Services in den nächsten Jahren verstärkt traditionelle, Client-/Server-basierte B-/R-Architekturen ersetzten werden (Randbedingungen: Unstrukturierte Daten, Kosten, Zeitaufwand, Personal, Admin.-Aufwand etc.).

Alleine auf Grund der Restore-Performance (Menge der Daten, Zeitfenster) sind die Vorteile von D2D-Recovery für grosse, virtualisierte Serverfarmen mit vielen Daten unübersehbar, wenngleich die Komplexität des Datenschutzes von VM's noch unterschätzt wird. Aktuelles Beispiel: Der Ausfall von Teilen Amazon's Cloud Services – Netflix Content (Streaming-Dienste) für Millionen Kunden - war trotz der Sicherung in zwei weiteren Rechenzentren rund zwölf Stunden nicht erreichbar. Die Gründe: Durch Stromausfälle (Blitzschlag etc.) hatten viele Serverinstanzen keine Verbindung mehr zu ihren Back-Up-Diensten. Die VM's legten für diesen Fall sofortige Sicherheitskopien an, die jedoch die Speicherauslastung und den Data-Traffic in den noch funktionierenden Sektoren von Amazon extrem schnell ansteigen ließen. Zugegeben, nicht jedes RZ hat die Kapazität und Struktur einer AWS – Cloudinstanz… Die Ereignisse zeigen aber potentielle Problemfelder gut auf.

Es reicht nicht, nur schnelle Server und Storagearrays mit Sicherung zu betreiben… im Sinne eines "balanced systems" muss auch dem I/O-Traffic-Sizing, insbesondere bei den Netzwerkverbindungen, besondere Aufmerksamkeit zukommen. Das Thema "Datensicherung" ist eben komplex und umfasst neben dem Applikations-Know-How das Sizing bzw. Planung für die verschiedensten Bereiche der Infrastruktur (Server, Storage, Netze, Backup-/D/R-Software etc.).

Nachfolgend habe ich Ihnen deshalb in meinem Blog mittels einer kurzer Übersicht verschiedene aktuelle - auf die Sicherung von virtual Machine Umgebungen spezialisierte Lösungen - aufgeführt und kommentiert (kein Anspruch auf Vollständigkeit). Weitere Details zu Funktionen, Leistungsmerkmalen und Preisen erhalten Sie bei den jeweiligen Anbietern.

Teil 1 dieser Übersicht befasst sich mit Lösungen der Anbieter Symantec, VMware, Acronis und IBM, während Teil 2 (erscheint bis Mitte Juli) sich mit Autonomy (HP), NetApp, EMC, CommVault und Asigra befassen wird. Weitere Anbietertechnologien wie CA Technologies, Quantum, Quest (Dell Aquisition), FalconStor und Veeam sollen dann in Teil 3 vorgestellt werden.

Anregungen sind wie immer willkommen !

Norbert Deuschle

1. VMware Consolidated Backup VCB, Data Recovery 2.0

Consolidated Backup besteht aus Dienstroutinen, mit denen Admins ihre virtuelle Maschinen über CLI sichern können. Über APIs können Drittanbieter z.B. Snapshot-basierte Backupfunktionen integrieren. VCB ist Teil der ESX-Produktlinie. Aktuell werden VCB's mit vSphere jedoch nur mehr bis zur V.4.1 unterstützt. Unter vSphere 5.0 finden sich dafür vier separate vStorage-APIs. VMware Data Recovery 2.0 ersetzt VCB und wurde in vCenter integriert. Die Integration dieser Funktionen mit anderen vStorage APIs wie DRS (Distributed Resource Sheduler) erlauben es auch, migrierte VMs schnell wiederzufinden und eine engere Integration mit Storage Arrays herzustellen (VAAI, VASA). Zudem wird mit Data Recovery Daten-Deduplizierung für redundante Files unterstützt. Die Restore-Funktion ermöglicht die Wiederherstellung von VMs, einzelnen Files oder ganzen Images aus Snapshots. VMware selbst supported weiterhin VM-Backups für ESX/ESXi unter VCB über einen zentralen Backup-Server: VCB erstellt Snapshots der virtuellen Maschine und mountet diese auf einem dedizierten Proxy-Server. Der Backup-Prozess wird auf dem Proxy-Server ausgeführt, d.h. etwaige Belastungen für VM-Ressourcen bleiben minimiert. Da mit vSphere 5.0 jedoch VCB ersetzt wurde, ist eine zusätzliche Drittanbieter Backup-Software in jedem Falle nötig, um mit V 5.0 die RTO-RPO-Anforderungen durch entsprechenden Datenschutz sicherzustellen (Quelle VMware).

http://communities.vmware.com/message/1834943).

Pro: Integriertes VMware Tool, Leistungsfähig, Optimiertes Zusammenspiel mit anderen VM-Storage-APIs

Con: Komplizierte Benutzung, VCB CLI, Weitere Backup-Software nötig, Homogen, nur VMware Hypervisor-support, keine Konsistente Backup-Architektur (mehrere Tools / Know-How / Lizenzarten nötig).

http://www.vmware.com/de/technical-resources/

2. Symantec NetBackup

NetBackup bietet eine konsistente Backup-Umgebung mit Oberfläche für heterogene virtuelle und physikalische Umgebung. Mit einer Lösung lassen sich virtuelle Systeme in Standard-Unternehmens-Backup-/Restore-Prozessen zusammen mit physikalischen Ressourcen zusammenführen. NetBackup integriert Daten-Deduplizierung, fast-restore von Files, Backup-/Recovery für die wichtigsten Unternehmens-Anwendungen und bietet zwischenzeitlich auch eine vereinfachte Installation. NetBackup unterstützt VMware vSphere und Microsoft Hyper-V. Für kleinere Umgebungen liefert Symantec mit Backup Exec 2012 ein B-/R-Tool in verschiedenen Leistungspaketen: Die V-Ray Edition z.B. kann sowohl physische wie auch virtuelle Umgebungen sichern. Ferner ist Single-File-Recovery, Deduplizierung für VMware,- Hyper-V- sowie für Standard Server unterstützt. Der Restore von physischen auf virtuelle Systeme ist in Backup Exec integriert. Bei der Wiederherstellung der Daten kann die Lösung bei Bedarf automatisch eine VM erzeugen. Mit seiner Symantec Backup-to-Virtual-Technologie, B2V kann die Migration von Daten von realen zu virtuellen Servern vereinfacht werden.

Pro: Backup-Accelerator-, Replication-Director Funktionen erlauben detailliertes Management aller B-/R-Funktionen, End-to-End Management-/Recovery für Rechenzentrums-Ressourcen, Vorkonfigurierte Back-up Appliances verfügbar (SMB-Markt); granularer Restore von Sharepoint und anderen Microsoft-Lösungen.

Con: SW-Agenten, reduzierte DeDupe-Performance bei komplexen Umgebungen (z.B. bei Sicherung auf Tape).

http://www.symantec.com/de/de/netbackup

3. Acronis vmProtect 7

Acronis setzt verstärkt darauf, seine Produkte auch unternehmensweit für virtuelle- und Cloudumgebungen zu optimieren (siehe SQL Server oder Active Directory Apps-support). vmProtect 7 ermöglicht granularen Restore von Exchange 2010 mit Hilfe eines single-pass backups (Agentenlos), vCenter - Integration, kostenfreie VM-Replikation mit Failover auf eine replizierte VM und bare-metal Restore für ESXi Server. Acronis Backup & Recovery 11 arbeitet mit Agentless-Backups sowohl für VMware als auch für Hyper-V. Acronis Backup & Recovery bietet Client- und Target – Daten DeDuplizierung, Verschlüsselung und Compression (mehr zu den Deduplizierungs-Grundlagen finden Sich auch auf unserer Seite unter: http://www.storageconsortium.de/content/node/877).

Pro: Als virtuelle Appliance oder dediziert zu betreiben. Integration in VMware mit vCenter plug-in und Single-pass Backup für Exchange. Relativ einfache Installation und Bedienung. Derzeit einziger Anbieter, der VM-Restore für heterogene Hypervisor-Systeme erlaubt. Gutes Preis-/Leistungsverhältnis. B-/R unter Windows-/Linux.

Con: Acronis weist keine Historie als unternehmensweit konzipierte Datenschutz-Lösung (DataCenter-Focus, Service) auf, sondern ist bislang mehr auf Abteilungsebene oder für Aussenstellen im Einsatz. Granular Restore-Support für MS-SQL Server & SharePoint noch nicht verfügbar.

4. IBM Tivoli Storage Manager, TSM

Die TSM-Software wurde von Anfang an für den Einsatz für mission-critical Applications und Rechenzentren konzipiert und wird dementsprechend von vielen auch sehr grossen IT Shops eingesetzt. Wesentliche Funktionen umfassen ein policy-based Data Management inkl. umfangreicher Archivierung, Target- also auch Source-Deduplizierung (aus Diligent-Aquise), intelligente Kompression, progressive incremental backup (incremental forever mit DB2 Datenbank-Katalog) und Optionen für Continuous Data Protection, CDP (siehe FilesX-Aquise). TSM ist im Gegensatz zu einigen anderen Angeboten ein reines Produkt der IBM-Inhouse Entwicklung, zwar komplex aber entsprechend integriert und leistungsfähig. IBM hat allerdings relativ spät den Fokus auf VMware & Co gelegt, so dass größere Erweiterungen im Bereich Virtual Server – Support (ausser den bereits 2011 mit TSM für virtual environments erfolgten) wohl noch für die 2.H2012 zu erwarten sind.

Pro: Skalierbarkeit des DB2 Mediakatalogs, Unternehmensweites end-to-end Data-Recovery, DeDupe kostenfrei integriert / Cognos-basiertes Reporting Tool, Robuste Lösung (SW-Qualität), neue kapazitätsbezogene Lizenzen, Referenzinstallationen, Support

Con: GUI immer noch relativ komplex (user-experience, training-/skill-set), weniger Installationen im Markt für kleinere, mittlere Unternehmen (komplexer, Pricing). IBM Plattform-zentrierte Funktionen für Recovery- und Data Protection (kein heterogener Snapshots-Support; nur IBM Storage). Heterogene Server-/ Virtual Machine – Unterstützung fehlt derzeit.

http://www-03.ibm.com/systems/de/storage/

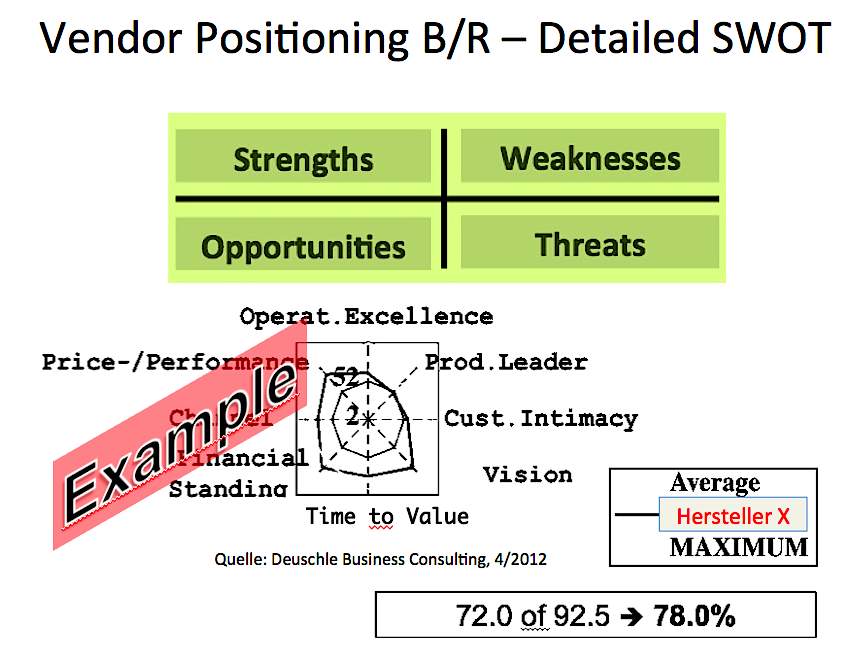

Bildquelle: Deuschle Storage Business Consulting, 2012

Herstelleranalyse - Enterprise Backup-/Recovery Lösungen

http://www.storageconsortium.de/content/node/1239