Starnberg, 20. Dez. 2016 - Neue Anwendungen erzeugen riesige Mengen an Daten; diese müssen kostenverträglich abgespeichert werden können...

Um was es hier geht: Der Speicherbedarf auf Grund des Wachstums von verschiedensten un-/semi-strukturierten Inhalten, sei es von Sensornetzwerken (IoT, neuen Unternehmensanwendungen, Content Distribution-Systemen, Big Data Analytics (Hadoop etc.) steigt unaufhörlich; zusätzlich getrieben von Compliance- (EU/nationale Vorschriften) bzw. Disaster Recovery – Anforderungen. Storage "in der Cloud" wird damit für Unternehmen und Organisationen eine wichtige Option und man muss kein Prophet sein um vorherzusagen, dass kurz-/mittelfristig deutlich mehr Rechenzentrums-basierte Cloud-Speicherangebote (on-premise /Public/hybrid) entstehen werden.

Cloud Storage macht aber nur Sinn, wenn die neuesten Entwicklungen zur Speicherung, Deduplizierung und weiteren Methoden der anwendungsnahen Kapazitätsoptimierung sowie eines skalierbaren Data Managements genutzt werden, um eine wirtschaftlich möglichst effektive Verwendung der physikalischen Speicherressourcen zu erreichen. Software-definierte Scale-out (parallele) Filesysteme stellen in diesem Zusammenhang aus operationaler Sicht (zentrale Verwaltungsinstanz) und der weiteren Abstraktionsebene (Software Defined) einen wichtigen Faktor für die Wirtschaftlichkeit der Angebote dar (OPEX).

Aber derzeit ist die „gute alte Physik“, sprich der (noch) überwiegend aus mechanischen Festplatten aufgebaute Speicher entscheidend, denn darauf wird der weitaus größte Teil aller erzeugten Daten gespeichert. Dies betrifft im Block-/Filebereich SAS- aber aus Kostengründen hauptsächlich SATA-HDDs (s.a. Object Storage). Im Backup-Restore-Bereich haben HDDs das Tape bereits so gut wie abgelöst, während im Archivbereich die Kombination aus Flash (Metadaten Cache), HDD und Tape (cold data) häufig anzutreffen ist.

Neben den Beschaffungs- und Betriebskosten stehen bei der Menge an installierten Laufwerken neben Zuverlässigkeit, Haltbarkeit-/Lesbarket der Daten und Betriebsstabilität natürlich zunehmend der Energieverbrauch im Fokus. Hier kommt Tape verstärkt in’s Spiel oder besser... bleibt im Spiel: Keine der aktuellen Speichertechnologien ist derzeit in der Lage, riesige Datenmengen bis in den Exabyte-Bereich hinein stromlos besser zu speichern. Mit „besser“ meine ich; kosteneffizient, ggf. portabel, haltbar und skalierbar in der Kapazität (libraries).

Zur Zukunft von Tape

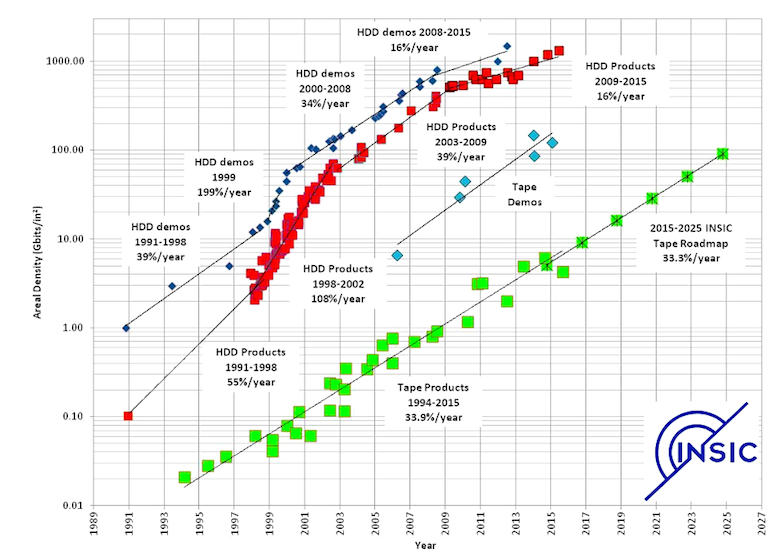

Weitere Entwicklungen bei der Festplattentechnologien lassen in den nächsten Jahren einen Kapazitätssprung erwarten (siehe Abb. 1), aber der Stromverbrauch des drehenden Mediums und dessen geringere implizite Zuverlässigkeit auf Grund der Mechanik bleiben bestehen (80 TB HDD in 2020), weshalb Non-Volatile-Memory wie PCM, 3-D NAND (Storage Class Memory) der Festplatte kurz-/mittelfristig und ganz neue Entwicklungen (z.B. Memristor, Atomic Scale Memory etc.) längerfristig natürlich verstärkt Konkurrenz machen werden. Kapazitätsbezogen wird NAND Flash in der Breite weiter zulegen, d.h. die Speicherkapazitäten steigen deutlich (geplant: 60 TB Flash SSD in 2017) und verschieben damit die Speicherhierarchie (hochkapazitative Flash SSDs als Ersatz für SATA HDDs...), während in Bezug auf die Speicherkosten (cost per bit) jedoch Tape konkurrenzlos niedrig bleibt.

Derzeitiges Fazit: Je mehr Daten abzuspeichern sind, desto deutlicher wird der Kostenvorteil von Tape ausfallen (cold storage / deep archives). Neue Entwicklungen bei Bandtechnologien (Bitdichte / areal density) lassen auf einen deutlichen Kapazitätssprung hoffen (220 TB pro Kassette ?!), der den Abstand im Vergleich zur parallel stattfindenden HDD-Entwicklung dann weiter vergrößern dürfte.

Abb. 1: Areal Density Trends (Bildquelle INSIC 2015-2025 International Magnetic Tape Storage Roadmap). Quelle: https://insic.org/