Ehningen, Starnberg, 19. Dez. 2016 – Neben File- und Block wird sich Objektspeicher zur dritten Plattform entwickeln; neues Trio aus Objekt-, Cloud- und Cognitive…

Zum Hintergrund: 2016 war ein richtungsweisendes Jahr für IBM, in dem der Weg mit den Schwerpunkt-Themen Cognitive- und Cloud Computing geebnet wurde. Diese Neuorientierung stellt laut Hersteller auch eine grosse Chance für den Bereich Storage dar. Die Wachstumsfelder Cognitive- und Cloud Computing drehen sich ja immer mehr um Daten und ihre sinnvolle Speicherung. Bei Software Defined Storage (SDS) und Software Defined Infrastructure (SDI) wurden Anbieterseitig verschiedene Erweiterung bei Flashspeicher-Lösungen vorgestellt und insbesondere auch der Ausbau neuer (kostengünstiger) All-Flash-Arrays für Cloud und Cognitive Computing bekannt gegeben. Im Oktober fand ferner die Bereitstellung einer neuen Cloud Objekt Storagelösung (ex Cleversafe) statt. Anfang November folgte der Cloud-Support um IBM Spectrum Virtualize, DeepFlash ESS und andere Lösungen, um Daten in die Cloud zu verschieben; damit kann nun prinzipiell jedes IBM Storage-System mit der Cloud verbunden werden... Wir sprachen zum Jahreswechsel hierzu mit Herrn Ralf Colbus, IBM Leading Storage Professional und Member im weltweiten CTO Team. Nach seiner Meinung sind die Aussichten für IBM im kommenden Jahr 2017 vielversprechend und werden durch folgende Trends unterstützt werden:

1. Flash-basierte Datenspeicherung wird weiter zunehmen:

- Im Jahr 2017 wird die Nutzung von Flash exponentiell zunehmen. Während sich diese Form der Datenspeicherung bisher weitgehend auf geschäftskritische Daten gestützt hat, wird sie künftig in alle Speicher- und Unternehmensbereiche Einzug halten, um die Agilität von Unternehmen voranzutreiben. Darüber hinaus erwartet der Anbieter mehr Einführungen von OpenCAPI- und NVMe-Technologien, um Latenzzeiten deutlich zu reduzieren und auf diese Weise Nutzer bei der Verwaltung größerer Datenmengen zu unterstützen.

2. Data Analytics wird eine Revolution erleben:

- In der Vergangenheit fanden Gespräche über Big Data meist im Kontext von Hadoop (HDFS) statt. Die Branche ist jedoch heute mit ihren Einschränkungen an eine Grenze gestoßen, Big Data zu sichern und zu verwalten. Infolgedessen wurde Big Data zu einem "schwarzen Loch" im HDSFS-Cluster ohne dass sich jemand wirklich darum kümmerte, wie man diese Daten sinnvoll verwaltet. Im Jahr 2017 dürfte laut IBM das Spark-Betriebsmodell durch 'in memory analytics' eine gute Möglichkeit für Big Data-Analytics darstellen; hauptsächlich aufgrund der Fähigkeit, die Datenbewegung deutlich zu reduzieren sowie Analytics im Prozess viel früher und schneller ablaufen zu lassen.

3. Der Markt für kognitive Lösungen wird ausgebaut werden:

- Die deutlich höhere Performance von Flash im Vergleich zur drehenden Disk wird die Bedeutung von Storage für kognitive Apps aufzeigen. Eine bleibende Herausforderung liegt innerhalb des gesamten I/O-Stacks („Applikation-Server-Infrastruktur-Storage“); anders als die Prozessorleistung hat die Storage-Latenzzeit nicht ähnliche Fortschritte gemacht, auch wenn Flash natürlich schneller ist... Die Proliferation des NVMe-Protokolls soll deshalb die Engpässe (latency) im I/O-Stack erheblich reduzieren und einen Pfad für einen zuverlässig schnellen Zugriff auf Daten freimachen.

4. Software Defined Storage (SDS) wird sich mit Cloud Computing verbinden:

- Im Jahr 2017 wird die Nachfrage exponentiell wachsen, in dem SDS und Hybrid-Clouds miteinander verbunden werden. SDS wird reif genug sein, um Software-Stack sowohl on-premise als auch in der Cloud laufen zu lassen, während mithilfe eines Control Panels die Software miteinander verbunden wird. Mit der Möglichkeit, Datendienste on-premise und in der Cloud auszuführen, können Unternehmen DevOps und Tests in der Cloud durchführen. Dies ermöglicht es Nutzern, eine Kopie der Daten zu nehmen bzw. diese in verschiedene SDS-Cluster zu legen, eine Momentaufnahme (Snapshot) der Daten zu erzeugen und dort wo es nötig ist, direkt zu verteilen (Beispiel Autoindustrie…).

5. Die kombinierte Nutzung von Objektspeichern, der Cloud-Plattform und Cognitive wird sich etablieren:

- Mit einem Gesamtinhalt von 44 Zettabyte bis 2020, wobei 80% davon unstrukturiert sind bietet sich Anbieterseitig eine große Chance, die durch das Trio aus Objektspeicher, Cloud-Plattform und Cognitive bestimmt wird. Diese Technologien werden eingesetzt, um Innovationen in einem breiten Spektrum an Branchen, wie beispielsweise Versicherungen, Banken, Biowissenschaft, Medien / Unterhaltung, Energie, Spielindustrie, Virtual Reality oder Handel voranzutreiben.

6. Neben File- und Block-Speicher werden sich Objektspeicher zur dritten Plattform entwickeln:

- Mehr und mehr Kunden werden ihre eigenen Objekt-Storage-Repositories installieren und beginnen, diese als private Cloud zu betreiben - quasi wie eine „eigene“ Public Cloud, um deren Funktionen im RZ kosteneffizient und flexibel abzubilden.

7. Rechenzentren werden von Hochleistungsrechenzentren lernen:

- Neue Workloads benötigen künftig eine extrem leistungsfähige und skalierbare integrierte Architektur - bare-metal compute nodes, 1000 Cores, 200TB Speicher, Image-Deployment, Workload Scheduling - mit einem Klick! Das geht weit über klassische hyperkonvergente Systeme hinaus. Gefordert ist künftig ein integriertes Webscale- und End-to-End-Ressourcenmanagement über einen darüber ablaufenden Workload-Sheduler (siehe z.B. IBM spectrum conductor sds); weitere Entwicklungen im Zusammenhang mit docker, hadoop, spark integration, life-cycle mgmt. etc. sind in Planung, ebenso wie persistenter, skalierbarer Storage für IBM SVC (block storage virtualization)...

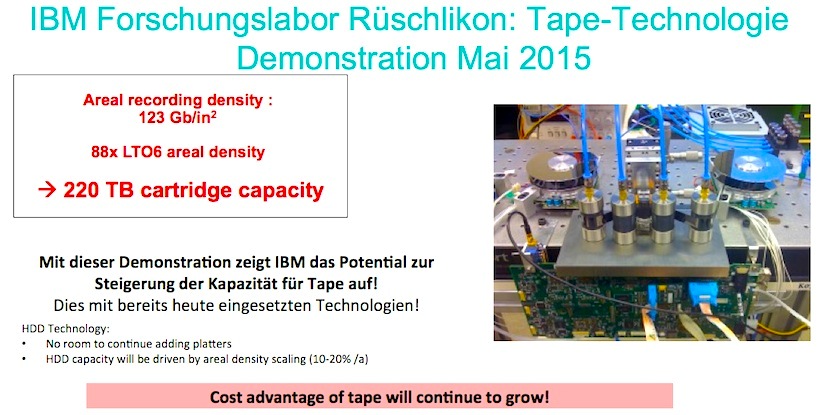

8. Tape ist da, aber Sie sehen es nicht!

Cold Storage ist das neue Paradigma in der Cloud, weil die erzeugten Daten auf eine effizientere, sicherere und weniger Energie-intensive Weise gespeichert werden können. Tape spielt dabei nicht nur im Exabyte-Bereich (MS Azure...) nicht zuletzt aus Kostenaspekten eine zunehmend wichtigere Rolle (Randbedingungen: Faktor 8 – 10 zu HDD / 2020 ca. 80TB disk; bereits 60 TB (!) flash in 2017 / 20% p.a. Preisverfall).

Abb. 1: Tape Drive Development (Bildquelle: IBM, Josef Weingand und Forschungszentrum Rüschlikon b. Zürich)