Wien, Starnberg, 04. Febr. 2022 - Neue EU-Richtlinien verlangen, dass von KI getroffene Entscheidungen nachvollziehbar sind. Für neuronale Netze ist das ein Problem...

Zum Beitrag: Der Informatiker Andreas Holzinger leistet Pionierarbeit im Bereich des interaktiven maschinellen Lernens, um bessere Nachvollziehbarkeit zu gewährleisten. (1) Für seine Leistungen wurde er nun zum Fellow der International Federation of Information Processing (IFIP) gewählt. „Es gab früher dieses geflügelte Wort“, erzählt Andreas Holzinger. „Sie gehen zu Ihrem Bankberater, weil Sie einen Kredit wollen. Der Berater schaut auf seinen Bildschirm und sagt Ihnen, dass Sie den Kredit nicht bekommen. Wenn Sie fragen, warum, antwortet er: Der Computer sagt das.“ Der Forscher spricht damit ein Problem an, das zwar seit Langem besteht, aber in letzter Zeit aufgrund der großen Erfolge von künstlicher Intelligenz (KI) durch neuronale Netze in den Hintergrund trat.

Inzwischen erkennen Algorithmen in Autos Verkehrszeichen, Mobiltelefone verstehen unsere Sprache und Übersetzungstools liefern verblüffend genaue Ergebnisse – all das völlig autonom, ohne Einbindung von Menschen. In gewissen Anwendungsbereichen, wie etwa der Medizin, wirft dieser „vollautomatische“ Zugang jedoch zunehmend rechtliche und ethische Probleme auf. Wie der Mensch wieder Teil des Entscheidungsprozesses werden kann, daran forscht Andreas Holzinger an der Medizinischen Universität Graz in einem vom Wissenschaftsfonds FWF finanzierten Projekt.

Erfahrung und Verständnis des Menschen einbeziehen

Die Probleme seien hausgemacht, erklärt der Informatiker: „Vor ziemlich genau zehn Jahren habe ich an der Carnegie Mellon University in den USA, einer Top-Uni im Bereich der KI, einen Vortrag gehalten und die Idee propagiert, den Menschen bei KI-Anwendungen einzubinden.“ Doch die Rückmeldung der Forschungsgemeinschaft sei enttäuschend gewesen, so Holzinger: „Man wollte damals alles vollautomatisch machen – ohne Einbeziehung eines Menschen.“ Mit der Zeit wurden neuronale Netze immer leistungsfähiger, aber auch immer komplexer und damit „undurchsichtiger“. Das liegt daran, dass sie nicht von Menschen programmiert werden, sondern autonom aus riesigen Datenmengen lernen. Ein Nebeneffekt dieses Zugangs ist, dass es in der Regel nicht mehr so einfach nachvollziehbar ist, wie die Algorithmen zu ihren Entscheidungen gelangen.

Neue EU-Datenschutzrichtlinien sorgen für ein Umdenken

- „Die EU-Datenschutzgrundverordnung enthält sinngemäß ein Recht auf Erklärbarkeit. Wenn also eine autonome KI ihren Kredit nicht genehmigt, haben Sie das Recht zu fragen, welche die zugrunde liegenden Kriterien sind, auf denen diese Entscheidung beruht“, so Holzinger. Für die KI-Entwickler:innen ist das allerdings ein Problem, denn darauf war die Forschungsgemeinschaft, die bisher vor allem an Algorithmen für automatische und autonome Entscheidungen gearbeitet hat, wenig vorbereitet.

Eine Lösung verspricht das Feld der „erklärbaren künstlichen Intelligenz“

- Damit sollen KI-Entscheidungen nachvollziehbarer werden. In diesem Bereich wird aktuell intensiv geforscht. Eine Variante der erklärbaren KI ist die Implementierung der Möglichkeit, "Wenn-dann"-Fragen zu stellen. Dazu ist es nötig, sogenannte Counterfactuals, also fiktive "Was-wäre-wenn"-Annahmen zu machen und so Entscheidungsprozesse zu hinterfragen. Doch dafür braucht es interaktive Nutzerschnittstellen, die solche Eingriffe erlauben. Für diese müsse man eine Idee davon haben, wie gut Erklärungen von Entscheidungsprozessen sind, betont der Informatiker.

Wie gut ist die Erklärung?

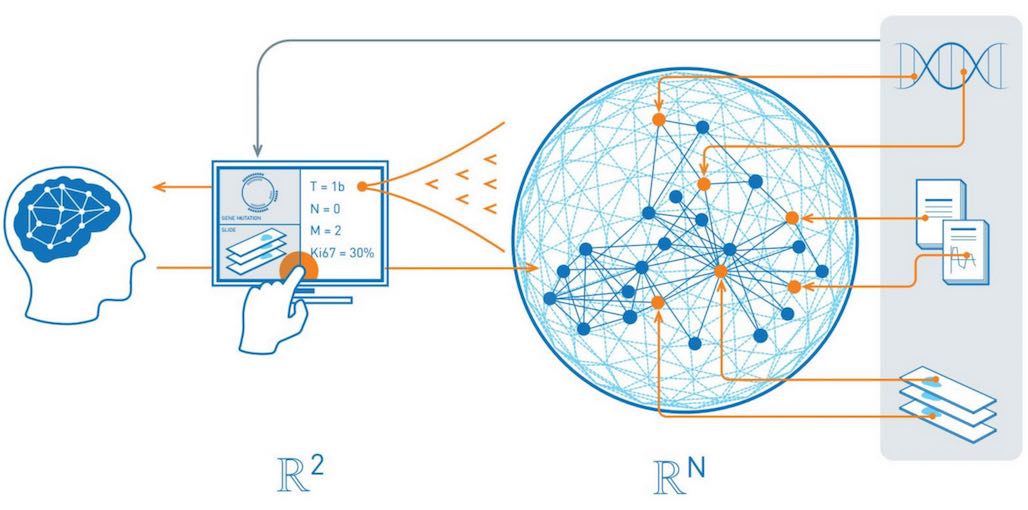

„Das ist ein Schwerpunkt unserer Arbeit. Wir haben das Konzept Causability entwickelt, das über reine technische Explainability hinausgeht“, berichtet der Forscher. Es gehe darum, nicht nur technisch entscheidungsrelevante Teile von Erklärungen zu liefern, sondern auch ihre Qualität zu beurteilen. Causability, am besten als „Ursachenerkennbarkeit“ zu übersetzen, bezeichnet danach das messbare Ausmaß, in dem eine Erklärung bei menschlichen Expert:innen Verständnis in einem bestimmten Nutzungskontext erreicht. Dabei kann es nicht eine universelle „Erklärung“ für alle geben. Um etwa abhängig vom individuellen Vorwissen ein konzeptuelles Verständnis zu ermöglichen, müssen Erklärungen auch adaptierbar sein, was weitere Nutzerinterfaces nötig macht.

Findet ein Umdenken in der KI-Forschung statt? Die erklärbare künstliche Intelligenz will den Menschen wieder mehr ins Zentrum rücken. Bildquelle: Human-Centered AI Lab

Holzinger und sein Team wenden die gewonnenen Erkenntnisse danach unter anderem für medizinische oder biologische Aufgabenstellungen an, wo Erklärbarkeit der Ergebnisse einen besonderen Stellenwert haben. Der Forscher betont aber den allgemeinen Charakter seiner Arbeit im Rahmen dieses Grundlagenprojekts. Biologie und Medizin seien wichtige Anwendungsbereiche, aber: „Die Ergebnisse sind auch für die Land- und Forstwirtschaft, die Klimaforschung oder sogar die Zoologie anwendbar.“ Der Forscher erwartet sich nicht nur bessere Einsicht in KI-Techniken, er stellt auch in Aussicht, dass diese so längerfristig robustere Ergebnisse liefern, weniger voreingenommen sind und auch weniger Daten zum Training brauchen könnten. „Unsere Arbeit ist generisch, deshalb wird sie international auch so gut angenommen“.

Der Mensch im Zentrum

Eine Prognose, wie sich KI in Zukunft entwickeln wird und wie zum Beispiel neuronale Netze unseren Alltag verändern werden, wagt Holzinger nicht, aber er äußert einen Wunsch: dass ein ganzheitlicher Ansatz für künstliche Intelligenz gefunden wird, in dessen Zentrum der Mensch steht, und dass nicht nur Kompetenzen wie kontextuelles Verstehen – Holzinger nennt es „Hausverstand“ – in Computermethoden eingebracht werden, sondern auch soziale, ethische und rechtliche Aspekte. Alles unter dem von ihm geprägten Begriff „Human-Centered AI“, mit dem Ziel, künstliche Intelligenz mit menschlichen Werten, ethischen Grundsätzen und rechtlichen Anforderungen in Einklang zu bringen.

(1) Zur Person: Andreas Holzinger ist Informatiker und Leiter des Labors für Human-Centered AI (menschenzentrierte künstliche Intelligenz) an der Medizinischen Universität Graz. Seit 2019 ist er Gastprofessor für erklärbare KI am Alberta Machine Intelligence Institute der Universität Alberta in Edmonton, Kanada und seit Kurzem Fellow der International Federation of Information Processing (IFIP). Das Projekt Ein Referenz-Modell für Explainable AI in der Medizin, das 2019 startete, hat nach vorliegenden Angaben eine geplante Laufzeit von vier Jahren und wird vom Wissenschaftsfonds FWF mit 393.000 Euro gefördert.

Publikationen

Pfeifer B., Secic A., Saranti A., Holzinger A.: GNN-SubNet: disease subnetwork detection with explainable Graph Neural Networks, in: bioRxiv (Preprint) 2022

Holzinger A., Malle B., Saranti A., Pfeifer B.: Towards Multi-Modal Causability with Graph Neural Networks enabling Information Fusion for explainable AI, in: Information Fusion, Vol. 71, 2021

Holzinger A., Carrington A., Mueller H.: Measuring the Quality of Explanations: The System Causability Scale (SCS). Comparing Human and Machine Explanations, in: KI – Künstliche Intelligenz, Vol. 34, 2020.

Querverweis: