München, Starnberg, 05. Aug. 2020 - Optimierte Systemplattform für Big Data Apps; Speichersilos aufbrechen und Daten schneller in Wettbewerbsvorteile transformieren...

Zum Hintergrund: Wenn Unternehmen bei der Entwicklung & Bereitstellung datenbasierter Anwendungen zur Entscheidungsfindung einen möglichst raschen geschäftlichen Nutzen (sichtbare Wertschöpfung) erzielen wollen, sind agile und automatisierte Herangehensweisen beim Datenmanagement notwendig. Dabei stellt jedoch eine Flut an semi- und unstrukturierten Daten aus unterschiedlichsten Quellen (Cloud, on-premise, edge) die IT- und Beschaffungsverantwortlichen vor diverse Herausforderungen. Dies betrifft sowohl die Verwaltung der Speicher- und Analyseinfrastruktur, als auch eine zeitnahe Wertschöpfung der Investitionskosten unter Einbeziehung von Ausgaben für den Betrieb (OpEx/TCO).

Objektspeichersysteme als moderne Alternative zur kosteneffizienten Speicherung und Plattform für die Analyse auch sehr großer Datenmengen (BDA):

Geeignete Objektspeicherlösungen wie Quantum ActiveScale (1) bieten Unternehmen eine hochskalierbare Plattform zum Aufbau von Data Lakes im PB-Bereich - optimiert hinsichtlich TCO, Performance, Skalierbarkeit und Zuverlässigkeit. Im Gegensatz zu vielen existierenden Data Lake - Architekturen mit einer Vielzahl von eingesetzten Technologie-Plattformen ermöglicht ActiveScale laut Anbieter eine direkte lokale Ausführung von Analysen, indem die performante HDFS-Analyseebene und der Massendaten-Speicher miteinander kombiniert werden.

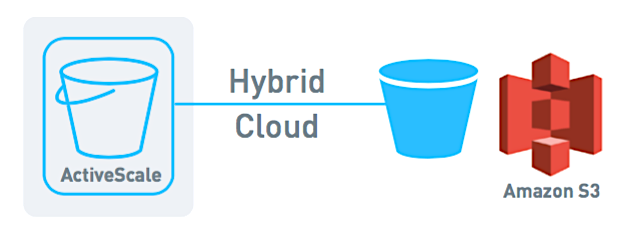

Die Fähigkeit, Daten in beiden Richtungen über einen S3A-Connector zwischen den Speicher-Tiers zu verschieben, ist für die kosten- und zugriffsoptimierte Auslastung der Ressourcen verantwortlich (siehe Abbildung).

Abb. 1: ActiveScale Hybride Cloud-Replikation auf AWS (Bildquelle: Quantum)

Vorteile einer BDA-Umgebung mit Quantum ActiveScale:

Datensilos eleminieren - Die Lösung basiert auf einem ActiveScale-Objektspeicher**. Der Data Lake fungiert als einheitliches Archiv zur Bereitstellung der Big Data - Speicherkapazitäten; ineffiziente Datensilos werde nicht mehr benötigt. Die Lösung wurde laut Hersteller von Grund auf für spezifische BDA-Anforderungen konzipiert und bietet Enterprise-Funktionalitäten wie Data Lifecycle-Management (DLM), Erasure Coding (anstelle von RAID) zur Sicherung der Systemverfügbarkeit sowie Geo-Redundanz für Business Continuity.

Lokale Analysen ermöglichen - Analysen lassen sich lokal ausführen, d.h. übermäßige Datenverschiebungen und ETL-Overheads können vermieden werden. Weniger Datenverschiebungen und reduzierte redundante Datenkopien erlauben Effizienzsteigerungen und eine schnellere Rendite auf das eingesetzte Kapital.

Investitionsschutz beim Big Data Speicher - Anwender sind mit ActiveScale laut Entwickler nicht an ein proprietäres Dateisystem oder teils kostspielige-/komplexe Data Warehouse-Implementierungen gebunden. Somit lassen sich die Investitionen in BDA-Technologien absichern und in Wettbewerbsvorteile verwandeln.

Ein Fazit: Unternehmen und Organisationen, die gerade hohe Betriebskosten für einen Public Cloud-Dienst erfahren, erhalten mit ActiveScale Objekt Storage eine interessante Alternative. Folgt man den Analysen des Herstellers, ist die TCO beim Aufbau eines Petabyte-großen Data Lakes in einer privaten oder hybriden Cloud mit den Kosten führender Public Cloud-Anbieter vergleichbar und liegt oft sogar darunter (Quelle: http://www.quantum.com/objectstorage).

Anmerkung: Siehe auch unser Beitrag > Die Kosten von Cloud Storage im Bereich der Langzeit-Datenspeicherung.

Abb. 2: Das Foto zeigt einen ActiveScale X100–Speichereinschub (Bildquelle: Quantum Corp.)

(1) Quellen & weitere Querverweise:

**Unser Beitrag > Quantum Corp. übernimmt Western Digitals ActiveScale™ Objektspeicher-Portfolio.

Unser Beitrag > Erfolgreiche Big Data Strategien, oder warum viele Daten alleine nicht zum Ziel führen.

Unser Beitrag > Data Lakes: Wie sie funktionieren und Unternehmen von ihnen profitieren können.

Unser Beitrag > Neue Splunk-Studie zum wirtschaftlichen Wert von Daten mit Data-Maturity-Rechner.