München, Starnberg, 25. Jan. 2018 - Fünf zentrale Kriterien zum Aufbau und Betrieb eines Next Generation Data Center (NGDC). Ein Gastbeitrag der Firma NetApp...

Zum Hintergrund: Unternehmen befinden sich gerade an einem Wendepunkt, denn die Geschäftsentwicklung erfolgt zunehmend nicht mehr linear. Stattdessen können sich Chancen jederzeit aus allen und in alle Richtungen auftun. Unternehmen brauchen somit mehr Flexibilität, darauf möglichst umgehend reagieren zu können. Mit einem traditionellen Rechenzentrum auf Basis isolierter Techniksilos ist das nicht in dem geforderten Umfang möglich. Starre IT-Strukturen sind eher ein Bremsklotz, weil a) die Komplexität steigt und b) jede Änderung viel Zeit und Ressourcen kostet.

Die erste Generation an hyperkonvergenten Infrastrukturen (HCI), die das Thema adressierte, ist nun bereits seit einigen Jahren auf dem Markt. Sie bringt jedoch noch Einschränkungen mit sich: Ein Hauptproblem besteht darin, dass die Systeme nicht für mehrere, parallele Anwendungen ausgelegt sind, also entsprechend skalieren. HCIs der ersten Generation bieten vorallem keine Möglichkeit, einzelnen Anwendungen garantierte Ressourcen zuzuweisen, d.h. für Quality of Service zu sorgen. Damit Unternehmen HCI's aber auch im größeren Stil effizient einsetzen können, Silobildungen vermeiden und Kosten sparen, müssen HCI-Systeme die Anforderungen an ein Next Generation Data Center (NGDC) erfüllen. Dies jedenfalls ist die Meinung von Johannes Wagmüller (1), Director Solutions Engineering bei NetApp, der uns in seinem folgenden Gastbeitrag aufzeigen wird, welche Entwicklungsfortschritte die zweite HCI-Generation erreicht und woran sich der Betrieb eines modernen Rechenzentrums heute und künftig messen lassen muss.

1. Anforderungen und Aufbau einer HCI-Lösung

"Die wesentliche Anforderung an ein Next Generation Data Center (NGDC) ist umfassende Flexibilität. Diese erreichen Unternehmen durch über Software konfigurierbare Lösungen. Wie diese in der Praxis leistungsfähig dargestellt werden können, veranschaulicht die neue HCI-Lösung von NetApp. Basierend auf Solidfire All Flash Storage, x86 Compute Nodes und VMware ESXi integriet NetApp HCI verschiedene eigene Daten-Services sowie solche von Drittanbietern – darunter Hochverfügbarkeit, Replikation, Reduktion sowie Backup und Recovery. Weitere Lösungen von anderen Herstellern lassen sich per API anbinden und damit automatisieren.

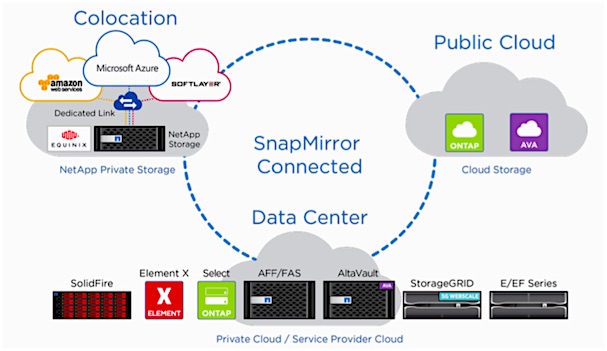

Wer darüber hinaus seine HCI in eine hybride Datenmanagementplattform integriert, gewinnt im IT-Betrieb weiter an Effizienz. Bei NetApp heißt das Konzept "Data Fabric". Damit lassen sich Daten komfortabel zwischen verschiedenen Infrastrukturen und Speicherorten verschieben. So werden moderne Hybrid-Cloud- und Multi-Cloud-Umgebungen unterstützt.

Abb. 1: NetApp Data Fabric - Architecture Fundamentals, Deployments Models (Bildquelle: Joe CaraDonna, Arthur Lent. NetApp March 2017 | WP-7218)

2. Einfache Installation, einfacher Betrieb

Für eine einfache Inbetriebnahme einer HCI steht ein Deployment Engine zur Verfügung, der das System innerhalb von 30 Minuten in die bestehende Umgebung integriert. So ist eine hochautomatisierte, einfache Installation in deutlich weniger als einer Stunde, vom Auspacken bis zum ersten Service, möglich. Für das zentrale Management aller HCI-Komponenten während des späteren Betriebs wird die VMware vCenter-Konsole genutzt, die den meisten IT-Verantwortlichen vertraut ist.

3. Flexible Skalierung

Entscheidend für eine flexible Infrastruktur ist, dass Speicher- und Rechenknoten unabhängig voneinander skaliert werden können. HCIs erlauben genau dies: Compute und Storage Nodes können je nach Bedarf hinzugefügt werden, sodass das System flexibel in beide Richtungen skaliert. IT-Verantwortliche vermeiden dadurch Überprovisionierung und sparen Hardware-, Wartungs-und Lizenzkosten.

4. Quality of Service

Ein weiterer wichtiger Aspekt für eine flexible Skalierung ist garantierte Quality of Service. IT-Verantwortliche können jeder Applikation einen Minimalwert, einen Maximalwert und einen Burst-Wert an IOPS zuweisen. Der Minimalwert legt die Leistung fest, die die Anwendung in jedem Fall zur Verfügung hat. Sie wird nie unterschritten. Das verhindert, dass ressourcenhungrige Applikationen die Performance beeinträchtigen und stellt einen ungestörten Betrieb sicher. So sind Unternehmen in der Lage, auch viele unterschiedliche Applikationen parallel auf der HCI zu betreiben. Sie sparen damit Hardware-Kosten und vermeiden Silobildung.

5. Selbstheilung des Systems

Das HCI-Betriebssystem hat idealerweise die Fähigkeit zur Selbstheilung, denn nur so kann die Hochverfügbarkeit des Systems gewährleistet werden. Diese wiederum ist wichtig um sicherzustellen, dass der Ausfall von Einzelteilen – entweder von SSDs oder auch ganzen Storage Nodes – zu keinen Unterbrechungen führt und der redundante Betrieb nach kurzer Zeit automatisch wiederhergestellt wird.

Fazit: Die Systeme haben Zukunft

HCI der zweiten Generation können bestens auf dem Weg der Digitalisierung unterstützen. Durch deren Einsatz bewegen sich Unternehmen einen weiteren Schritt in Richtung Next Generation Data Center. HCI ermöglichen es, Rechenleistung und Speicher separat voneinander zu skalieren und mehrere Applikationen gleichzeitig auf demselben System zu betreiben. Dadurch sparen Unternehmen Kosten und erhalten noch mehr Flexibilität. Dazu kommen ein einfaches Management und ein hoher Grad an Automatisierung. Die Frage, wie man sich die Cloud-Vorteile ins eigene Haus holen kann, braucht daher kein Unternehmen mehr umtreiben. Die Antwort liegt auf der Hand – und sicher lange im Trend: Mit hyperkonvergenter Infrastruktur lässt sich der IT-Betrieb zukunftsfähig aufstellen."

Foto: Johannes Wagmüller, Director Solutions Engineering, NetApp Germany (Quelle: NetApp)