Starnberg, 27. Sept. 2019 - Weshalb NAND Flash, Storage Class Memory (SCM) und hochparallele Speicherarchitekturen wichtige Aspekte einer KI-Infrastruktur sind...

Um was es hier geht: Cloud-basierte KI-Lösungen sind auf dem Vormarsch. Nicht verwunderlich, denn die weltweit bekannten "Hyperscaler" liefern inzwischen ein umfangreiches und an konkreten Anwendungsfällen ausgerichtetes Angebot aus der Cloud (public), teils zu sehr wettbewerbsfähigen Preisen. „KI für alle“, sozusagen... aber das ist natürlich sehr vereinfachend. Grundsätzlich muss zwischen den Anforderungen großer Unternehmen wie z.B. aus der Versicherungswirtschaft, Chemie-, Automobilbranche oder Finanzdienstleistern mit eigenem Know-How in den Organisationen / Rechenzentren (on-premise) und den Problemstellungen kleinerer Mittelständler (mit geringen Ressourcen und weniger Budget) unterschieden werden; auch wenn vor-Ort und-/oder über Dienstleister technologisches- wie auch branchenspezifisches Wissen vorhanden sein muss, denn es werden wohl auch künftig nicht alle KI-Anwendungen in der Public Cloud ausgeführt. Hier ist die Firmenleitung als "Sponsor" und natürlich neben der Fachabteilung die IT gefordert, Know-how und adequate Infrastrukturlösungen bereitzustellen. Dies gilt insbesondere für den Storage und hybride (cloud-) Datenmanagementlösungen. Hierzu einige Gedanken...

Datenwissenschaftler von Unternehmen und Organisationen verbringen gerade viel Zeit damit, geeignete Daten zu verwalten und aufzubereiten, um repräsentative Datasets zu erstellen. Leider fehlt dazu oft genug eine wichtige Vorbedingung = Datenklassifizierung, um überhaupt brauchbare Basisdaten für KI-Projekte bereitstellen zu können. Zum zweiten ist die Datenverwaltung - zusammen mit der Speicherung (Storage) leider unterbewertet (Budget, spezifisches Know-how, Ressourcen, Fokussierung etc.), was eine erfolgreiche Umsetzung von KI-Initiativen nicht gerade einfacher macht. Moderne Storage-Technologien leisten aber in Bezug auf Speicherleistung und Kapazität viel mehr, was sich wiederum auf alle wesentlichen Aspekte von KI-Projekten wie Datenpflege und -Management bis hin zum Datenbanken-Design selbst positiv auswirken kann.

Storage Class Memory und die derzeit in Stückzahlen verfügbare 3D XPoint - Variante, Intel Optane™ DC Persistent Memory (bei Micron QuantX™) ist Hardwareseitig ein entscheidender Faktor zum Aufbau von modernen Speicher- und Datenmanagement-Architekturen. Der I/O-performanceseitige Grund liegt in der „Random“ I/O Leseleistung bei geringer Warteschlangentiefe (queue depth). Random Reads stellen in der Regel rund 75% aller Transaktionen dar und sind damit eine wichtige Performancekennzahl.

Um bei unserem Thema zu bleiben... Bei Deep Learning (DL) z.B. bedeutet ein langsamer Speicher auch eine langsamere maschinelle Lernleistung, denn das Deep Neural Network stellt ein Abbild eines massiv parallelen vernetzten Modells dar, bei dem Millionen bis Milliarden von Neuronen lose miteinander verbunden sind, um ein einziges Problem zu lösen. GPUs wiederum sind massiv parallele Prozessoren, bei denen jeder einzelne aus Tausenden von lose gekoppelten Rechenkernen besteht, um eine 10x bis 100x höhere Leistung als eine Standard CPU zu erzielen.

Es ist offensichtlich, dass für anspruchsvolle KI- und DL Systeme eine neue Generation von Speichersystemen erforderlich wird, um GPU-Systemen eine entsprechend hohe "Ingest"-Bandbreite für zufällige (random) Zugriffsmuster von kleinen bis großen Files zu liefern.

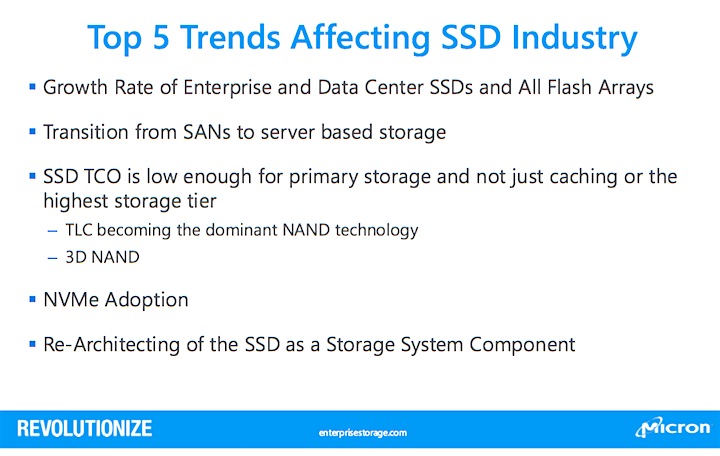

Abb. 1: Top 5 Trends Affecting SSD Industry. Aus: Revolutionizing the Data Center (Bildquelle: Micron Technology).

Zufällige Leseleistung bei geringer Warteschlangentiefe ist bislang jedenfalls ein Bereich, bei dem NAND Flash SSDs / Flash JBODs allein (ohne Caching) nicht optimal liefern. Intel Optane™ Memory z.B. liefert laut Specs die 5- bis 10-fache Leistung von Flash-basierten SSDs in einer random read queue depth von 1-4. Die Leistung von Speichersystemen wird mit SCM somit stark beeinflusst und dies wiederum hilft beim Design von parallelen high-performance KI-Infrastrukturen. Die SCM-Technologie mit 3D X-Point ist potentiell bis zu 1000x schneller und 1000x dauerhafter als ein normaler NAND-Flash-Speicher, sodass der limitierende Faktor heute entweder der PCI-Bus im Server (falls dazu benutzt) oder das SATA/SAS Interface der SSD ist. NVMeoF und RDMA über InfiniBand oder 100 GBE für skalierbare Speicherpools sind Hardware- und Protokollseitig aus Storagesicht derzeit die geeigneten Protokolle für Low-latency High Performance I/O - Architekturen; ideal im Verbund mit NAND (Kosten) und SCM (Leistung, Haltbarkeit).

Ein Fazit

Distributed Direct Attached (DAS) oder klassischer SAN Storage skalieren bei KI Apps mit massiven Datensätzen nicht in der gewünschten Weise (Komplexität, Leistung, Latency, OPEX, CAPEX). Hochparallele Architekturen (I/O Systeme, Storage Class Memory, Filesystem Software, Hochleistungsfabrics wie NVMeoF etc.) werden damit wichtig.

Querverweis: