CAMPBELL (CA), Starnberg, 23. März 2021 - Speicherleistung mit NVIDIA GPUs ausschöpfen; Time-to-Value für KI/ML auf Basis von Hochleistungs Filesystem-Storage...

Zum Beitrag: WekaIO™ (Weka), Datenplattform für künstliche Intelligenz/Machine Learning (AI/ML), Life-Science-Forschung, technisches Computing in Unternehmen und High-Performance Data Analytics (HPDA), hat gestern die Ergebnisse eines gemeinsam mit Microsoft durchgeführten Performance-Tests bekanntgegeben. Danach konnte das Weka File System (WekaFS™) mit die höchsten aggregierten NVIDIA® Magnum IO GPUDirect® Storage-Durchsatzzahlen aller bisher getesteten Speichersysteme erzielen. Weka adressiert Speicherherausforderungen, wie sie bei I/O-intensiven Workloads, wie z. B. künstlicher Intelligenz (KI), auftreten. Die Lösung liefert hohe Bandbreite, niedrige Latenz und Single-Namespace-Transparenz für die gesamte Datenpipeline.

Die Tests wurden bei Microsoft Research mit einem einzelnen NVIDIA® DGX-2™-Server* durchgeführt, der über einen NVIDIA Mellanox InfiniBand-Switch mit einem WekaFS-Cluster verbunden war. Die Ingenieure von Microsoft Research konnten in Zusammenarbeit mit WekaIO und NVIDIA danach einen der höchsten Durchsatzwerte in den getesteten Systemen mit den 16 NVIDIA V100 Tensor Core GPUs erreichen. Diese hohe Leistung wurde erreicht und verifiziert, indem das NVIDIA gdsio-Dienstprogramm mehr als 10 Minuten lang ausgeführt wurde und laut Testergebnis über diesen Zeitraum eine konstante Leistung zeigte.

WekaFS selbst repräsentiert ein POSIX-konformes, paralleles Hochleistungs-Dateisystem, das entwickelt wurde um potentielle Beschränkungen herkömmlicher Dateisysteme (die lokalen Speicher, NFS oder Blockspeicher nutzen) zu überwinden. Damit ist es laut Anbieter ideal geeignet für datenintensive KI- und High-Performance-Computing-Workloads.

WekaFS integriert NVMe-basierten Flash-Speicher auf der I/O-Leistungsebene mit GPU-Servern, Objektspeicher und Interconnect-Fabrics mit extrem niedriger Latenz innerhalb einer NVMe-over-Fabrics-Architektur und repräsentiert damit eine extrem leistungsstarke Scale-out-Speichersystem-Umgebung, Die Leistung von WekaFS skaliert linear, wenn weitere Server zum Speichercluster hinzugefügt werden, so dass die Infrastruktur mit den steigenden Anforderungen des Unternehmens wachsen kann.

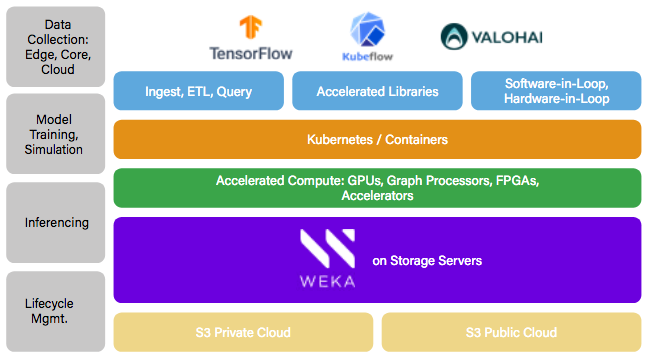

Abb. 1: Weka AI Solutions framework that enables Accelerated DataOps from the Edge to Core to Cloud (Bildquelle: Weka)

Link > https://www.weka.io/solutions/ai-analytics/

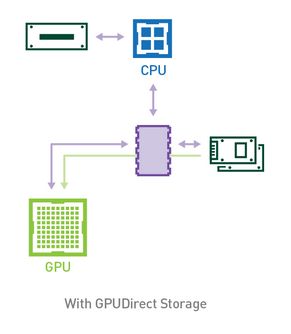

Abb. 2: GPUDirect Storage: A Direct Path Between Storage and GPU Memory (Bildquelle: NVIDIA Developers Blog)

Link > https://developer.nvidia.com/blog/gpudirect-storage/

Kommentar Jim Jernigan, Principal R&D Systems Engineer bei Microsoft Corp.: "Die Tests wurden auf einem System durchgeführt, auf dem WekaFS in Verbindung mit mehreren NVIDIA DGX-2-Servern innerhalb einer Staging-Umgebung eingesetzt wurde. Dabei konnten wir den höchsten Durchsatz aller bisher getesteten Speicherlösungen erzielen“.

*Anmerkung zum Test / Quelle Weka: Der NVIDIA DGX-2-Server verwendete hier eine nicht standardkonforme Konfiguration mit Single-Port-NICs, die durch Dual-Port-NICs ersetzt wurden.

Querverweis:

Unser Beitrag > Energieeffiziente KI-Anwendungen sind gefragt: Neuer Entwicklungsansatz vorgestellt

Unser Beitrag > Active Archiving mit WekaIO: Quantum lädt zur virtuellen Seminarreihe VirtualQ Protect & Archive