Starnberg, 27. März 2018 - Zukunftsfähige Speicherlösungen sind Datenmanagement- und Cloud-fokussiert, aber nicht Storagemedia-zentriert...

Um was geht es? Fast schon eine Binsenweisheit: Nicht die Technologie per se soll den Wert der IT bestimmen, sondern der Impact auf das Business (ROI, Value Contribution). Das sagt sich einfach, ist es aber mitunter nicht... Denn am Beispiel aktueller Entwicklungen wie hybriden Clouds, Data Analytics im Kontext KI und IoT im Schatten der vielstrapazierten Digitalen Transformation zeigt sich, wie zentral und gleichzeitig komplex moderne IT-Infrastrukturen werden können, und wie dynamisch sich technologische Entwicklungsdetails beschleunigen. Schwierig - auch zunehmend für Experten - hier den Überblick zu behalten bzw. sich nicht zu sehr in technischen Tiefen zu verlieren; dies gilt besonders für das unternehmensweite Speicher- und Datenmanagement, welches auf Grund von hybriden- und Multi-Cloud Deployments künftig noch mehr in den Fokus von Unternehmen rücken wird (Data = Business Value).

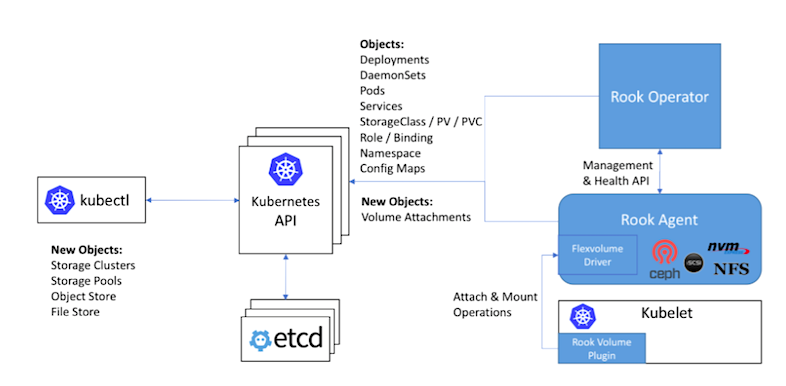

Aufgrund einer zwischenzeitlich hochgradigen Virtualisierung und „Cloudifizierung“ von Infrastrukturen und Unternehmen-/Anwendungen ist die Automatisierung bei gleichzeitig Vereinfachung, wo immer möglich, angesagt. Mittels SDN, SDS, Container, agilen SW-Entwicklungsmethoden usw. wird jedoch die Komplexität gerne auch erhöht (Beispiel: höhere Packungsdichte bei Containern gegenüber VMs um den Faktor 100), also Vordergründig das Gegenteil erreicht. Weiteres Beispiel: die automatisierte Verwaltung im „Mode 2“ (DevOps) via Docker, Kubernetes & Co ist ein Muss. Hier kommen im Zusammenhang mit Persistent Storage, Stateless Containers und dem Backup-/Recovery neue Anforderungen auf die Teams zu, die sowohl spezielles Lösungs-Know-how & Produkte verlangen, als auch zeitliche-/personelle Aufwendungen und damit Kosten verursachen.

Die Gartner CIO-Studie 2017 zeige, dass 43% der darin befragten (großen) Unternehmen eine bi-modale IT einsetzen, was einer Steigerung gegenüber den 38% im Jahr 2016 entspricht (1). Zitat: Obwohl die meisten bi-modalen Organisationen klare Vorteile erkannt haben „wie engere Zusammenarbeit zwischen Business und IT","mehr Innovation", "verbesserte Wahrnehmung der IT durch das Unternehmen" und "schnellere Markteinführung", zeigen sie auch die gestiegenen Kosten für die bimodale IT auf, z.B. über "technische Probleme", "zusätzliche Anzahl der Mitarbeiter, um das Mode 2-Programm zu starten" und ein „cultural change“.

Hinweis: Mehr zu den Themen "Cloud-native Storage, Data Protection, Software Defined File-, Block- und Object Storage etc." erfahren Sie „live“ und aus erster Hand von ausgewiesenen Industrie-Experten im Rahmen der 19. Anwendertagung des Storage Consortium am 20. Juni 2018 in Frankfurt/M. auf dem Gelände von e-shelter, inklusive Führung durch das Innovation-Lab. Interessiert? Bitte einfach in den Storage Consortium Newsletter eintragen; Sie erhalten Sie über diesen Weg dann zeitnah alle nötigen Infos zur Tagung mit Agenda. Link > https://storageconsortium.de/content/content/fachkonferenzen-des-storage-consortium

Beispiel IoT: Diese Entwicklung besitzt das Potenzial, bestehende Datensilos in ein modernes, direkt vernetztes System digitaler Workflows zu verwandeln, das Anwendern einen sofortigen Prozessüberblick und damit Reaktionsfähigkeit in Echtzeit liefert. Vorausgesetzt natürlich, auf der Infrastrukturseite sind entsprechend leistungsfähige Systeme und Data Management Plattformen vorhanden (neben Netzen, Speicher, CPU etc.).

Bis 2021 sollen nach Marktforschern wie Gartner zudem mehr als 80% der unstrukturierten Unternehmensdaten in skalierbaren Dateisystemen und Objektspeichersystemen bei Unternehmens- und Cloud-Rechenzentren gespeichert werden (1), was eine direkte Folge der geschilderten Entwicklungen darstellt. Damit wird auch das Thema Cloud Object Gateways für SMB, NFS und CIFS zu S3 (Amazon S3-compliant interface) als object storage „Übersetzung“ für den transparenten Zugriff auf archivierte (legacy) Applikationsdaten wichtig, da derzeit nur die wenigsten (legacy) Anwendungen via HTTP / RESTful über S3 bzw. SWIFT (OpenStack) nativ kommunizieren.

Lösungen die Open-Source bzw. Objektspeicher-Lösungen auf Basis Industrie-Standard Server in Kombination mit Cloud-Computing-Technologien nutzen, erzielen dann messbare Skaleneffekte, um die hohen Kosten für eine revisionssichere Archivspeicherung auch im Mulit-Petabyte-Umfeld zu adressieren.

Ein Fazit: Ich habe versucht, zumindest auf einige Aktionsfelder hinzuweisen, um die Digitale Transformation aus Infrastruktur- und Daten-Management-Sicht in einen Mehrwert für Unternehmen zu transformieren. Die IT-Infrastruktur und damit verbundenen Werkzeuge (Netze, HCI, SDDC, SDS, Storage Systeme usw.) spielen hierbei eine zentrale Rolle. Übrigens: Nicht erwähnt wurden aus Platzgründen die Themen Big Data Analystics, ML, KI und Storage (Hadoop & Co./ In-Memory-Computing usw.), auf die ich in einem der nächsten Blogs separat eingehen werde.

Abb. 1: Software Defined Cloud Native Storage - Projekt (Bildquelle: Cloud Native Computing Foundation (CNCF) https://rook_io )

Quelle> https://www.cncf.io/blog/2018/01/29/cncf-host-rook-project-cloud-native-storage-capabilities/

Appendix (siehe Gartner Studie**):

Im SDDC virtualisiert die Software alle Speicher- und Netzwerkressourcen. Auf diese Pools lässt sich über ein Self-Service-Portal zugreifen. In Rechenzentren wird die Infrastruktur SDS-Präsenz nach Ansicht von Gartner in zwei Bereichen zunehmen:

- "Als Bestandteil von HCI, die Hypervisor-unabhängige SDS-Infrastrukturlösungen oder die Speicherverwaltungs-Funktionen

- Als Plattform für disaggregierte, unstrukturierte Daten, die softwarebasierte, verteilte Filesysteme und Objektspeicher nutzen

- Die Software arbeitet im Hintergrund, automatisiert Arbeitsabläufe, die IT-Fachkräfte sonst manuell steuern müssten. Das verschlankt und beschleunigt IT-Prozesse, während das System Monitoring- und Reporting-Aufgaben bewältigt. Darüber hinaus sind Zusatzfunktionen wie Showback oder Chargeback für die transparente Verrechnung der IT-Ressourcen möglich."

** Quellenangabe (1)

Gartner 2017 Strategic Roadmap for Storage. Published: 08 March 2017 ID: G00324339. Analyst(s): Pushan Rinnen, John McArthur, Stanley Zaffos, Raj Bala, Dave Russell, Julia Palmer, Valdis Filks, Garth Landers, Santhosh Rao, Robert Rhame, Julian Tirsu, Shane Harris. „Summary: Emerging storage hardware and software enable I&O leaders to lower acquisition costs per terabyte and improve manageability. In addition to focusing on agility, automation and cost reductions, IT leaders should address the cultural changes and skill set shortages caused by digital business projects.“

Laut IDC „Worldwide Software-Defined Storage (SDS) 2014-2019 Forecast“ betrug die Kapazität von objektbasiertem SDS im Jahr 2015 zwölf Exabyte. Laut IDC ist einer Wachstumsrate von 49,5% davon auszugehen, dass es 2020 bereits 67,4 Exabyte sein werden (Quelle: Amita Potnis, IDC Research Manager).