München, Starnberg, 08. April 2024 - Nutzung von NVIDIA AI Enterprise mit NVIDIA NIM Microservices; die Potenziale von 25 Exabyte an Unternehmensdaten besser nutzen…

Zur Ankündigung: Unternehmensdaten in Kombination mit einer umfassenden Full-Stack-Platform, die für Large Language Model (LLM) optimiert ist, spielen eine zentrale Rolle, um generative KI-Anwendungen im Unternehmen von der Testphase zur Umsetzung zu bringen. Cloudera powered by NVIDIA plant NVIDIA NIM Microservices**, Teil der Software-Platform NVIDIA AI Enterprise, in Cloudera Machine Learning - Cloudera Data Platform (CDP) Service - für KI/ML-Workflows zu integrieren. Die Kooperation soll danach schnellere, sichere und vereinfachte generative KI-Workflows ermöglichen. (**Querverweis / externer Link > https://nvidianews.nvidia.com/news/generative-ai-microservices-for-developers ).

Auf Basis der Microservices NVIDIA NIM und NeMo Retriever können Entwickler KI-Modelle mit ihren Geschäftsdaten verknüpfen – einschließlich Text, Bildern und Visualisierungen wie Balken-, Linien- und Tortendiagramme – um präzise, kontextbezogene Antworten zu generieren. Entwickler, die diese Microservices nutzen, sind in der Lage Anwendungen über NVIDIA AI Enterprise zu erstellen, was optimierte Laufzeiten für die Erstellung, Anpassung und Bereitstellung von LLMs im Unternehmen ermöglichen kann. Mit dem Einsatz von NVIDIA Microservices lässt sich Cloudera Machine Learning nutzen, um den Mehrwert von Unternehmensdaten unter der Cloudera-Verwaltung zu maximieren. Die Vorteile: Hochleistungsfähige KI-Workflows, Plattformsoftware und beschleunigtes Computing für Daten – unabhängig davon, wo sie sich befinden.

Integrierte Services schaffen neue Möglichkeiten

Cloudera plant nach vorliegenden Angaben mehrere Integrationen mit NVIDIA Microservices anzubieten. Cloudera Machine Learning wird Modell- und Anwendungsbereitstellung auf Basis von NVIDIA Microservices integrieren. So sollen Kunden Fehlertoleranz, Serving mit niedriger Wartezeit und automatische Skalierung für KI-Modelle erreichen können, die überall eingesetzt werden – sowohl in Public als auch in Private Clouds. Darüber hinaus wird Cloudera Machine Learning integrierte NVIDIA NeMo Retriever Microservices bieten, um die Verbindung von benutzerdefinierten LLMs mit Unternehmensdaten zu vereinfachen. Anwender können so Retrieval-Augmented-Generation (RAG)-basierte Anwendungen für den Unternehmenseinsatz erstellen.

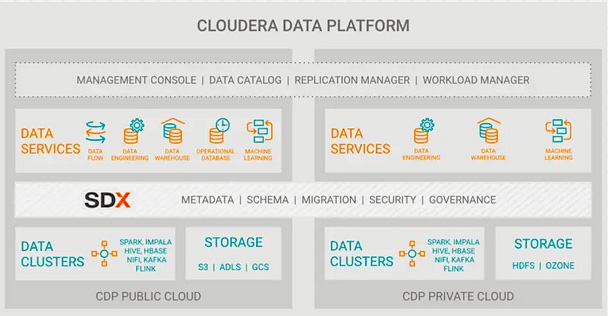

Bildquelle: Cloudera

Cloudera arbeitete bereits zuvor mit NVIDIA zusammen, um GPU-optimierte Datenverarbeitung durch die Integration des NVIDIA RAPIDS Accelerator für Apache Spark in CDP nutzbar zu machen. Mit den geplanten zusätzlichen NVIDIA Microservices und der Integration von NVIDIA AI Enterprise soll CDP durchgängige hybrid KI-Pipelines bieten.

Fazit: In Zukunft sollen Unternehmen aller Branchen in der Lage sein, LLMs schneller und intuitiver zu erstellen, anzupassen und einzusetzen. Dazu gehören Anwendungen wie Coding Co-Pilots für schnellere Entwicklung, Chatbots für automatisierte Kundeninteraktionen und -services, Apps zur Textzusammenfassung für die schnelle Verarbeitung von Dokumenten, optimierte und kontextbezogene Suche und vieles mehr. Die Innovationen können Daten- und KI-Prozesse einfacher und schneller im gesamten Unternehmen machen, steigern den Umsatz und optimieren Kosten.

Querverweis:

Unser Beitrag > Cloudera bietet on-premise Open Data Lakehouse für vertrauenswürdige Unternehmens-KI

Unser Beitrag > Notwendige strategische Schritte für den sicheren Einsatz von KI im Unternehmensumfeld

Unser Blogpost > Speicheranforderungen bei KI-Anwendungen: Randbedingungen und Einsatzkriterien