Berlin, Starnberg, 25. Jan. 2023 - Zu erwarten ist eine Konsolidierung des Tech-Stacks und der Cloud-Kosten für dieses Jahr; EU-Datenresidenz wird verstärkt nachgefragt..

Zum Beitrag: DoubleCloud, ein in den USA (Delaware) und Deutschland (Berlin) eingetragenes Unternehmen mit Geschäfts- und Entwicklungszentren an sieben Standorten in den USA, Deutschland, Großbritannien, Frankreich und Israel, ist laut eigenen Angaben maßgeblich an der Entwicklung führender Open-Source-Technologien wie ClickHouse, PostgreSQL, Odyssey, WAL-G u.a. beteiligt. Das Unternehmen bietet aktuell jedoch mehr als nur eine verwaltete Datenbank, die performante Datenanalysen durchführen kann, sondern aggregiert, speichert, überträgt und visualisiert diese Daten. Die Plattform wurde laut Anbieter dabei so konzipiert, dass sie komplett mit verwalteten (managed-) Open-Source-Technologien genutzt werden kann.

In dem Umfang, wie die Bedeutung von Daten für Unternehmen steigt, steigt jedoch auch der Druck, diese effizienter zu speichern, zu verarbeiten und zu sichern. Dafür sind Weiterentwicklungen in zahlreichen Bereichen notwendig. Welche Entwicklungen in diesem Zusammenhang für IT-Verantwortliche in 2023 von besonderer Relevanz sein werden, hat Stefan Käser, Solution Architect bei DoubleCloud Deutschland (1), aus seiner Sicht nachfolgend für Sie hier zusammengefasst:

"Datenbank-interne Transformationen: Im neuen Jahr wird die Nutzung von DBMS für die Transformation von Daten, um sie für Analysen vorzubereiten, beschleunigt werden. Dies geschieht bereits in gewissem Umfang, wird sich aber 2023 dank besserer Tools für die datenbankinterne Transformation massiv beschleunigen.

Maschinelles Lernen in der Datenbank: Ebenso wird die Nutzung von DBMS für die Erledigung weiterer komplexer Aufgaben beim maschinellen Lernen zunehmen. Große Unternehmen wie Vertica und BigQuery haben dies bereits auf proprietärem Weg versucht, aber ich sehe einen Trend zu Open-Source-Technologien, die wesentlich plattformunabhängigere Lösungen entwickeln und damit ML auf Basis von sSQL demokratisieren.

Konsolidierung des Tech-Stacks: Es werden immer mehr Unternehmen fusionieren, und zwar auf allen Ebenen des Tech-Stacks. In den letzten Jahren gab es eine enorme Verbreitung von Tools, aber laut Käser wird es 2023 viel mehr Unternehmen geben, die sich um einen großen Teil des Tech-Stacks kümmern.

Dezentrale Data Meshs werden zunehmen: 2023 wird es viel mehr Möglichkeiten geben, auf Daten dort zuzugreifen, wo sie sich befinden, und es wird mehr Plattformen für den Zugriff auf diese Daten geben. Es gibt einfach zu viele Daten, die ständig bewegt werden müssen. Warum sollte man bei einmaligen Abfragen nicht einfach die Ergebnisse dort abrufen, wo die Daten gespeichert sind?

Konsolidierung der Cloud-Kosten: Es ist möglich, dass sich zukünftig viele Unternehmen aus Kostengründen von der Cloud verabschieden werden zugunsten von On-Premises- oder Hybrid-Lösungen. Wir sprechen ständig von steigenden Energiepreisen, aber auch die Cloud-Preise werden steigen.

Europäische Cloud-Lösungen: Da die EU versucht, sich in Bezug auf Energie- und Ressourcenanbieter zu diversifizieren, ist es wahrscheinlich, dass 2023 auch eine Verlagerung zu mehr EU-Cloud-Lösungen stattfinden wird, um eine größere Unabhängigkeit von US-amerikanischen Unternehmen zu erreichen. Zu beobachten ist bereits ein Anstieg bei Cloud-Anbietern in EU-Ländern, da immer mehr Menschen nach einer Datenresidenz in der EU suchen.

HTAP: HTAP (Hybrid Transactional and Analytics Processing) wird sich möglicherweise 2023 oder auch später durchsetzen (also eine Art Wette...). Ich glaube nicht, dass HTAP OLAP ersetzen wird, aber es könnte angesichts der Vereinheitlichung von Tools beliebter werden (d.h. TiDB als Ersatz für MySQL + OLAP oder MySQL Heatwave).

Datenverträge: 2023 wird es mit ziemlicher Sicherheit eine Zunahme von Eigentumskonzepten für Daten durch eine Person oder ein Team geben, um die Komplexität unbekannter Daten zu reduzieren. Ziel ist es auch, sicherzustellen, dass die Daten, die ich nachgelagert zur Verfügung stelle, einem vereinbarten Standard entsprechen und der Endnutzer saubere Daten erhält, wobei es meine Aufgabe ist, dies sicherzustellen."

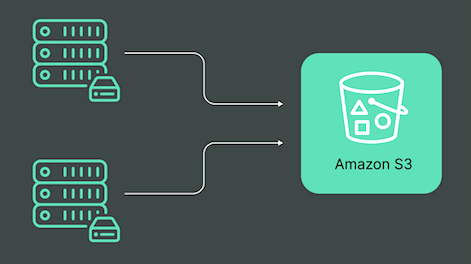

Abb. 1: Hybrid storage backed by S3 for cost efficiency (Bildquelle: DoubleCloud)

Anmerkung zur Abbildung: ClickHouse® lässt sich mit Objektspeichersystemen integrieren. Nachdem ClickHouse eine große Menge an Tabellendaten verarbeitet hat, benötigt man eine schnelle, einfach zugängliche und kostengünstige Möglichkeit, die Daten für die weitere Verwendung zu speichern. Die Integration mit Standard-Speicherdiensten oder mit einem hybriden S3-Objektspeicher, stellt eine effektive Lösung dar.

Weil die Unternehmen immer mehr Daten erzeugen, ist eine kosteneffiziente und robuste Cloud-Speicherstrategie unabdingbar. Unabhängig von der Geschwindigkeit, dem Volumen oder der Vielfalt der Daten ermöglicht Amazon Simple Storage Service (S3) eine skalierbare, sichere und latenzarme Speicherung. Die Integration von S3 in ClickHouse bietet laut Angabe von DoubleCloud dazu folgende Vorteile:

- Datensicherheit: Amazon S3-Buckets sind hochgradig gesichert und nur für die Ersteller und diejenigen zugänglich, denen sie die Erlaubnis erteilen. Das Identitätszugriffsverwaltungsprotokoll steuert die Zugriffsberechtigungen für jede Datei oder jeden Bucket auf dem S3-Speicher.

- Verfügbarkeit: Als von Amazon entwickeltes Speichersystem bietet S3 den Benutzern dasselbe schnelle, zugängliche und zuverlässige System, das die Plattform für den Betrieb ihres globalen Netzwerks verwendet. S3 Standard-IA und S3 Standard sind für eine Verfügbarkeit von 99,9 % bzw. 99,99 % ausgelegt.

- Kosteneffektiv: Mit dem S3-Standard-Datenspeichersystem zahlen Sie nur für das, was Sie nutzen, und das sind in der Regel niedrige Kosten zwischen 0,022 $/GB und 0,0125 $/GB. Amazon S3 Glacier, das einen unregelmäßigen Zugriff auf automatisch migrierte Daten bietet, ist noch kostengünstiger.

- Vereinfachte Datenmigration: Amazon S3 bietet drei Arten von Datenmigrationsoptionen: rsync, S3-Befehlszeilenschnittstelle und Glacier-Befehlszeilenschnittstelle. Diese Optionen sind kostengünstig und ermöglichen die automatisierte und schnelle Übertragung großer Datenmengen, die auf ein beliebiges Gerät importiert oder von einem beliebigen Gerät exportiert werden.

- Benutzerfreundlich: Mit S3 Simple Storage Service entfällt der Aufwand für die Speicherung, Sicherung, Verwaltung und Übertragung von Daten zwischen Systemen. Da es sich um ein konfigurierbares System handelt, können die Benutzer ihre Lebenszyklus- und Replikationsrichtlinien selbst festlegen. Die Benutzer können auch die Anforderungsmetriken und Speicherklassen mit Filtern anpassen, die einen besseren Überblick über die Datenspeicherung bieten.

(1) Bild-/Quelle: Stefan Käser, Solution Architect bei DoubleCloud

Querverweis:

Unser Beitrag > Micro Focus Vertica: Advanced Analytics und ML mit Version 12 der Analysendatenbank

Unser Beitrag > Container-Sicherheit unter der Lupe: Enabler oder Blockierer?