Kaiserslautern, Starnberg, 13. Juni 2019 - Erste Benchmarks lieferten 3x mehr Leistung als Direct Attached NVMe; IT-Infrastruktureffizienz für KI und Analytic-Apps...

Zum Hintergrund: Excelero (softwaredefinierte Blockspeicherlösung) und ThinkParQ (1) haben bekannt gegeben, dass ihr gemeinsames Projekt Früchte inzwischen trägt: Die Unternehmen haben erfolgreich Excelero softwaredefined Blockspeicher NVMesh (2) für einen gemeinsamen NVMe-Storagepool in ThinkParQs paralleles Cluster-Dateisystem BeeGFS integriert und konnten danach Latenzen wie in einem lokalen Laufwerk verzeichnen. Die Ergebnisse der Benchmark-Tests der ersten Deployments zeigen laut Entwickler, dass die Kombination der beiden Lösungen eine maximale Ressourcenauslastung und Flexibilität möglich macht. Die erzielte Performance soll besonders für datenintensive Workloads sowie für High Performance Computing (HPC), KI, Maschinelles Lernen und Analysen geeignet sein.

Excelero und ThinkParQ haben auf die Nachfrage von Kunden einen NVMe-Speichercluster mit BeeGFS und NVMesh bereitgestellt, um die Produktivität von fortschrittlichen GPU-Compute-Clustern zu steigern. Diese leiden wie viele andere unter dem Flaschenhals im Speicher, der typisch für KI ist... I/O-intensive Anwendungen können selbst auf GPU-Systemen nicht schnell genug verarbeitet werden. Das Ergebnis ist, dass Datensätze häufig von Hand lokal kopiert werden müssen. Kommentar Frank Herold, CEO von ThinkParQ: „Die Fähigkeit von NVMesh, eine riesige Menge an IOPS mit den extrem niedrigen Latenzen von NVMe-Laufwerken über Netzwerke mit hochverfügbaren Volumes bereitzustellen, hat uns sehr beeindruckt. Das Gleiche gilt für die Option mittels verteiltem Erasure Coding auf der Blockspeicher Ebene und BeeGFs eine beispiellose Effizienz für unterschiedlichste Zugriffsmuster und Dateigrößen bereitzustellen.“

Zum Testaufbau der Konfiguration

Zum Nachweis der Möglichkeiten dieser neuen Scale-out-Infrastruktur nutzten die Unternehmen die mdtest- und IOR- Standardtests. Der Testaufbau bestand aus einem 2HE-Chassis mit 4 Servern und insgesamt 24 NVMe-Laufwerken, das über ein 100Gbit RDMA Netzwerk mit 8 BeeGFS Client-Compute Nodes verbunden war. Die Vergleichstests wurden mit der exakt gleichen Hardwarekonfiguration durchgeführt: BeeGFS mit Direct Attached NVMe und BeeGFS mit logischen NVMesh Volumes.

NVMesh wurde zum Auslagern der Spiegelungs-Operationen verwendet, wodurch der Datei-Erstellungsprozess von BeeGFS um das Dreifache beschleunigt wurde. Auch das Lesen der Metadaten erfolgte 2,5x schneller.

Für den (random) Zugriff auf kleine Dateien, was häufig als besonders kritisch für die Anwendungsleistung ist, hat die geringe Latenz von NVMesh die BeeGFS 4K Schreib-IOPS auf 1,25 Millionen pro Sekunde gesteigert – das entspricht einer 2,5fachen Verbesserung.

Mit dem verteilten Erasure Coding von NVMesh für BeeGFS erhalten die Nutzer nach vorliegenden Angaben bis zu 90 % nutzbare Kapazität ohne Einfluss auf die Tolerierbarkeit von Laufwerkausfällen; gleichzeitig erzeugt das Einsteigersystem einen Streaming-Durchsatz von 75 GB/s.

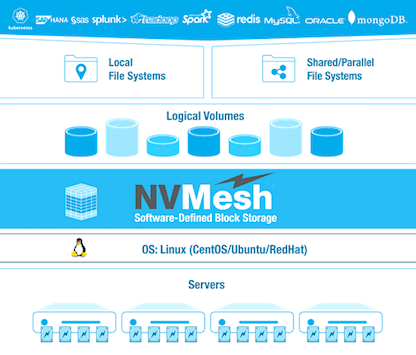

(2) Abb. 1: Low-latency distributed block storage for web-scale applications; Architekturübersicht (Bildquelle: Excelero)

Kommentar Lior Gal, CEO und Mitgründer von Excelero: „Man kann ein Unternehmen von morgen nicht auf einer Infrastruktur von gestern aufbauen. Wir freuen uns darüber, wie nahtlos NVMesh und BeeGFS zusammen funktionieren. Dadurch müssen weder die IT-Teams noch die Endbenutzer in Organisationen Abstriche machen…“.

(1) ThinkParQ wurde 2014 als Spin-off vom Fraunhofer Center for High-Performance Computing gegründet und ist seither für die Weiterentwicklung von BeeGFS verantwortlich. ThinkParQ arbeitet eng mit Systemintegratoren zusammen, um schlüsselfertige Lösungen zu entwickeln.

Hinweis: Excelero und ThinkParQ werden vom 16. bis 20. Juni auf der ISC (Super Computing Messe) 2019 in Frankfurt/M. am ThinkParQs Stand J-640 sowie dem Excelero Stand E-1039 die gemeinsame Lösung vorführen.