Starnberg, 15. Dez. 2022 - Senkung der Gesamtbetriebskosten (TCO) und Verbesserung des Return on Investment (ROI) stehen im Vordergrund von Beschaffungsmaßnahmen...

Zum Inhalt dieses Blogposts: IT-Dienstleister - das gilt für interne Organisationen wie für externe Anbieter müssen um wettbewerbsfähig zu bleiben, ihre (hybriden-)Cloud- oder vergleichbaren Dienste wie z.B. Storage-as-a-Service (STaaS), Backup-as-a-Service (BRaaS) nicht nur zu konkurrenzfähigen Preisen, sondern auch zu wettbewerbsfähigen Kostenstrukturen anbieten. Daneben ist aus rein funktionaler Sicht bei Speicherlösungen für die Anwendung neben einer hohen Bereitstellungsflexibilität (z.B. Erweiterungen je nach Bedarf) vor allem mehr Automatisierung und skalierbare Leistung zentral. Die verwendete Speicherumgebung soll dann natürlich für alle primären Workloads wie Webserver, virtuelle Desktops, Datenbanken sowie die gängigen Hypervisor-Systeme (bei CSPs/MSPs auch gerne OpenNebula / OpenStack) für virtualisierte, Container- oder Bare-Metal-Ressourcen zur Verfügung stehen. Ein weiterer Punkt betrifft die Verbindung von privat-cloud / on-premise Ressourcen mit hybriden- und Multi Cloud-Plattformen über API’s und native Plug-ins, um den IT-Betrieb weiter zu modernisieren und zu rationalisieren.

Über den Bereich von primären Workloads hinaus entstehen weitere Herausforderungen und zwar vor allem auf Grund von rasch wachsenden unstrukturierte Daten (Benutzerdokumente, Bilder, Videos usw.). Diese müssen je nach Rechtslage nicht nur abgespeichert, sondern darüber hinaus für weitere Analysen zur Verfügung stehen. Die Migration der Daten in die Cloud kann dazu beitragen, nicht nur Kosten zu senken, sondern auch die Monetarisierung dieser Assets über KI-/ Cloud-basierte Data Lakes / Big Data Analytics voranzutreiben. Unternehmen verlassen sich verstärkt auf ihre Daten, um strategische Erkenntnisse zu gewinnen und um mehr (Kosten-)Transparenz zu erreichen. Eine Umfrage vom letzten Jahr unter 300 IT-Entscheidungsträgern aus Unternehmen in den USA und in Großbritannien unterstützt diesen Trend. Die Mehrheit der befragten Unternehmen verwaltet danach mehr als 1 PB und gibt über 30 % des IT-Budgets für Datenspeicherung und -schutz aus - Tendenz steigend... Hier einige Ergebnisse der Befragung (1):

50 % der Unternehmen speichern danach ihre Daten in einer Mischung aus lokalem und Cloud-basiertem Speicher. Zu den wichtigsten Prioritäten für das Cloud-Datenmanagement gehören: Migration von Daten in die Cloud (56 %), Senkung der Speicher- und Datenkosten (46 %) sowie Governance und Sicherheit von Daten in der Cloud (41 %). Investitionen in Analysetools haben höchste Priorität (45 %) vor dem Kauf von mehr Cloud- oder On-Premises-Speicher oder der Modernisierung von Backups. Ein Drittel der Unternehmen räumt ein, dass mehr als 50 % der Daten kalt sind, während 20 % dies nicht wissen, was auf die Notwendigkeit hindeutet, die Daten während ihres Lebenszyklus richtig zu platzieren. Als Ziele und Herausforderungen beim Management unstrukturierter Daten wurden danach vor allem Sichtbarkeit, Kostenmanagement und Data Lakes genannt. Ein zentraler Punkt dabei: IT-Führungskräfte wollen zuerst mehr Transparenz, bevor sie in mehr Speicherplatz investieren und 44,9 % möchten steigende Kosten vermeiden. 65,5 % der Unternehmen geben mehr als 30 % ihres IT-Budgets für die Speicherung und Verwaltung von Daten aus. (1) Quelle: Komprise 2021 State of Unstructured Data Management Report.

Dies zeigt auch, dass es für Service Provider und interne Rechenzentren-/Dienstleister noch viel Spielraum zur Optimierung gibt, über die richtigen Speicherangebote bei der Senkung der Storage- und damit IT-Infrastrukturkosten mitzuwirken. Zumal sich durch Software-gesteuerte Architekturen die Möglichkeit bietet, Daten nicht mehr in abgeschlossenen Silos bzw. abhängig von der Infrastruktur in der sie gespeichert sind, sondern auch unabhängig von den zugehörigen Anwendungen zu verwalten.

Diesen Blogpost bei Apple Podcasts hören:

Kriterien zur Senkung der Gesamtbetriebskosten (TCO) und Verbesserung des Return on Investment (ROI) im Bereich von primären Workloads (Block-/File)

Der hybride Cloud-Betrieb mit Hilfe integrierter Datendienste wird zunehmend durch softwaredefinierte Infrastruktur- und Asset-Verbrauchsmodelle bestimmt. Speicheranbieter im Primärspeicher-Umfeld sollten deshalb folgende Kriterien erfüllen (kein Anspruch auf Vollständigkeit):

- Skalierbare Anwendungs- und gemischte Workload-Performance Garantie (Stichworte: konsistente Leistung, QoS, NVMe, SSDs, Caching)

- High-Density Architektur mittels state-of-the-art media Technologie (TCO)

- Flexibel skalierbare Kapazitätsbereitstellung bis in den Multi-Petabyte-Bereich

- Kapazitätsoptimierung (Dedupe)

- KI-unterstützter automatisierter IT-Betrieb (AIOps) für pro-aktives Troubleshooting (vorausschauende Wartung)

- Massiv skalierbare und sichere Snapshot-Leistung ohne Beeinträchtigung der Systemleistung; Ransomware-Protected

- Upgrades im laufenden Betrieb ohne Beeinträchtigung der Anwendung (100% Verfügbarkeit, keine single-points-of-failure, ununterbrochenen Zugriff auf Speicherkapazitäten)

- Cyberresiliente Speicherumgebung (air-gapped, granular apps recovery, open API-Framework Integration für Backup-/DR-Operations, VM-Backups auf Image-Ebene und Replikation mit Anwendungskonsistenz, etc.)

- File- und S3-Objekt-Zugriff (File-/Objektspeicher-Schnittstelle mit Cloud-Anbindung)

- Einheitliche Managementplattform für hybride Multicloud-Umgebung.

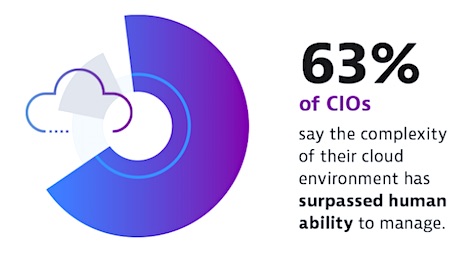

Bildquelle: Dynatrace Studie, CIO-Studie offenbart Zwickmühle zwischen digitaler Transformation und steigender Komplexität. Link > https://storageconsortium.de/content/content/cio-studie-offenbart-zwickm%C3%BChle-zwischen-digitaler-transformation-und-steigender-komplexit%C3%A4t

Weitere Querverweise:

Unser Beitrag > Wie sich Backups mit Immutable Storage gegen Ransomware absichern lassen

Unser Beitrag > Gartner Magic Quadrant für Primärspeicher 2022: AIOps und STaaS im Fokus