Wien, Starnberg, 08. April 2021 - Stärkster Datenschutz gegen undichte S3-Buckets; keine x86-CPU-bezogene Sicherheitslücken mit Hilfe von Shamir’s Secret Sharing...

Zum Beitrag: Maxeler Technologies (Maxeler) - Pionier für Maximum Performance Computing und fragmentiX Storage Solutions (fragmentiX) - führend im Bereich sicherer Multi-Cloud-Speicher, gehen eine Kooperation ein, um Datenspeicher- und Computing-Lösungen mit Zitat "maximaler Performance und ultra-sicherem Design anzubieten". Basierend auf ihrer gemeinsamen Markterfahrung in den Bereichen Scientific Computing, Government und Finance arbeiten Maxeler und fragmentiX zusammen, um datenoptimierte, spezialisierte HPC-Umgebungen mit höchstmöglicher Performance bei gleichzeitig höchstmöglichem Datenschutz zu versehen. Die Produkte der beiden Unternehmen arbeiten dazu in verschiedenen Szenarien zusammen:

Maxelers M-Space (www.m-space.work) Datenplattform: Die kollaborative Forschungs- und Entwicklungsumgebung erhält durch die integrierte Datenspeicherarchitektur von fragmentiX den stärksten Datenschutz.

Maxeler's MAX5-Beschleunigungstechnologie: die Maximum-Performance-Karten bieten eine anpassbare Architektur für jede Rechenherausforderung und sollen in zukünftigen Generationen von fragmentiX-Produkten eingesetzt werden, um die Leistung und den Funktionsumfang für die Benutzer zu erhöhen.

fragmentiX CLUSTER: Der FPGA-basierte Maxeler miniMAX bietet demnach zusätzlichen Schutz für die 10GB/s WAN-Verbindungen der fragmentiX CLUSTER-Knoten gegen x86-CPU-bezogene Sicherheitslücken wie Spectre und Meltdown. Die miniMAX-Appliance erhöht laut Anbieter zudem die Sicherheit auf jeder standardbasierten Netzwerkverbindung mit Echtzeit-Performance, um alle bekannten und - soweit technisch möglich - noch unbekannten Schwachstellen der wichtigsten CPU-Technologien weltweit zu entschärfen.

Zum technischen Hintergrund: Maxeler Hardware-/Software-Lösungen nutzen Dataflow-Computing - eine weitere Art um Berechnungen durchzuführen, die sich jedoch völlig von der Berechnung mit herkömmlichen CPUs unterscheidet. Dataflow-Computer konzentrieren sich auf die Optimierung der Datenbewegung innerhalb einer Anwendung und nutzen die massive Parallelität zwischen Tausenden von winzigen "Dataflow-Cores", um Vorteile in der Größenordnung von Leistung**, Platz- und Stromverbrauch zu erzielen. Eine Analogie für den Wechsel von Kontrollfluss zu Datenfluss ist laut Maxeler das Modell der Ford-Automobilproduktion, bei dem Zitat "teure, hochqualifizierte Fachkräfte (Kontrollfluss-CPU-Kerne) durch eine Fabrikstraße ersetzt werden, die Autos durch ein Meer von "Ein-Fach-Arbeitern" (Datenfluss-Kerne) bewegt."

Technisch gesehen ist Dataflow somit eine Computerarchitektur, die im Gegensatz zur traditionellen von-Neumann-Architektur als Kontrollfluss-Architektur definiert ist. Dataflow-Architekturen besitzen keinen Programmzähler und die Ausführung von Anweisungen wird auf der Grundlage der Verfügbarkeit von Eingangsargumenten für die Anweisungen bestimmt, so dass die Reihenfolge der Befehlsausführung nicht-deterministisch ist (Quelle: https://www.researchgate.net/publication/220566271_Dataflow_Machine_Arch... ).

**Dataflow-Computing führt jeden Schritt eines Algorithmus parallel aus und ähnelt einem System von Pipelines mit synchronen Operationen. Es lässt sich gut auf FPGA-Hardware abbilden und kann HPC-Algorithmen um eine oder zwei Größenordnungen im Vergleich zu einer Allzweck-Hardware beschleunigen ( Quelle aus "Dataflow Computing for Biophysics and High Energy Physics", Goethe Universität Frankfurt/M., IRI > Link ).

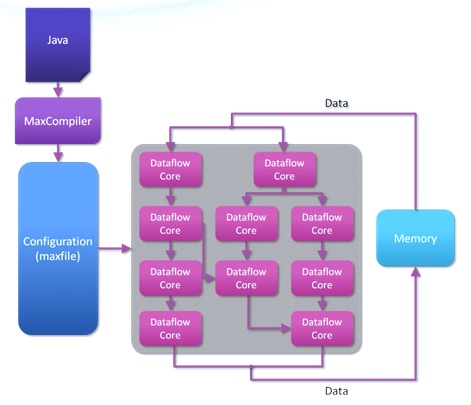

Abb. 1: Computing with data flow cores (Bildquelle: Maxeler)

Hinweis zur Abbildung: In einer Dataflow-Anwendung wird der Programmquelltext in eine Dataflow-Engine-Konfigurationsdatei umgewandelt, die die Operationen, das Layout und die Verbindungen einer Dataflow-Engine beschreibt. Die Daten können aus dem Speicher in den Chip gestreamt werden, wo die Operationen ausgeführt werden. Die Daten werden direkt von einer Recheneinheit ("Dataflow-Core") an eine andere weitergeleitet, wenn die Ergebnisse benötigt werden, ohne dass sie in den Off-Chip-Speicher geschrieben werden, bis die Prozesskette abgeschlossen ist (Quelle: Maxeler Dataflow Computing).

Dazu Oskar Mencer, CEO von Maxeler Technologies: "Geschützt durch nur sehr schwierig angreifbare FPGAs und verteilt in Fragmenten, die über Shamir’s Secret Sharing berechnet werden, bietet die fragmentiX-Maxeler-Lösung eine noch nie dagewesene Datengeheimhaltung und gleichzeitig die Skalierbarkeit mehrerer Public-Cloud-Anbieter, kombiniert mit hybrider und On-Premise-Speicherung, wo dies erforderlich ist“. Werner Strasser, CEO von fragmentiX Storage Solutions ergänzt: "Jeder Mensch und jedes Unternehmen verdient digitale Souveränität und Sicherheit bei der Speicherung sensibler Daten oder industriellen geistigen Eigentums. Eine solche garantierte Langzeit-Privatsphäre ist besonders wichtig, wenn es um medizinische und genomische Daten mit potenziellen Folgen für mehrere Generationen geht“. (1)

(1) Die fragmentiX Storage Solutions GmbH ist Entwickler und Hersteller von Secret Sharing Storage Appliances. Digitale Souveränität und digitale Ausfallsicherheit wird durch die Anwendung etablierter Algorithmen - erstmals 1979 von Adi Shamir veröffentlicht - auf Industriestandard-Hardware mit einem speziell entwickelten, gehärteten Betriebssystem erreicht. fragmentiX ermöglicht seinen Kunden, Daten in hybriden Speicherumgebungen zu schützen, indem das Risiko „undichter" S3-Buckets eliminiert wird. Nur der Benutzer weiß, wo seine Datenfragmente gespeichert sind - und selbst wenn ein Fragment dieser Daten gestohlen wird, ist es für den Dieb nutzlos. Die informationstheoretische Sicherheit (ITS), die fragmentiX bietet, ist laut dem Unternehmen eine der wenigen Möglichkeiten, Daten gegen zukünftige Quantencomputer zu schützen.

Querverweis:

Unser Beitrag > fragmentiX S3-Storage schützt medizinische Daten in Graz mittels Quanten-Kryptographie

Unser Blogpost > Quantencomputer bedrohen die Sicherheit von Verschlüsselungs-Verfahren, Teil 2

Unser Podcast > Quantencomputer bedrohen die Sicherheit von Verschlüsselungs-Verfahren (Teil 1), Link > Storage Consortium Podcast bei Apple iTunes(TM).