San Mateo (CA), Starnberg, 15. März 2021 - Neue Anwendung im Finanzdienstleistung-Risikomanagement; Hazelcast Cloud Enterprise jetzt auf allen gängigen Plattformen...

Zur Ankündigung: Hazelcast als schnelle Cloud-Anwendungsplattform veröffentlichte eine spezielle Referenzimplementierung für Finanzdienstleister. Sie erleichtert die Ausführung finanzieller Risikoberechnungen in der Cloud - inklusive Skalierung mit Echtzeit-Performance und voller Ausschöpfung der dazu notwendigen Ressourcen. Zusätzlich kündigt Hazelcast die Verfügbarkeit seines Managed Service Hazelcast Cloud Enterprise auf der Google Cloud Platform GCP an. Diese wurde gleichzeitig als Umgebung für diese Referenzimplementierung verwendet. Credit Valuation Adjustment (CVA) ist das finanzielle Maß für das Risiko einer Serie von Geschäften, falls die Gegenpartei ihren Verpflichtungen nicht nachkommt. Die Hazelcast-Referenzarchitektur zeigt, wie eine In-Memory-Computing-Plattform die Vorteile von Cloud-Umgebungen nutzen kann, insbesondere im Hinblick auf Elastizität und Agilität. CVA-Berechnungen sind typischerweise umfangreiche Rechenaufgaben. Durch die Möglichkeit der Skalierung auf Anforderung können Finanzdienstleister jedoch nun ihre Berechnungskosten kontrollieren, indem sie nur für die genutzten Ressourcen zahlen.

1. Details zur Implementierung

Sobald In-Memory-Technologien implementiert sind, lassen sich die Daten eines oder mehrerer Geschäfte aus einer Datenbank laden und über eine Caching-Schicht mit mehreren Knoten verteilen. Diese dienen dann als Eingabewerte für ein Netzwerk von Berechnungsinstanzen, welche die zugeteilten Berechnungsblöcke parallel ausführen. Die Ergebnisse wandern wieder zurück in die Caching-Schicht. In diesem Szenario ist laut Enwickler oft eine große Rechner-Farm mit etwa 40.000 CPU-Kernen nötig, um die massive Anzahl an Berechnungen in minimaler Zeit abzuschließen.

Der verteilte Hazelcast-Datenspeicher mit datengesteuerter Stream-Verarbeitung ersetzt in diesem Modell die Stapelverarbeitung durch eine Art Pipelinesystem. Es schiebt die Eingabedaten in die Berechnungsfarm, orchestriert effizient die Berechnungen und sammelt dann die Ergebnisse ein, sobald sie vorliegen. Dieser sogenannte “Straight-Through”-Verarbeitungsansatz eliminiert das Zwischenspeichern von Daten in jeder Berechnungsphase und beschleunigt den Gesamtprozess. Dieser viel schnellere Ablauf ermöglicht es, von täglichen oder vielleicht stündlichen Kalkulationen auf Ad-hoc-Berechnungen überzugehen. Das erlaubt auch die Berücksichtigung aktueller Ereignisse, welche die Marktdynamik verändern könnten. So können Finanzinstitute schneller auf veränderte Marktbedingungen reagieren. Dabei ist es egal, ob diese durch Wirtschaftsnachrichten, eine nationale Katastrophe, geopolitische Ereignisse oder andere Faktoren ausgelöst sind. Ein kosteneffizientes Risikomanagement kommt aber nicht nur Finanzinstituten zugute, sondern auch den anderen Märkten und der globalen Wirtschaft.

Mit dieser Implementierung in der Cloud so wie es bei dieser Demonstration in der Google Cloud Platform (GCP) der Fall war, können Unternehmen laut Anbieter die Infrastruktur leicht skalieren. So lässt sich das Volumen der Berechnungen oder die erforderliche Laufzeit anpassen. Zur Demonstration dieses Cloud-nativen Ansatzes skalierte Hazelcast seine Nutzung von GCP auf einen Cache mit 300 Container-Instanzen als Teil eines Kubernetes-Clusters. Dieses bestand aus 110 virtuellen Maschinen, die auf Intel Cascade Lake-Hardware basierten. Bei einem herkömmlichen On-Premises-Ansatz müsste der Anwender eine große Anzahl von Maschinen anschaffen. Der wirtschaftliche Kompromiss zwingt zu einer Maschinenanzahl, die irgendwo zwischen Spitzenlast und geringer Last liegt und somit für keine der beiden ideal ist.

2. Hazelcast Cloud Enterprise

Hazelcast Cloud Enterprise ist ein Managed Service, bei dem Hazelcast die Softwareimplementierung im Namen der Kunden betreut. Dadurch können sich deren Mitarbeiter auf die Entwicklung geschäftskritischer Anwendungen konzentrieren, um die Echtzeit-Einsichten zu verbessern. Mit der Verfügbarkeit auf GCP ist Hazelcast Cloud Enterprise nun auf allen wichtigen Clouds verfügbar, einschließlich Amazon Web Services (AWS), Microsoft Azure und IBM Cloud.

Mit der integrierten WAN-Replikation kann Hazelcast Cloud Enterprise Daten effizient von einem beliebigen Standort zu einem anderen replizieren und dabei die Verfügbarkeit einer Anwendung und ihrer Daten sicherstellen. Diese Multi-Cloud-Strategie ermöglicht eine breitere geografische Datenverteilung, beispielsweise um Anwendungen und Daten näher an den Endanwendern zu betreiben. Die Bereitstellung aktiver Replik-Cluster über Zonen, Regionen, Cloud-Anbieter und On-Premises-Standorte hinweg ermöglicht ein höheres Maß an Verfügbarkeit. Entwickler können so Geschäftsanwendungen auf demselben Anwendungsframework aufbauen. Es spielt keine Rolle, wo die Anwendung laufen soll - sogar am sogenannten Edge oder in hybriden Cloud-Umgebungen ist dies möglich.

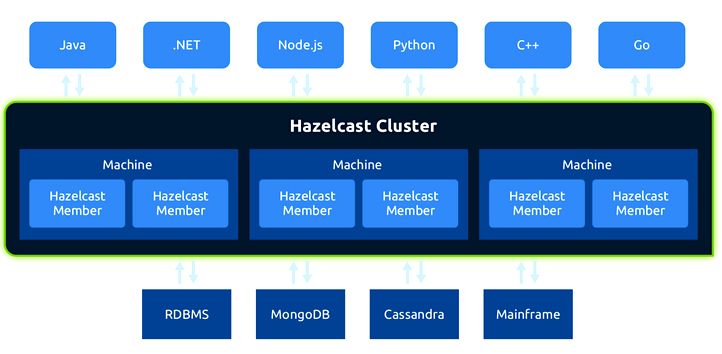

Abb. 1 Bildquelle: IMDG Hazelcast

Anmerkung: Ein IMDG (In-Memory Data Grid) ist ein Satz von vernetzten Computer-Clustern, die ihren Arbeitsspeicher (RAM) zusammenfassen, damit Anwendungen Datenstrukturen mit anderen im Cluster laufenden Anwendungen gemeinsam nutzen können. Der Hauptvorteil ist die Geschwindigkeit, die in einer Umgebung mit Milliarden von mobilen, IoT-Geräten und anderen Quellen, die kontinuierlich Daten streamen, entscheidend geworden ist. Da sich alle relevanten Informationen in einem IMDG im RAM befinden, ist es nicht erforderlich, für die Transaktionsverarbeitung ein Netzwerk zu einem entfernten Speicher zu durchlaufen. Der Geschwindigkeitsunterschied ist laut Hazelcast beträchtlich - Minuten im Vergleich zu Reaktionszeiten im Sub-Millisekundenbereich für komplexe Transaktionen, die millionenfach pro Sekunde ausgeführt werden.

Kommentarauszug John DesJardins, Chief Technology Officer bei Hazelcast: „Die wirtschaftlichen Vorteile der Cloud sind bekannt, vor allem die Möglichkeit, dabei nur für die in Anspruch genommenen Ressourcen zu zahlen. Implementierungen im eigenen Rechenzentrum die nur für bestimmte Workloads bestimmt sind, nutzen die verfügbaren Ressourcen nicht zu 100%. Die Investition in die Infrastruktur zahlt sich damit nicht voll aus“.

Querverweis: