München, Starnberg, 08. März 2021 - DevOps- und Site Reliability Engineering (SRE) Teams überblicken Netzwerke komplexer Systeme; ein Kommentar von New Relic...

Zum Hintergrund: Unternehmen haben heute die Qual der Wahl, wenn es um die Entwicklung und Verwaltung von Softwareumgebungen geht. In der Regel können Unternehmen dabei auf ein Repertoire von 20 bis 40 Tools zurückgreifen. Doch anstatt dazu beizutragen, die Prozesse von Innovation, der mittleren Zeit bis zur Erkennung von Problemen (mean time to detection, MTTD) oder der mittleren Zeit zur Lösungsfindung (mean time to resolution, MTTR) zu verkürzen, bedingt eine große Palette an unterschiedlichen Tools nur neue Probleme. Unabhängig davon, ob sie gekauft oder über Open Source genutzt werden. Dieser Ansicht ist jedenfalls Klaus Kurz, Director Solutions Consulting bei New Relic (1), der sich für uns in seinem nachfolgenden Beitrag auf die Bedeutung von Tool-Konsolidierung und -Rationalisierung für Unternehmen konzentriert hat.

Zum Beitrag: "Der Aufwand für den Wechsel zwischen verschiedenen Tools steigt. Zudem entstehen Datensilos und Schwachpunkte, was die Produktivität und die Möglichkeiten der Zusammenarbeit einschränken kann. Weitere, potenzielle Probleme sind die fehlende Datenkorrelation und die unzureichende Skalierbarkeit von Punktlösungen. Außerdem können Konflikte bei der Lizenzierung und den Kosten entstehen, wenn mehrere Anbieter beteiligt sind. All diese Faktoren wirken sich auf die Effektivität von Arbeitsabläufen aus. Ganz egal, ob dadurch die Markenreputation einen Schaden davonträgt, mögliche Einnahmen entfallen oder im Allgemeinen eine geringere betriebliche Effizienz entsteht: Die Kosten sind zu hoch, um sie zu ignorieren. Folgende drei Gründe sprechen deshalb auch besonders stark dafür, dass die Konsolidierung und Rationalisierung von Tools für Unternehmen oberste Priorität haben sollte:

1. Moderne Umgebungen erfordern moderne Observability-Praktiken

DevOps- und Site Reliability Engineering (SRE)-Teams überblicken inzwischen weit verzweigte Netzwerke komplexer Systeme und sich verändernder Umgebungen. Je geschäftskritischer die Softwarelandschaft ist, desto komplexer ist es in der Regel, sie zu monitoren und zu verwalten. Downtimes können immer schwerer diagnostiziert werden, verursachen gleichzeitig aber einen immer größeren Schaden – vor allem, wenn man mit einer verteilten Architektur und großen Teams arbeitet. Nach Angaben von Gartner liegen die durchschnittlichen Kosten für Ausfallzeiten umgerechnet bei etwa 4.600 Euro pro Minute. Dabei ist optimales Monitoring und Management entscheidend für den Geschäftserfolg.

Deswegen sollten Unternehmen sich vermehrt über Observability Gedanken machen. Sie ermöglicht es, den gesamten Stack in einer einzigen Benutzeroberfläche zu betrachten, um die Ursache eines Problems zu erkennen. Durch dieses Verständnis können Probleme schneller behoben und zudem verhindert werden, dass sie erneut auftreten.

2. Blinde Flecken müssen behoben werden, um größere Effizienz und bessere Skalierung zu erreichen

Da die Quellen des Datenflusses durch komplexe Cloud-Umgebungen zunehmen, wird es immer schwieriger zu erkennen, was vor sich geht. Wenn eine Warnung auftritt, dass eine Anwendung langsamer geworden ist, stellt sich oft die Frage nach der Ursache. Ist es ein Code-Fehler in der Anwendung oder ein Problem mit den Infrastrukturressourcen? Oder ist es ein Problem mit dem Datenfluss – was bedeuten kann, dass jedes Gerät einzeln überprüft werden muss?

Durch den Wechsel zwischen verschiedenen Tools zum Monitoring von unterschiedlichen Bereichen des Stacks verschwenden Unternehmen oft unnötig Zeit. Laut Mavenlink geben 73 Prozent der Unternehmen an, dass sie im Durchschnitt mehr als eine Stunde pro Tag damit verbringen, von App zu App zu navigieren. Dadurch entstehen auch Datensilos, die den Arbeitsaufwand und das Risiko von blinden Flecken erhöhen sowie die Aufmerksamkeit der Entwickler von der Softwareoptimierung ablenken. Darüber hinaus kann die Interpretation von Performance-Messwerten aus mehreren Tools zu menschlichen Fehlern führen. Die Visualisierung aller Daten an einem Ort eliminiert solche blinden Flecken.

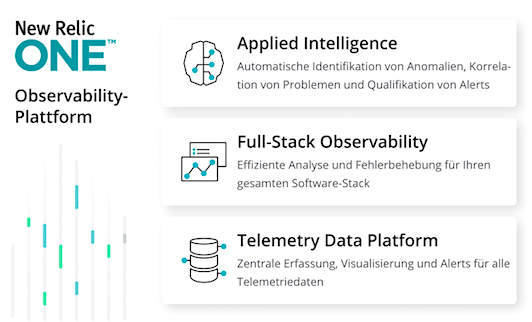

Abb.: New Relic One Observability-Platform (Bildquelle: New Relic)

3. Eine bessere Entwickler-Experience führt zu einer besseren Kunden-Experience

- Probleme auf der Entwicklerseite führen unweigerlich zu einer schlechten Kundenerfahrung, da sich der Zustand und die Leistung der Infrastruktur direkt auf den Endbenutzer auswirken. Viele traditionelle Monitoring-Tools laufen On-Premise. Das bedeutet, dass die Entwickler zusätzliche Ressourcen und Kompetenzen benötigen, um die Tools angemessen zu verwalten. Infolgedessen dauert es viel länger, Probleme zu beheben. Denn fehlen detaillierte Daten, kann der Ursprung eines Problems nicht identifiziert und somit nicht gänzlich behoben werden. Diese Probleme können dann immer wieder auftreten, was Teams zusätzlich unter Druck setzt. Die Konzentration auf die Fehlerbehebung nimmt demnach viel Zeit in Anspruch, die eigentlich zur Optimierung der Kundenerfahrung aufgewendet werden könnte – was bedeutet, dass die Kundenerfahrung langfristig leidet.

Tool-Konsolidierung und -Rationalisierung sind die Lösung

Die Modernisierung der Infrastruktur ist wichtig, um mit der Software einen Wettbewerbsvorteil zu behalten. Aber ein Sammelsurium aus unzusammenhängenden Tools ist dafür nicht besonders geeignet. Um in der Lage zu sein, alle verwendeten Tools konsolidieren zu können, benötigen Unternehmen zunächst einen klaren Überblick über ebendiese. Bestehende Tools sollten den einzelnen Teams und Ergebnissen zugeordnet werden. Zudem muss ein idealer Endzustand anhand von KPIs definiert werden.

Als nächstes sollte ein umfassender Katalog von Anwendungsfällen erstellt werden, der mögliche Lösungsansätze skizziert. Anschließend sollten kritische Szenarien geprüft werden. Sobald dies geschehen ist, kann man mit der Migration beziehungsweise Integration beginnen. Dies beinhaltet die Schulung von Teams zu neuen Prozessen und die Bereitstellung von Informationen und Wissen.

Fazit: Letztendlich profitieren alle von der reduzierten Komplexität und der verbesserten Zusammenarbeit, die durch die Rationalisierung der Tools ermöglicht wird. Dadurch kann Geld gespart und die Effizienz gesteigert werden, wodurch die Teams sich wiederum auf Innovationen konzentrieren und so den Kundennutzen maximieren können."

(1) Das Foto zeigt Klaus Kurz, Director Solutions Consulting bei New Relic (Bildquelle: New Relic)

Querverweis: