Starnberg, 26. Juni 2018 - iSCSI versus iSER versus NVMeoF - Gegensätze oder Ergänzungen? Ein kurzer Überblick zum gegenwärtigen Stand der Entwicklung...

Um was es hier geht: Neue Entwicklungen im Bereich der künstlichen Intelligenz, bei maschinellem Lernen oder Deep Learning erzeugen speicherintensive Anwendungen, die teilweise deutlich mehr Leistung von den Speicherlösungen fordern. Zeitgleich steigt die Datenmenge auf Grund der Digitalisierung in den Unternehmen stetig. Oder mit anderen Worten: die Anforderungen in Bezug auf Kosteneffizienz, Kapazität und Durchsatz (IOPS, Bandbreite) an Speichersysteme und das Storage Networking nehmen zu. Davon betroffen ist natürlich auch der Storage Protokoll Stack und insbesondere das aus Grund der umfangreichen Standardisierung und Kosteneffizienz weitverbreitete iSCSI Protokoll, wenngleich SCSI aus einer Zeit stammt in der die Festplatte (HDD) und nicht der Halbleiterspeicher (SSD) dominierte.

iSCSI ist weiterhin sehr beliebt, da kostengünstig in der Beschaffung und inzwischen auch vergleichsweise performant, auch wenn die Implementierung im Enterprise aus meiner Sicht nicht mit Fibre Channel zu vergleichen ist (Protokollrobustheit, Sicherheit, skalierbare Leistung in der Fabric, Qualität der Management Tool etc.). Wo allerdings bei iSCSI mehr Leistung gefragt ist, können sog. iSCSI-Initiator Adapter bzw. iSCSI-Offload-Adapter eingesetzt werden, um die Server- oder Speicher-CPU-Last zu reduzieren. Das Protokoll generell verwendet heute 1/10/25/40/50/100 GBE zum Transport über TCP/IP, was wiederum hilft, die Implementierungs-Flexibilität und den Betrieb auch großer Umgebungen zu vereinfachen (OpEx).

Das neue iSER Protokoll (iSCSI Extensions for RDMA) ist eine Variante, die konzipiert wurde, um die Vorteile von RDMA-Fabrics im Bereich skalierbarer Speichernetzwerk-Performance zu nutzen. Es agiert als Übersetzungs-Layer, der iSCSI Transaktionen für den Betrieb via RDMA über Converged Ethernet (RoCE), iWARP RDMA und InfiniBand bzw. Intel OmniPath-Architektur ermöglicht.

iSER iWARP/RoCE benötigt für hohe Leistung eigene RDMA-fähige 10/25/40/50/100GbE RDMA-Offload-Hardware und zwar sowohl innerhalb der Server (initiators-) als auch der Zielsysteme (targets). Ein Nachteil der iSER Technologie: ein mögliches Zusammenspiel mit iSCSI-Endknoten erfordert das Deaktivieren von iSER-Erweiterungen sowie den Verlust der Hardware-Offload-Unterstützung. In Bezug auf die Performance im direkten Vergleich zu iSCSI-Software-Implementierungen bietet iSER durch den Hardware-Offload eine verbesserte Leistung bei gleichzeitig geringerer CPU-Auslastung.

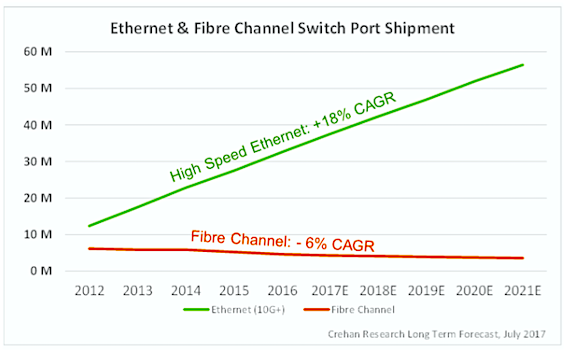

Abb. 1: Ethernet and FC Switch Port Shipment Prognose, Long Term FCST (Bildquelle: Crehan Research, July 2017)

Wird deutlich mehr Leistung in Form von geringsten Latenzen beim I/O benötigt, ist Non-Volatile Memory Express (NVMe) das optimierte Protokoll für die Host-Kommunikation via nativen PCIe-SSDs. NVMe over Fabrics (NVMe-oF) als skalierbare Variante zu Direct Attached SSDs (DAS) ermöglicht es, die Daten via NVMe-oF über ein Speichernetz auf Basis Ethernet (RoCE / iWARP), Fibre Channel oder InfiniBand zwischen angeschlossenem Host und Flashstorage (SSD, NAND Array etc.) zu übertragen. Ein Nachteil von NVMEoF: Wie bei iSER können aber auch hier NVMe-oF Ethernet-RDMA-Endknoten nur mit anderen NVMe-oF-Ethernet-Endknoten zusammenarbeiten, die denselben Ethernet-RDMA-Transport unterstützen. NVMe-oF-Endknoten können nicht mit iSCSI- oder iSER-Endknoten zusammenarbeiten.

Fazit: NVMe over Fabrics ist technologisch bereits weit entwickelt, aber die Verfügbarkeit von Treiber-Standards lässt im Gegensatz zu iSCSI derzeit noch zu wünschen übrig. Mit der weiteren schnellen Entwicklung im Halbleiter-Speicherbereich (siehe z.B. SCM) steht es allerdings außer Frage, das latenzarme Protokolle wie NVMe und NVMe-oF (die nicht mehr auf dem iSCSI-Protokollstack beruhen), in Zukunft an Bedeutung zunehmen werden.

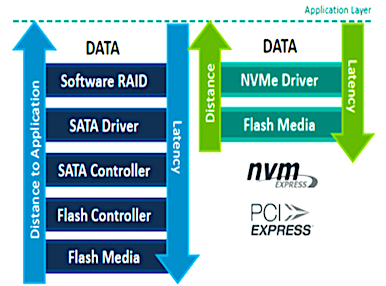

Abb. 2: Protokoll Stack, SCSI/SATA versus NVMe/PCIe (Bildquelle: NVM Express.org)