Starnberg, 30. Dez. 2020 - Zur Zukunft von Block-Level Storage auf Basis FibreChannel, iSCSI und NVMe-oF. Konvergenz oder Divergenz auf Grund steigender Datenmengen?

Um was geht es hier? Der vorliegende Blogpost zeigt auf, welche in der Praxis relevanten Speicherprotokolle und damit verbundenen Storage-Technologien sich über die Zeit im Markt etabliert haben und skizziert, wo ihre Ausprägungen in aktuellen Produkten gerade beginnen, sich im Sinne einer möglichen Konvergenz oder gar Ablösung bestehender Technologien zu verschieben. Auf den ersten Blick mag die Frage zur Zukunftssicherheit von Block-Storage für FC, iSCSI und NVMe-oF im Kontext der bisherigen Ausführungen vielleicht merkwürdig klingen (siehe Blogpost Teil 1)**, doch ist sie auf längere Sicht hin im Sinne der Eingangs erwähnten „Innovationsdynamik“ schon berechtigt. Ein Grund: Wenn wir das extrem schnelle Wachstum von semi- und unstrukturierten Daten analysieren, stellt man wie bereits häufig erwähnt fest, dass IoT- und KI/ML-Daten, Videodateien, Bild- und Audiofiles etc. überproportional zunehmen.

Und diese Entwicklung ist erst den Anfang einer künftig fast explosionsartigen Entwicklung. Laut IDC z.B. könnten bis zum Jahr 2024 über 80% aller weltweit gespeicherten Daten in Archiven vorliegen. Wenn damit also die Nutzung von File- und Objektspeicher-Systemen weiterhin deutlich schneller anwächst als bei iSCSI, FC und NVMe basierten Block-Level Storage-Systemen, so würde das nicht ohne Konsequenzen für die Weiterentwicklung (Investitionen) und das potentielle Marktwachstum solcher Systeme bleiben.

Anderseits zeigt die bisherige Erfahrung, dass komplementäre Technologien (von wenigen Ausnahmen abgesehen) über eine längere oder gar sehr lange Zeit (>15 Jahre) am Markt koexistieren und eingesetzt werden, auch um radikale Brüche in der kritischen IT-Infrastruktur (betrifft primär die Anwendungsseite) zu vermeiden. In der Zwischenzeit besteht natürlich eine höhere Wahrscheinlichkeit, dass NVMoF das iSCSI-Protokoll für den Hochleistungs-Blockspeicherzugriff auf Flashspeicher verdrängen wird, während gleichzeitig die zunehmende Bedeutung von File- und Object Storage sowohl Block Storage basierte FC-SANs und iSCSI Speichernetze betrifft; und dieser Trend ist heute bereits sichtbar.

NAS, File-, Object- und Unified Scale-Out Software Defined Storage:

File-basierte Systeme als DAS-Lösung oder als Speichernetzwerk (NAS) konfiguriert, sind einfach zu implementieren und zu betreiben; das erklärt ihre große Beliebtheit seit Jahrzehnten. Allerdings können File-Storage-Systeme nur durch Hinzufügen weiterer Systeme („Filer“) und nicht etwa durch einfaches Hinzufügen von mehr Kapazität beliebig skaliert werden. Der inhärente Nachteil von NAS-Lösungen besteht in der fast linearen Zunahme von Komplexität & Kosten bei stark steigenden unstrukturierten Daten. Ein Grund dafür ist, dass mit gängigen NAS / File Storagelösungen die Daten innerhalb einer festen Ordnerhierarchie organisiert werden, dessen Pfade komplex und lang werden können. Die Architektur ist deshalb für schnell wachsende unstrukturierte Datenmengen im zweistelligen Multi-Petabyte- oder Exabyte-Bereich kaum geeignet. Deshalb geht seit einiger Zeit bereits eine Entwicklung in Richtung (clustered) scale-out Filesysteme, wie überhaupt hochleistungsfähige Filesysteme die Plattform für skalierbare Speicherinfrastrukturen darstellen, egal ob als open-source Software Defined Storagelösung wie z.B. Ceph oder eine Vielzahl herstellerspezifischer Implementierungen, die sich heute am Markt befinden.

Objektbasierte Speicher (integrierte Lösungen oder Software-only) verfügen im Gegensatz zu NAS über eine flache Datenverwaltungs-Struktur. Dateien werden dazu in einzelne Bereiche aufgeteilt und über Serversysteme (Nodes) verteilt. Diese Objekte werden nicht als Dateien in Ordnern oder gar Blöcke auf Servern, sondern in einem Repository gespeichert und mit den dazugehörigen Metadaten verknüpft (s.a. global namespace). Dies ermöglicht die Skalierung auf sehr große Datenmengen und ist gut geeignet zur Speicherung von unstrukturierten Datenformaten. Allerdings ist Object Storage wiederum nicht für klassische Datenbank-Umgebungen geeignet, denn das Schreiben dauert im Vergleich zu Block-level Storage viel zu lange; auch die native Programmierung einer Cloud-basierten Anwendung im Zusammenspiel mit S3 als Object Storage API ist mitunter wesentlich komplexer als die Verwendung von File Storage.

Globale File System Implementierungen gehen einen Schritt weiter und sind per se als hybride Cloud Storage Lösungen konzipiert. Während dann die Cloud als zentrales Daten-Repository verwendet wird, stellt sich das System logisch so dar, als handele es sich um ein NAS-System vor Ort. Dieser Ansatz bietet Kostenvorteile gegenüber herkömmlichen on-premise-Lösungen, ebenso wie im Vergleich zu gängigen Public-Cloud-Speicherlösungen. Leistungsfähige globale Dateisysteme sind heute bereits in der Lage, Filedaten in der Cloud als Objekte zu speichern. Diese Lösung ermöglicht es Anwendern, auf Files so zuzugreifen, wie sie es mit einem Standard NAS-System tun würden, während gleichzeitig der Großteil der Daten auf einem kostenoptimierten, hoch-skalierbaren Objekt-Backend gespeichert wird.

Die Einschränkungen traditioneller Network Attached Storage (klassische NAS, SAN)-Systeme veranlassen Unternehmen heute, nach objektbasierten Speicherlösungen zu suchen, die (globale) Filesystem-Funktionen unterstützen. Eine objektbasierte Speicherung mit integrierten nativen File-Management-Funktionen (keine separate Gateway-Lösung) macht die Integration von NAS und Objektspeicher daher interessant und eröffnet eine Fülle neuer Anwendungsmöglichkeiten, vom Backup-/Disaster Recovery über Compliance-konforme Archivierung bis hin zu hochsicheren, zentral konsolidierten Cloud-Services für den weltweiten File-Zugriff und die Dateisynchronisation. Im Vergleich zu File Services Angeboten großer Cloud-Anbieter sind diese eine echte wirtschaftliche Alternative und können auch zu einer höheren Akzeptanz der IT im Unternehmen führen.

Zusammenfassung

Entwickler und Anwender fordern von der IT-Infrastruktur heute mehr Flexibilität, Leistung und Verfügbarkeit. Grund ist die zunehmende Dynamik im Bereich von neuen Applikationen, Datenformaten, Benutzern und sich verändernden Workload-Profilen, wie sie im Zuge der Digitalisierung und IoT- oder KI-Projekten ausgehen. Mit dem starken Anwachsen von semi- und unstrukturierten Datensätzen in Multi-Petabyte-Größenordnungen stößt die klassische SAN- und NAS-Architektur an technische und wirtschaftliche Grenzen.

Die Speicherprotokolle werden davon natürlich unterschiedlich betroffen sein und es wird maßgeblich auch davon abhängen, welche Anwendungsfälle auf lange Sicht dominieren. Aber eines ist klar: Entwicklungen zur optimierten Konsolidierung auf Systemarchitekturen mit integrierten „Unified-" und Cloud-Protokollfähigkeiten (file-, block, object / S3) auf Basis Software Definierter Plattformen (SDS, SDDC, Computational Storage) wird sich fortsetzen.

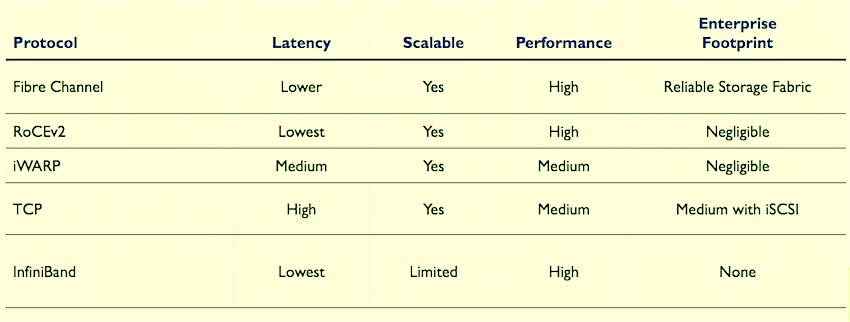

Abbildung: Storage Protokolle - Leistungskriterien (Quelle: SNIA, Storage Developers Conference 2019)

Link > https://www.snia.org/

Querverweis:

** Blogpost Teil 1 > Block-, File- und Object - Storagesysteme & Protokolle in der Entwicklung