Boston (US), Starnberg, 31. Mai 2023 - Das Portfolio setzt auf Red Hat OpenShift Data Science, um produktionsreife KI-Modelle und Anwendungen für Unternehmen zu realisieren…

Zur Ankündigung: Red Hat kündigt neue Leistungsmerkmale für Red Hat OpenShift AI an, das auf den Funktionen von Red Hat OpenShift und Red Hat OpenShift Data Science aufbaut und diese erweitert. Red Hat OpenShift AI stellt gleichzeitig ein spezialisiertes Partner-Ökosystem für Data Scientists und Entwickler bereit, um Innovationen im Bereich KI nutzen zu können. Zu diesem Zweck unterstützt Red Hat OpenShift AI die generativen KI-Services von IBM watsonx.ai. Diese (IBM-)Plattform für Künstliche Intelligenz zielt darauf ab, intelligente Anwendungen und Services in allen Bereichen eines Unternehmens zu skalieren und die nächste Generation von Basismodellen auf den Weg zu bringen.

Large Language Models (LLMs) wie GPT-4 und LLaMA finden zunehmend Verbreitung

Forscher und Anwendungsentwickler in allen Bereichen und Branchen suchen deshalb nach Möglichkeiten, von diesen und anderen grundlegenden Modellen zu profitieren. Unternehmen können mit kommerziellen oder Open-Source-Modellen und domänenspezifischen Daten eine Feinabstimmung vornehmen, um die Modelle exakter auf ihre spezifischen Anwendungsfälle anzupassen.

Das initiale Training von KI-Modellen ist sehr infrastrukturintensiv und erfordert spezialisierte Plattformen und Tools, noch bevor das Serving, Tuning und Modell-Management adressiert werden. Ohne eine Plattform, die diesen Anforderungen gerecht wird, können Unternehmen KI/ML oft nur eingeschränkt nutzen. OpenShift AI greift laut Red Hat diese Herausforderungen auf, indem es laut Anbieter eine konsistente Infrastruktur für das Training, die Bereitstellung und die Inferenz bietet, um das Potenzial von KI auszuschöpfen.

KI für die offene Hybrid Cloud

Red Hat OpenShift AI stellt eine standardisierte Grundlage für die Erstellung von KI/ML-Modellen in der Produktion sowie für die Ausführung der daraus resultierenden Anwendungen bereit. Plattform-Ingenieure können skalierbare Konfigurationen erstellen, die speziell auf die Anforderungen ihrer Data Scientists und Entwickler zugeschnitten sind.

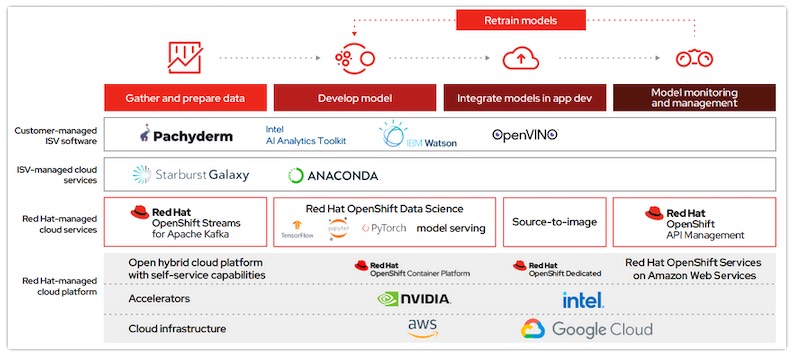

Auch zur Feinabstimmung bestehender Modelle kann OpenShift AI verwendet werden, wodurch die Kosten für das anfängliche Modelltraining gesenkt und die Zeit bis zur Wertschöpfung reduziert werden sowie die KI-Nutzung über spezialisierte Data Scientists hinaus erweitert wird. Red Hat OpenShift AI umfasst mehrere optionale Angebote von Technologiepartnern wie Anaconda, IBM Watson Studio, Intel OpenVINO und AI Analytics Toolkit, NVIDIA AI Enterprise und Starburst. Außerdem bietet es Zugang zu 30 weiteren zertifizierten KI/ML-Partnern als Teil des OpenShift-Ökosystems.

Unternehmen mit spezifischen regulatorischen und Compliance-Anforderungen, einschließlich isolierter und getrennter Umgebungen, können mit OpenShift AI Daten vorbereiten und Modelle on-premises entwickeln, trainieren und bereitstellen. Es lassen sich auch Modelle in der Public Cloud entwickeln und diese on-premises oder an der Edge mit denselben konsistenten Werkzeugen und Schnittstellen bereitstellen. So entsteht eine einheitliche hybride MLOps-Umgebung, die die Zusammenarbeit zwischen IT-Betrieb, Data Scientists und Anwendungsentwicklern unterstützt Die Basis von OpenShift AI soll Unternehmen laut Entwickler eine zuverlässige Skalierung für das Training von Basismodellen unter Verwendung der nativen GPU-Beschleunigungsfunktionen von OpenShift eermöglichen, und zwar on-premises oder über einen Cloud-Service.

Zu den aktuellen Erweiterungen von Red Hat OpenShift AI gehören:

- Deployment-Pipelines für die Nachverfolgung von KI/ML-Experimenten und automatisierte ML-Workflows, die Data Scientists und Entwicklern intelligenter Anwendungen dabei helfen, ML-Projekte schneller zu iterieren und die Automatisierung in die Bereitstellung und Aktualisierung von Anwendungen zu integrieren

- Model Serving, das jetzt die GPU-Unterstützung für Inferenz und benutzerdefinierte Model-Serving-Laufzeiten umfasst, wodurch die Inferenz-Performance und die Bereitstellung von Basismodellen verbessert werden

- Model Monitoring, das Unternehmen das Management von Performance- und Betriebsmetriken über ein zentrales Dashboard ermöglicht.

- OpenShift AI unterstützt IBM watsonx und Ansible Lightspeed

- Red Hat OpenShift AI stellt die Basis für die neuen KI-Entwicklungen von IBM bereit, einschließlich IBM Watson Code Assistant, um der IT-Organisation und den Entwicklerteams eine domänenspezifische KI zur Verfügung zu stellen.

- Ansible Lightspeed bringt die Leistung von IBM Watson Code Assistant in Ansible ein und erlaubt es Benutzern, Ansible Playbooks mit KI-generierten Empfehlungen zu schreiben. Ansible Lightspeed ermöglichteinen Produktivitätsschub für alle Ansible-Benutzer, indem sie unabhängig von ihren Automatisierungskenntnissen englischsprachige Befehle zur Erstellung eines Ansible-Playbooks verwenden können.

Abb.: OpenShift Data Science release components (Bildquelle: Red Hat). Externer Link zu Red Hat OpenShift Data Science > https://www.redhat.com/en/technologies/cloud-computing/openshift/openshift-data-science

Branchenübergreifend setzen danach Unternehmen Red Hat OpenShift AI bereits ein, um KI/ML-Innovationen voranzutreiben. Darunter ist auch Atruvia, ein deutscher Anbieter von IT-Dienstleistungen einschließlich KI für Finanzinstitute weltweit, der seine unternehmensweite Data-Science-Plattform auf Red Hat OpenShift AI aufgebaut hat.

Querverweis:

Checkliste für die unternehmensweite Implementierung von MLOps. Externer Link > https://www.redhat.com/en/resources/mlsops-top-5-checklist

Unser Beitrag > Red Hat veröffentlicht Red Hat Enterprise Linux 9.2 und kündigt Version 8.8 an

Unser Beitrag > AWS kündigt neue Tools für die Anwendungsentwicklung mit generativer KI an

| Anhang | Größe |

|---|---|

| 78.27 KB |