München, Starnberg, 31. März 2022 - Zertifizierung von NVIDIA AI Enterprise 2.0, neue Compliance-Profile sowie Sandbox-Containers mit Version 4.10 ab sofort verfügbar...

Zur Ankündigung: Red Hat hat neue Funktionen und Zertifizierungen für Red Hat OpenShift angekündigt, um die Bereitstellung intelligenter Anwendungen in hybriden Clouds zu beschleunigen. Mit den Verbesserungen, zu denen die Zertifizierung für den Einsatz der Plattform mit NVIDIA AI Enterprise 2.0 zählt, sollen KI-Workloads zuverlässig ausgerollt werden können. Nach Prognosen von Gartner wird der weltweite Umsatz mit KI-Software in diesem Jahr voraussichtlich 62,5 Milliarden Dollar erreichen – das wäre ein Anstieg von 21,3 Prozent gegenüber 2021.

Wenn Unternehmen dazu KI und maschinelles Lernen in Cloud-native Anwendungen integrieren, benötigen sie eine agile, flexible und skalierbare Plattform für die Entwicklung und schnelle Produktivstellung der Machine-Learning-Modelle und intelligenten Anwendungen.

1. Beschleunigte Einführung von KI-Projekten

Während KI die Abläufe und Geschäftsmodelle von Unternehmen transformiert, kann der Betrieb der KI-Infrastruktur jedoch komplex als auch zeit-/ressourcenaufwändig sein. Um alle damit verbundenen Prozesse zu beschleunigen, ist Red Hat OpenShift jetzt für den Einsatz mit NVIDIA AI Enterprise 2.0 zertifiziert worden. Dabei handelt es sich um eine Cloud-native Ende-zu-Ende-Plattform mit KI- und Analytics-Software, die auf NVIDIA-zertifizierten Standardsystemen läuft. Die integrierte Plattform wurde für Red Hat OpenShift optimiert und erlaubt es Data Scientists und Entwicklern, ihre Modelle schneller zu trainieren, einfach in Anwendungen einzubauen und skaliert bereitzustellen.

Unternehmen haben hier die Möglichkeit, Red Hat OpenShift auf NVIDIA-zertifizierten Systemen mit NVIDIA Enterprise AI einzusetzen oder wie bisher auf der bereits zuvor unterstützen NVIDIA DGX A100, einem universellen Hochleistungssystem für KI-Workloads. Dadurch können sie den MLOps-Lebenszyklus – inklusive Data Engineering, Analytics, Training, Software-Entwicklung und Entscheidungsfindung – auf einer einheitlichen und einfach zu implementierenden KI-Infrastruktur konsolidieren. Dazu erlauben es die integrierten DevOps- und GitOps-Funktionalitäten von Red Hat OpenShift, die Bereitstellung von KI-gestützten Anwendungen im Rahmen von Continuous Delivery weiter zu beschleunigen. Mit NVIDIA AI Enterprise auf Red Hat OpenShift ergänzt Red Hat die bereits für Red Hat OpenShift Data Science angekündigte Unterstützung von NVIDIA-GPUs.

Breitere Unterstützung von Clouds und Hardware-Architekturen

Red Hat OpenShift 4.10 setzt nach vorliegenden Angaben die Erweiterung der Plattform fort, um ein breites Spektrum an Cloud-nativen Workloads in der offenen Hybrid Cloud zu unterstützen und es Unternehmen zu ermöglichen, ihre KI- und Machine-Learning-Workloads in den verschiedensten Umgebungen auszuführen. Die neueste Version von OpenShift unterstützt weitere Public Clouds und Hardware-Architekturen, sodass Unternehmen ihre Entwicklung so einfach und konsistent wie möglich gestalten und flexibel entscheiden können, wo Anwendungen laufen. Zu den wichtigsten neuen Funktionen und Fähigkeiten zur beschleunigten Einführung von KI- und Machine-Learning-Workloads zählen danach laut Anbieter:

IPI-Support (Installer Provisioned Infrastructure) für Azure Stack Hub sowie – als Technology Preview – für Alibaba Cloud und IBM Cloud. Anwender sollen danach den IPI-Prozess für eine vollständig automatisierte, integrierte Ein-Klick-Installation von OpenShift 4 nutzen können.

Betrieb von Red Hat OpenShift auf Arm-Prozessoren. Die Arm-Unterstützung ist auf zwei Arten verfügbar: vollständig automatisiert mit IPI für AWS (Amazon Web Services) und als Bare Metal UPI (User Provisioned Infrastructure) auf bestehender Infrastruktur. Letzteres bietet die gleiche Nutzererfahrung wie Red Hat OpenShift auf AWS, unterstützt durch die neuesten Arm-Instanzen.

Verfügbarkeit von Red Hat OpenShift auf NVIDIA LaunchPad. Es bietet freien Zugang zu kuratierten Labs für IT- und KI-Profis, in denen sich NVIDIA-beschleunigte Systeme und NVIDIA-Software nutzen lassen. Unternehmen können so praktische Erfahrungen rund um die Konfiguration, Optimierung und Orchestrierung von Ressourcen für KI- und Data-Science-Workloads mit NVIDIA AI Enterprise und Red Hat OpenShift sammeln. Red Hat Link > KI und Machine Learning auf OpenShift

Kommentarauszug Eddie Ramirez, Vice President, Infrastructure Line of Business, Arm: „KI hat das Potenzial, unsere technologische Zukunft zu prägen, erfordert aber vielfältigere und spezialisierte Computing-Lösungen kombiniert mit der bestmöglichen Nutzererfahrung für Entwickler. Durch die Erweiterung von OpenShift um Arm-Unterstützung liefert Red Hat Entwicklern spannende neue Wahlmöglichkeiten für die Verarbeitung von KI-Workloads und hilft, die Vorteile leistungsstarker, kosteneffizienter Arm-basierter Prozessoren in hybriden Cloud-Umgebungen zu erschließen.“

2. Verbesserte Compliance-Funktionen für neue Workloads

Die Verwaltung moderner Workloads kann zusätzliche Anforderungen an die Governance stellen. Um Unternehmen bei ihren Programmen zur Umsetzung regulatorischer Anforderungen zu unterstützen, bringt Red Hat OpenShift 4.10 drei neue Compliance-Profile mit. Diese ermöglichen es, einen Cluster auf Compliance zu überprüfen und die erkannten Probleme zu beheben. Die drei neuen Profile umfassen u.a. den Payment Card Industry Security Standard (PCI DSS) – ein Set von Sicherheitsstandards, das Unternehmen hilft, Kreditkarteninformationen zuverlässig zu akzeptieren, zu verarbeiten, zu speichern und zu übertragen.

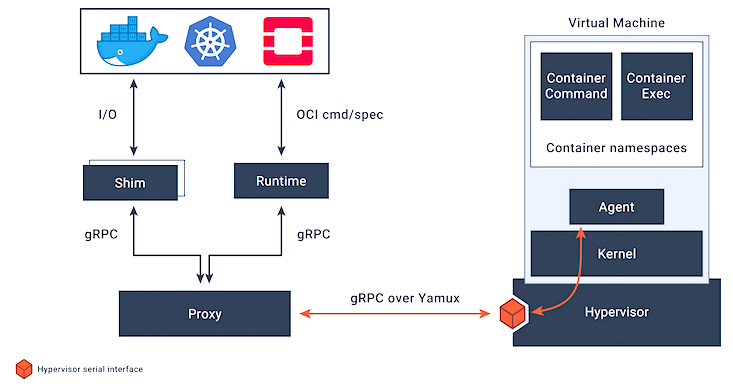

3. Mit Red Hat OpenShift 4.10 sind jetzt Sandbox-Container* allgemein verfügbar

Sandbox Containers basieren auf Kata Containers bieten eine zusätzliche optionale Schutzschicht für die Isolation von Workloads mit strengen Sicherheitsanforderungen auf Anwendungsebene. Weitere Verbesserungen erleichtern die Installation von nicht verbundenen OpenShift-Clustern beziehungsweise Clustern mit Air-Gap. Dadurch können Unternehmen gespiegelte OpenShift-Images leichter verwalten und stets aktuell halten, als würden sie sich in einem verbundenen Cluster befinden.

Bildquelle /Link > https://katacontainers.io/

*Anmerkung: Eine Sandbox ist eine isolierte Umgebung, in der Programme ausgeführt werden können. In einer Sandbox lassen sich ungetestete oder nicht vertrauenswürdige Programme ausführen, ohne Gefahr zu laufen, den Host-Rechner oder das Betriebssystem zu beschädigen. Im Kontext von OpenShift-Sandbox-Containern wird Sandboxing durch die Ausführung von Workloads in einem anderen Kernel unter Verwendung von Virtualisierung erreicht, was laut Entwickler eine bessere Kontrolle über die Interaktionen zwischen mehreren Workloads ermöglicht, die auf demselben Host ausgeführt werden. Es lassen sich OpenShift-Sandbox-Container auf Clustern mit OpenShift Virtualization verwenden. Um OpenShift Virtualization und OpenShift-Sandbox-Container gleichzeitig auszuführen, muss die Migration von VMs aktiviert werden, damit diese keine Knoten-Neustarts blockieren können (Quelle: Red Hat OpenShift).

Querverweis: