Starnberg, 08. Nov. 2022 - Weshalb der Vewaltung und Speicherung von kalten Daten mehr Aufmerksamkeit zukommen muss; unstrukturierte Daten, Tape, File- und Object...

Zum Beitrag: Folgt man dem IDC Global DataSphere Report*, soll sich das unternehmensbezogene Datenaufkommen in den nächsten 5 Jahren verdoppeln. Zitat: "The Enterprise DataSphere will grow more than twice as fast as the Consumer DataSphere over the next five years, putting even more pressure on enterprise organizations to manage and protect the world's data while creating opportunities to activate data for business and societal benefits." (*Quelle: John Rydning, research vice president, IDC's Global DataSphere). Link > https://www.idc.com/getdoc.jsp?containerId=US49018922

Es ist dabei von Bedeutung, dass die überwiegende Mehrzahl dieser erzeugten Datenformate File- oder objektbasiert verarbeitet werden, d.h. wir sprechen beim Unternehmenseinsatz von 80% und mehr an unstrukturierter Daten. Davon wird übrigens nur ein kleiner einstelliger Prozentsatz für Analysezwecke gespeichert- wo eigentlich der Wert dieser Daten als strategisches Asset für die digitale Transformation im Mittelpunkt stehen sollte... Hier besteht also dringend Handlungsbedarf.

Technologien wie Apache Hadoop ermöglichen die kosteneffiziente Durchführung von Big-Data-Analysen auf Basis von Open-Source-Technologien (die richtige Speichertechnologie entscheidet dann auch über den Projekterfolg). Gerade Analysen von historischen und anderen Daten, auf die nur selten zugegriffen wird können helfen, wettbewerbsfähiger zu bleiben. Leider ist es für viele gerade kleinere und mittlere Unternehmen aufgrund von Budgetbeschränkungen und fehlenden Fachkräften jedoch gerade schwierig, diese Ziele mit rein internen Plattformen (on-premise) zu erreichen. Public Cloud-Speicher andererseits bringen neue Herausforderungen in Bezug auf die Datenhoheit und -kontrolle mit sich. Auch die Zugriffs- und Speichergebühren, die beim Zugriff auf kalte Daten teuer werden können, sind nicht zu unterschätzende Faktoren.

Weshalb sind kalte Daten aus Umwelt- und Kostengründen verstärkt ein Thema?

Kalte Daten sind per se inaktive Daten, auf die nie oder nur selten zugegriffen wird. Die auf Grund von Digitalisierung stetig steigende Menge dieser Daten erfordert eine abgestimmte IT-Strategie hinsichtlich der dazu benötigten und geeigneten Datenverwaltungs-Werkzeuge und IT-Infrastrukturelemente. Neben Festplattenentwicklungen wie HAMR, MAMR etc. rückt Speichermedienseitig neben Flash (QLC etc.) für schnelle, energieeffizientere Zugriffe auch Tape für grosse Umgebungen sowie CSPs verstärkt in den Mittelpunkt (Haltbarkeit, Kapazität, Energieeffizienz, CO2-Reduktion, niedrige Kosten). Daneben spielen die entsprechenden Software-Verwaltungswerkzeuge (File-/Object etc.) eine zentrale Rolle.

Gerade Cloud-Service-Provider (CSPs) verzeichnen weiterhin ein starkes Wachstum, aber auch dort steigen natürlich die Kosten für die Datenspeicherung auf Grund der wachsenden Menge an. Aufgrund begrenzter Budgets, die mit der Speicherung großer Datenmengen in der Cloud verbunden sind, entwickeln sich Cold Storage Dienste deshalb rasch weiter. Klassische Cold Storage Anwendungsfälle sind neben der Archivierung in den Bereichen Backup und Disaster Recovery (DR) zu finden.

Aus Anwendersicht ist es dabei von Interesse, wie ein Cloud-basierter Cold-Storage beschaffen sein sollte, der kosteneffizient agiert, umweltfreundlich ist und gleichzeitig die Möglichkeit gibt, durch Big Data Analytics entsprechende Mehrwerte zu ziehen, indem Funktionen wie die Kundenbindung oder die Entwicklung neuer Produkte optimiert werden können. Das klingt vielleicht etwas nach einem gordischen Knoten und tatsächlich lassen sich nicht immer alle Ziele gleichermaßen unter einen Hut bringen. Eine gezielte Strategie, die versucht das Thema ‚cold data’ konsequent nachhaltig zu adressieren, ist aber ein guter Anfang und erlaubt es, mehr Struktur und Effizienz in die Datenspeicherung sowie Verwaltung zu bringen.

Energieeffizient speichern und CO2 reduzieren

CO2 ist ein Treibhausgas, das bei der Energieerzeugung freigesetzt wird. Festplatten- und SSD-Speichersysteme stoßen jährlich erheblich mehr CO2 aus als z.B. Bandbibliotheken, die nur dann online sind, wenn Daten darauf geschrieben oder für bestimmte Zwecke abgerufen werden (annähernd stromloses medium). Durch die Migration von kalten und weniger aktiven Daten auf Bandlaufwerke können Unternehmen ihre CO2-Emissionen erheblich reduzieren. Ein aktueller Report von ESG** zeigt hierzu eine 6,5-fache Verringerung der CO2-Emissionen, die sich aus der Ausführung von etwa 500 TB weniger aktiver Daten auf Bandlaufwerken im Vergleich zu Festplattenlaufwerken in einer (von ESG) modellierten Produktionsumgebung ergibt. Das Modell zeigt dabei die Ergebnisse der Verlagerung der Datenarbeitslast von Festplatte auf Band über einen Zeitraum von zwölf Monaten (**Quelle: www-esg-global.com - ESG First look Sustainability Benefits of Deploying LTO Technology in Modern IT Ecosystems. Date: September 2022. Author: Craig Ledo, Validation Analyst; and Vinny Choinsky, Senior Analyst).

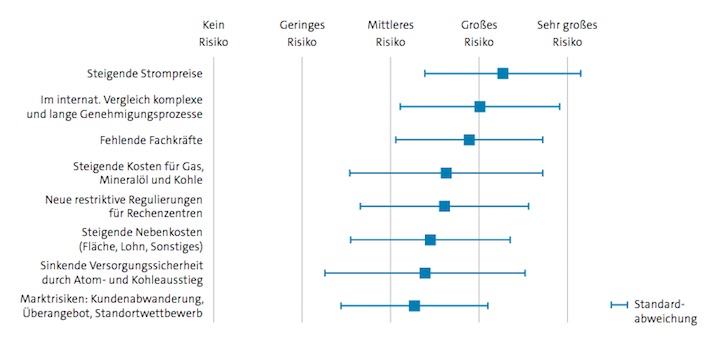

Abb. Risiken für den Rechenzentrumsmarkt – Expertenmeinungen. Bildquelle: Studie, Bitkom Rechenzentren in Deutschland, Aktuelle Marktentwicklungen, Stand 2022. Abbildung 21 – Quelle: Delphi-Befragung: Wie beurteilen Sie folgende Risiken für die Entwicklung des Rechenzentrumsmarktes in Deutschland? 2. Runde Delphi-Expertenbefragung durch Borderstep (12.–22.10.2021: n = 84).

Quelle / Link > https://www.bitkom.org/Bitkom/Publikationen/Rechenzentren-in-Deutschland-2022

Da Cold Storage überwiegend für dauerhafte und nicht flüchtige Daten ausgelegt ist, müssen SLAs dahingehend optimiert sein. Die automatisierte (zunehmend KI-basierte) Datenklassifizierung spielt darin eine wichtige Rolle. Nicht immer einfach zu beantworten und manuell immer weniger machbar: wer entscheidet, dass die Daten als wichtig genug erachtet werden, um sie aufzubewahren, und daher eine langfristige Speicherung erfordern? Beispiel: Daten werden auf Grundlage des Datums-/Uhrzeit des letzten Zugriffs in den kalten Speicher verschoben. Weitere SLA-Kriterien betreffen die TCO (Zugriffskosten), Zugriffsgeschwindigkeit sowie Sicherheit, Zugriffsberechtigung sowie Integrität der Daten.

Erasure Coding anstelle von Datenreplikation ist eine weitere Technologie, mit der sich Speicherkapazitäten reduzieren lassen. Als verteilter und skalierbarer Ansatz gegenüber z.B. RAID ermöglicht Erasure Code eine größere Toleranz gegenüber Festplattenausfällen und schnellere Laufwerkswiederherstellungs-Zeiten; wichtig bei hohen HDD-Kapazitäten. Die Daten können auch zwischen Rechenzentren verteilt werden, was die beschleunigte Wiederherstellung im Bedarfsfall unterstützt.

Ein Fazit: Für alle Nutzungsmodelle und Bedarfssituationen muss Cold Storage ein breites Spektrum an Anforderungen erfüllen. Neben Leistung, Datenintegrität, Sicherheit, Kompatibilität etc. sind verstärkt auch Aspekte der Umweltverträglichkeit wie CO2-Reduktion zu berücksichtigen.

Weitere Informationen zum Thema (ohne Anspruch auf Vollständigkeit) finden Sie nachfolgend unter diesen Links:

Unser Beitrag > Tape im Rechenzentrum- erweiterte Einsatzgebiete, Technologien und Vorteile

Im Podast nachgefragt > Objektdaten-Speicherung, NAS-Migrationen und globale File Services

Im Podcast nachgefragt > Details zur Active Scale Cold Storage Strategie von Quantum

Blogpost > Verteilte Filesysteme & Objektspeicher: Kommentar zum Gartner Magic Quadrant 2022 Update

Unser Beitrag > Wie Green IT der Schlüssel zur Wettbewerbsfähigkeit werden kann