Starnberg, 26. April 2018 - Der Hype um neue Entwicklungen hält an; was ist davon zu halten...

Um was es hier geht: Die CPU-Entwicklung mittels Multicore-Prozessoren (Moore's Law) führte bislang immer noch zu einem relativ linearem Wachstum bei der Serverleistung, im Gegensatz zu drehenden Festplatten, die nicht über 15k hinauskommen. NAND-Flash als Nachfolger ist zwar I/O-seitig schnell, aber die bislang überwiegend verwendeten Protokoll-Stacks und Interfaces auf Basis SATA und SAS mit ihren Overheads nutzen diese Leistung nicht optimal, weshalb für High Performance Anwendungen mit NVMe (ohne komplexen SCSI-Stack) eine Alternative sich entwickelt und das I/O-Gap (CPU vs. Disk) damit zu verringern hilft. Gängige I/O-Operationen mit Flash SSDs bringen CPUs selten an ihre Grenzen, außer bei komplexen schreibintensiven RAID-6 Operationen z.B. in Verbindung mit NVMe Flash SDDs wegen der Host-Interrupts. Flashspeicher wie SSDs sind jedenfallsin der Lage, viel höhere Übertragungsgeschwindigkeiten bei geringeren Latenzen zu erreichen, aber ohne eine optimierte Softwareschnittstelle-/Treiber können sie ihr volles Potenzial nicht ausschöpfen. NVMe wurde speziell entwickelt, um sowohl Parallelität als auch reduzierte Latenzen von PCIe über die physikalische Schnittstelle zu nutzen.

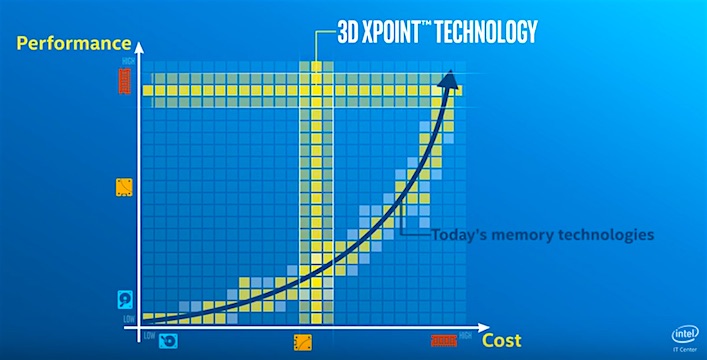

NVMe und NVMeoF in Verbindung mit kommenden (Storage Class Memory, SCM) Speicheroptionen wie Intel® OptaneTM und Micron (QuantX) als 3D Xpoint Technologie oder Samsung Z-NAND als transistorlose Speicher (siehe > Phase Change Memory) versprechen latenz-optimierten I/O für High-Performance Apps, die von dieser IOPS- und Durchsatz-Leistung dann auch profitieren werden (ab 2019); aber das gilt natürlich nicht für jede Art von Anwendung im Unternehmen. Positiv betroffen davon sind hauptsächlich NoSQL und SQL-basierte (In-Memory) Datenbanken oder Apache Cassandra / MongoDB etc. Auch Real-time Data Analytics, Hadoop und natürlich typische HPC-Workloads profitieren von diesen Entwicklungen.

Sie sehen schon: wir sprechen hier nicht unbedingt über "klassische" Standard-Anwendungen, die solche Leistungssprünge I/O-seitig (noch) nicht benötigen, sondern typischerweise von einer begrenzten Anzahl zum Teil neuer Kernanwendungen, die allerdings aus Betriebs- und Unternehmenssicht wichtiger werden; und weitere neue Speichertechnologien wie HPE Memristor (Überbegriff: ReRAM) oder PCM (z.B. IBM) sind bereits in Entwicklung, einiges kann davon vielleicht schon in den nächsten drei bis vier Jahren marktreif werden... NVDIMM auf Basis SCM mit direkter Adressierbarkeit ist ein weiterer Entwicklungsschritt, verlangt jedoch nach Änderungen bei Anwendungen und dem Server-Storage-Layer.

Fazit: Unternehmen sollten sich vor dem Hype um neue Technologien nicht verunsichern lassen und in jedem Fall muss vor der Beschaffung sorgfältig gegen den potenziellen Nutzen abgewogen werden. Neue hochleistungsfähige Schnittstellen zwischen Server CPU und Storage, die einen parallelen Zugriff ermöglichen, können zwar die Latenzzeiten für den Speicherzugriff reduzieren, erfordern jedoch meist zusätzliche Investitionen bzw. Upgrades in bestehenden Systeme.

Wie immer bei neuen und aus Betriebssicht durchaus komplexen Technologien gilt: Analysieren Sie zuerst genau die Versprechungen der Anbieter in Bezug auf Leistung, Zuverlässigkeit und Betriebskosten. Fragen Sie nach Referenzen und möglichst realen Benchmark-Zahlen, die Ihren realen Anwendungs-Workloads am ehesten entsprechen.

Abb. 1: Revolutionizing the Storage Media Pyramid with 3D XPoint Technology (Bildquelle: Intel YouTube Video)