Las Vegas (US), Starnberg, 24. Aug. 2023 - Verbesserter Datenschutz, Sicherheit und Kontrolle mit integrierten KI-Tools; Full-Stack Computing mit vSAN Express NVMe-Storage...

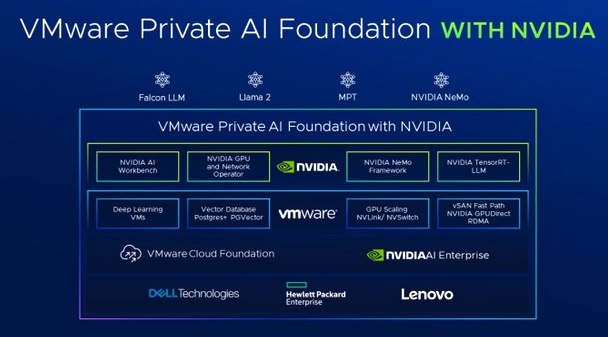

Zur Ankündigung: VMware und NVIDIA gaben die Ausweitung ihrer Partnerschaft bekannt, um die Vielzahl an Unternehmen, die die Cloud-Infrastruktur von VMware nutzen, für die generative KI vorzubereiten. VMware Private AI Foundation mit NVIDIA soll es Unternehmen ermöglichen, Modelle anzupassen und generative KI-Anwendungen auszuführen, darunter intelligente Chatbots, Assistenten, Suchfunktionen, Zusammenfassungen etc. Die Plattform wird laut Anbieter eine vollständig integrierte Lösung mit generativer KI-Software und beschleunigtem Computing von NVIDIA umfassen, die auf VMware Cloud Foundation aufbaut und für KI optimiert ist. VMware plant die Veröffentlichung von VMware Private AI Foundation mit NVIDIA für Anfang 2024.

Full-Stack Computing für eine bessere generative KI

Um schneller Geschäftsvorteile zu erzielen, versuchen Unternehmen, die Entwicklung, das Testen und den Einsatz von generativen KI-Anwendungen zu rationalisieren. McKinsey schätzt, dass generative KI den Umsatz der Weltwirtschaft jährlich um bis zu 4,4 Billionen Dollar steigern könnte. (1)

VMware Private AI Foundation mit NVIDIA soll es ermöglichen, große Sprachmodelle anzupassen, sicherere und private Modelle für den internen Gebrauch zu erstellen, generative KI als Service für ihre Anwender anzubieten und Inferenz-Workloads in größerem Umfang sicher auszuführen. Die Plattform wird laut VMware voraussichtlich integrierte KI-Tools enthalten, mit denen Unternehmen bewährte Modelle, die auf ihren privaten Daten trainiert wurden, kosteneffizient ausführen können. Sie basiert auf der VMware Cloud Foundation und der NVIDIA AI Enterprise Software und bietet folgende Leistungsmerkmale-/Vorteile (Quelle VMware):

Datenschutz - Kunden können KI-Dienste problemlos überall dort ausführen, wo sie Daten haben, und zwar mit einer Architektur, die den Datenschutz wahrt und einen sicheren Zugriff ermöglicht.

Wahlfreiheit - Unternehmen erhalten eine größere Auswahl bei der Erstellung und Ausführung ihrer Modelle - von NVIDIA NeMo™ bis Llama 2 und darüber hinaus - einschließlich führender OEM-Hardware-Konfigurationen und in Zukunft auch bei Public Cloud- und Service-Provider-Angeboten.

Leistung - Die Ausführung auf einer schnellen NVIDIA-Infrastruktur liefert in einigen Anwendungsfällen eine Leistung, die der von Bare Metal gleichkommt oder diese sogar übertrifft, wie aktuelle Branchen-Benchmarks zeigen.

Skalierung im Rechenzentrum - Optimierungen der GPU-Skalierung in virtualisierten Umgebungen ermöglichen die Skalierung von KI-Workloads auf bis zu 16 vGPUs/GPUs pro virtueller Maschine und über mehrere Knoten hinweg, um die Feinabstimmung und Bereitstellung generativer KI-Modelle zu beschleunigen.

Geringere Kosten - Maximale Nutzung aller Rechenressourcen (GPUs, DPUs und CPUs), um die Gesamtkosten zu senken und eine gepoolte Ressourcenumgebung zu schaffen, die effizient von verschiedenen Teams genutzt werden kann.

Schnelleres Networking - Die tiefe Integration zwischen vSphere und der NVIDIA NVSwitch™-Technologie ermöglicht die Ausführung von Multi-GPU-Modellen ohne Engpässe zwischen den GPUs.

Beschleunigte Bereitstellung und Time-to-Value - vSphere Deep Learning-VM-Images und Image-Repository ermöglichen schnelles Prototyping, indem sie ein stabiles, schlüsselfertiges Solution Image bieten, bei dem Frameworks und leistungsoptimierte Bibliotheken vorinstalliert sind.

Schnellerer Storage - Die VMware vSAN Express Storagearchitektur bietet Performance-optimierten NVMe-Speicher und unterstützt GPUDirect®-Speicher über RDMA, was eine direkte E/A-Übertragung vom Speicher zu den GPUs ohne CPU-Beteiligung ermöglicht.

Unsere Anmerkung: Introducing vSAN 8 Update 2 and VMware vSAN Max. vSAN Max ermöglicht ein neues, optionales, disaggregiertes Speicherbereitstellungsmodell, das auf der vSAN Express-Speicherarchitektur aufbaut. vSAN 8 U2 bringt zudem vSAN-Dateidienste in die Express Storage Architecture. Link > https://www.vmware.com/products/vsan/whats-new.html

Bildquelle: VMware. Link > https://www.vmware.com/products/vsphere/ai-ml.html

Die Plattform wird dann laut Anbieter NVIDIA NeMo enthalten - ein durchgängiges, cloud-natives Framework - das Teil der NVIDIA AI Enterprise – dem Betriebssystem der NVIDIA AI-Plattform – ist. Es ermöglicht Unternehmen, generative KI-Modelle praktisch überall zu erstellen, anzupassen und einzusetzen. NeMo kombiniert Anpassungs-Frameworks, Guardrail-Toolkits, Datenkuratierungs-Tools und vortrainierte Modelle, um Unternehmen einen einfachen, kostengünstigen und schnellen Weg zur Einführung generativer KI zu bieten.

Für den Einsatz von generativer KI in der Produktion verwendet NeMo TensorRT for Large Language Models (TRT-LLM), das die Inferenzleistung der neuesten LLMs auf NVIDIA-GPUs beschleunigt und optimiert. Mit NeMo ermöglicht die VMware Private AI Foundation NVIDIA Unternehmen, ihre eigenen Daten einzubringen, um benutzerdefinierte generative KI-Modelle in der Hybrid-Cloud-Infrastruktur von VMware zu erstellen und auszuführen.

Ökosystem-Support für VMware Private AI Foundation mit NVIDIA

VMware Private AI Foundation mit NVIDIA wird von Dell Technologies, Hewlett Packard Enterprise und Lenovo unterstützt. Diese Unternehmen gehören nach vorliegenden Angaben von VMware zu den ersten, die Systeme anbieten, die mit NVIDIA L40S GPUs, NVIDIA BlueField®-3 DPUs und NVIDIA ConnectX®-7 SmartNICs die LLM-Anpassung und Inferenz-Workloads in Unternehmen optimieren.

- NVIDIA L40S GPU soll eine bis zu 1,2-fach höhere generative KI-Inferenzleistung und eine bis zu 1,7-fach höhere Trainingsleistung im Vergleich zur NVIDIA A100 Tensor Core GPU erreichen können.

- NVIDIA BlueField-3 DPUs beschleunigen, entlasten und isolieren die enorme Rechenlast von Virtualisierung, Netzwerk, Speicher, Sicherheit und anderen Cloud-nativen KI-Diensten von der GPU oder CPU.

- NVIDIA ConnectX-7 SmartNICs für die Rechenzentrumsinfrastruktur, um auch anspruchsvolle KI-Workloads zu unterstützen.

(1) Quelle: "The economic potential of generative AI: The next productivity frontier, McKinsey, 2023"

Querverweis:

Unser Blogpost > Speicheranforderungen bei KI-Anwendungen: Randbedingungen und Einsatzkriterien

Unser Beitrag > Wie Unternehmen mit Machine Learning (KI) Geschäftswerte erzeugen können