München, Starnberg, 29. Aug. 2023 - Leistungsfähige Open Source Tools und low-latency Infrastrukturen zum Einstieg in die Echtzeit-Datenverarbeitung; ein Beitrag von Hazelcast…

Zum Hintergrund: Verbraucher erwarten heute schnelle, unkomplizierte Transaktionen – egal ob in der Banking-App, an der Supermarktkasse, im Webshop oder einem Buchungsportal. Die Erfüllung dieser hohen Ansprüche ist gerade für kleinere- und mittelständische Unternehmen nicht immer einfach. Herkömmliche Lösungen sind zu teuer oder zu kompliziert; oft sind sie beides. Service Provider können mit mandantenfähigen Plattformen für Data-in-Motion ihr Portfolio erweitern und neue Kunden erreichen. Wie das funktionieren kann, hat Avtar Raikmo, Head of Enginieering bei Hazelcast, für Sie in seinem folgenden Beitrag zusammengefasst (1):

Zum Beitrag: „Verbrauchern ein individuelles, unkompliziertes Erlebnis zu bieten, erfordert die schnelle Verarbeitung von Daten. Oft müssen die Daten dazu zwischen verschiedenen Anwendungen bewegt, mit historischen Daten korreliert oder Informationen von Dritten abgefragt werden. Data-in-Motion bezeichnet die Verarbeitung großer Informationsmengen und Datenströme in Echtzeit. In der Vergangenheit mussten dafür aufwändig Schnittstellen eingerichtet und gepflegt, Unmengen an Daten vorgehalten und teure Analyse-Software erworben werden. Für kleine und mittelgroße Unternehmen war dies in der Regel nicht zu leisten.

Cloud Computing, Analytics as a Service und Open Source liefern neue Optionen

Service Provider verfügen in der Regel bereits über Anbindungen an SaaS-Anbieter und öffentliche Cloud-Plattformen. Das sind ideale Voraussetzungen, um zum Drehkreuz für die Datenströme ihrer Kunden zu werden. Open-Source-Plattformen mit vorkonfigurierten Konnektoren und Schnittstellen für die Echtzeit-Stream-Verarbeitung erleichtern den Einstieg in das neue Geschäftsmodell. Mit Data-in-Motion as a Service ermöglichen sie auch kleineren und mittelständischen Anbietern, ihren Kunden die gleichen Erlebnisse zur Verfügung zu stellen wie große Online-Dienste oder Supermarktketten mit schnellen, unkomplizierten Bezahlvorgängen oder individuellen Dienstleistungsangeboten.

Mit Virtualisierung und AI schnell zum Erfolg

Fortschrittliche Plattformen zur Verarbeitung von Streams in Echtzeit sind für verschiedene Einsatzszenarien geeignet. Es gibt sie zum Download entweder als fertiges VMware- oder Docker-Image zur Installation on-premises, in der Cloud oder sogar auf Bare Metal. Künstliche Intelligenz unterstützt die Stream Processing Engine bei der Verarbeitung und Verteilung der Datenströme.

Der Einsatz robuster und schneller Datenspeicher wie Persistent Memory, PMEM mit der Stream Processing Engine erlaubt es, geschäftskritische Daten aus verschiedenen Quellen abzurufen und im gleichen System für die Weiterverarbeitung aufzubereiten. Einheitliche Plattformen skalieren bis zu mehr als einer Milliarde Transaktionen pro Sekunde bei extrem niedriger Latenz. Zudem reduzieren sie die Komplexität. Es müssen nicht mehr zwei separate Systeme, die sich zudem oft unterschiedlich verhalten, angeschafft, installiert, getestet, optimiert und gewartet werden.

Mit Machine Learning können Streaming-Ereignisse über einen bestimmten Zeitraum berechnet und aggregiert werden. Diese Daten dienen wiederum als Input für das Training des Algorithmus. So lassen sich z. B. Trends für die Anzahl der in einem bestimmten Zeitraum durchgeführten Transaktionen ableiten. Als Service hilft es auch einem kleineren mittelständischen Unternehmen, bessere Forecasts zu generieren und vorausschauender zu planen.

Offene Schnittstellen, Standards und Open Source sorgen für ein hohes Maß an Transparenz, aber auch für größtmögliche Interoperabilität. Vorkonfigurierte Konnektoren für die gängigsten Dienste und Anbieter erlauben einen schnellen Start ohne Expertenwissen. Es müssen keine komplizierten Pipelines für die Datenströme aufgebaut oder Schnittstellen programmiert werden. Davon profitieren vor allem die Unternehmen, denen das nötige Fachpersonal fehlt oder deren IT-Teams ohnehin schon überlastet sind.

Aus Compliance-Sicht sollte auf die Auditfähigkeit der Lösung geachtet werden. Nicht alle Produkte bieten ein spezielles Stream-Processing-Audit. Damit lässt sich nachvollziehen, was in der Engine passiert oder warum ein KI/ML-System eine bestimmte Entscheidung getroffen hat. Das gibt auch kleineren Anbietern mehr Sicherheit bei der Verarbeitung der Daten ihrer Kunden.

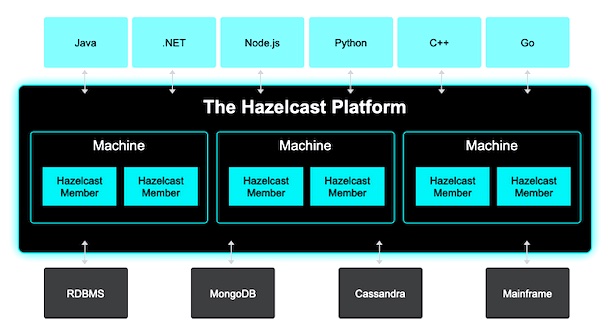

Bildquelle: Hazelcast Low-Latency Storage

Anmerkung: Hazelcast verbindet eine Reihe von vernetzten-/geclusterten Rechnern, um deren Arbeitsspeicher (RAM) und CPU-Leistung zusammenzufassen, damit Anwendungen Datenstrukturen gemeinsam nutzen und parallelisierte Arbeitslasten im Cluster ausführen können. Hauptvorteil ist die Geschwindigkeit, die in einer Umgebung mit einer Vielzahl von mobilen Geräten, IoT-Geräten und anderen Quellen, die kontinuierlich Daten streamen, von entscheidender Bedeutung geworden ist.

Die Macht der Gemeinschaft

Open Source hat einen entscheidenden Vorteil: IT-Architekten und Entwickler aus einer Vielzahl von Branchen können bestehende Anwendungen modernisieren oder sogar neue innovative Dienste bereitstellen. Solche Erweiterungen fließen oft direkt in die Plattform ein oder sind über Marktplätze leicht für jeden Nutzer der Plattform zugänglich.

- Community-Versionen der Plattform werden oft kostenlos zum Download angeboten. Damit kann ein Service Provider das Potenzial der Echtzeit-Stream-Verarbeitung für sich zunächst testen.

- Open Source leistet zudem einen wichtigen Beitrag für die IT-Sicherheit. Transparenz und Offenheit helfen dabei, potenzielle Schwachstellen früh und zuverlässig zu erkennen. Die vereinte Kraft einer großen Entwickler-Community garantiert die schnelle Verfügbarkeit von Patches und Updates.

Fazit

Stream-Verarbeitung in Echtzeit bietet Unternehmen das Potential, Wettbewerbsvorteile auszubauen und die Zufriedenheit von Anwendern und Verbrauchern zu steigern. Mit mandantenfähigen Plattformen haben Systemhäuser und Service Provider die Möglichkeit, ihr Geschäftsmodell für bestehende und neue Kunden zu erweitern. Systemintegratoren und Service Provider verfügen zudem über fundierte Branchenkenntnisse und die notwendigen technischen Ressourcen, um eine Plattform speziell auf die Bedürfnisse ihrer Kunden anzupassen. Das schafft neue USP und als Teil der Community erhalten sie wiederum wertvollen Input aus dem Netzwerk. Günstigere, leistungsfähige Infrastruktur und Open Source ermöglichen auch kleineren Anbietern den Einstieg in die Echtzeit-Verarbeitung von Daten. Der Rückhalt einer starken Community hilft bei der Vorstellung, wie die Technologie effektiv eingesetzt werden kann - jetzt und in Zukunft.“

(1) Avtar Raikmo ist Head of Engineering bei Hazelcast und von Großbritannien aus für die Echtzeit-Stream-Processing-Plattform tätig. Seine Karriere begann er als Entwickler von Java-, Python-, C#- und C++-Lösungen, bevor er leitende Positionen bei Goldman Sachs, Morningstar und Meta (Facebook) übernahm. Sein Interesse gilt den Herausforderungen, vor denen Unternehmen stehen, die riesige Datenmengen verarbeiten müssen.

Querverweis:

Unser Beitrag > In-Memory-Computing: Hazelcast erweitert Cloud-basierte Applikations-Architektur

Unser Podcast > Low Latency Storage, Hot Data und die richtige Datenstrategie