San Jose (CA), Starnberg, 25. Sept. 2023 – Globale Ausbreitung künstlicher Intelligenz als ‚Siliconomy‘ via Chips und Software-Strategien; Verarbeitung von Daten im Mittelpunkt …

Zum Hintergrund: Die globale Ausbreitung künstlicher Intelligenz setzt laut Intel die ‚Siliconomy,‘ in Gang – eine neue Zeit beflügelt von Silizium und Software. Im Rahmen der dritten Intel Innovation in San José (Kalifornien, USA) am 19./20. Sept. wurden am ersten Tag eine Reihe von Technologien vorgestellt, die künstliche Intelligenz (KI) in alle Lebensbereiche bringen und laut dem Unternehmen für jede Art von Anwendung zugänglich sein soll. (1) Entwickler, die sich KI zunutze machen wollen, sehen sich laut Intel derzeit mit Herausforderungen konfrontiert, die einen breiten Einsatz dieser Lösungen für Clients und im Edge bis hin zu Rechenzentrum und Cloud behindern.

In seiner Eröffnungs-Keynote erläuterte Intel CEO Pat Gelsinger dazu, wie KI die Zukunft prägen wird. Zitat: „KI markiert einen Generationenwechsel und läutet eine neue Ära großer Veränderungen weltweit ein. Dabei spielt die Datenverarbeitung eine noch bedeutendere Rolle als bisher. Entwickler:innen eröffnet dies gesellschaftlich wie auch geschäftlich ganz neue Möglichkeiten, um die Grenzen des Machbaren zu erweitern und Lösungen für die drängendsten globalen Herausforderungen zu entwickeln – mit dem Ziel, das Leben und die Zukunft aller Menschen auf unserem Planeten zu verbessern.“

CTO Greg Lavender gab am zweiten Tag einen detaillierten Überblick darüber, wie Intels Philosophie des offenen Ökosystems, bei dem Entwickler im Vordergrund stehen, dazu beiträgt, dass die Möglichkeiten der künstlichen Intelligenz (KI) für alle zugänglich sind. Entwickler, die sich KI zunutze machen wollen, sehen sich mit Herausforderungen konfrontiert, die den breiten Einsatz von Lösungen für Client und Edge bis hin zu Rechenzentrum und Cloud behindern. Intel verpflichtet sich danach, diese Herausforderungen mit einem umfassenden softwaredefinierten, siliziumbeschleunigten Ansatz anzugehen, der auf Zitat: „Offenheit, Wahlmöglichkeiten, Vertrauen und Sicherheit basiert.“

Nachfolgend die wichtigsten Highlights, die während der Innovation präsentiert wurden. Quelle Intel (1):

Intel bestätigte, dass der „five-nodes-in-four-years“ (5N4Y) Plan für die Prozesstechnologie planmäßig verläuft und demonstriert das weltweit erste Multi-Chiplet-Package mit Universal Chiplet Interconnect Express (UCIe)-Verbindungen.

Es wurden neue Details zu den Intel® Xeon® Prozessoren der nächsten Generation bekanntgegeben, darunter bedeutende Fortschritte bei der Energieeffizienz und Leistung sowie ein E-Core-Prozessor mit 288 Kernen. Intel® Xeon® Prozessoren der 5. Generation werden am 14. Dezember eingeführt.

Der KI-PC kommt mit der Einführung der Intel® Core™ Ultra Prozessoren am 14. Dezember auf den Markt. Mit Intels erster integrierter neuronaler Prozessorseinheit wird der Core Ultra eine energieeffiziente KI-Beschleunigung und lokale Inferenz auf dem PC ermöglichen.

Ein KI-Supercomputer wird auf Basis der Intel Xeon Prozessoren und Intel® Gaudi®2 KI-Hardwarebeschleunigern gebaut, mit Stability AI als wichtigem Kunden.

Ankündigung der allgemeinen Verfügbarkeit der Intel® Developer Cloud für die Entwicklung und das Testen von Hochleistungsanwendungen wie KI, inklusive Anwendungsfällen von Kunden.

Neue und künftige Intel-Softwarelösungen, einschließlich der Version 2023.1 des Intel® Distribution of OpenVINO™-Toolkits, werden Entwickler:innen helfen, neue KI-Funktionen zu entwickeln.

Allgemeine Verfügbarkeit eines neuen Zertifizierungsdienstes, der Teil der Intel® Trust Authority ist und eine einheitliche, unabhängige Bewertung der Integrität der vertrauenswürdigen Ausführungsumgebung (TEE) von Intel sowie der Durchsetzung von Richtlinien und Audit-Aufzeichnungen bietet.

Zusammenarbeit mit führenden Softwareanbietern, darunter Red Hat, Canonical und SUSE, um Intel-optimierte Distributionen bereitzustellen, die Entwicklern den Zugang zu der Hardware und Software ermöglichen, die sie zur Leistungssteigerung benötigen.

Intel tritt der neu gegründeten Unified Acceleration Foundation der Linux Foundation bei und wird seine oneAPI-Spezifikation beisteuern, um die plattformübergreifende Entwicklung über mehrere Architekturen hinweg zu fördern.

Intel kündigte Pläne zur Entwicklung eines ASIC-Beschleunigers (Application Specific Integrated Circuit) an, um den mit der vollständig homomorphen Verschlüsselung (FHE) verbundenen Leistungs-Overhead zu reduzieren, und wird im Laufe des Jahres die Beta-Version eines Software-Toolkits für verschlüsselte Datenverarbeitung für Entwickler veröffentlichen.

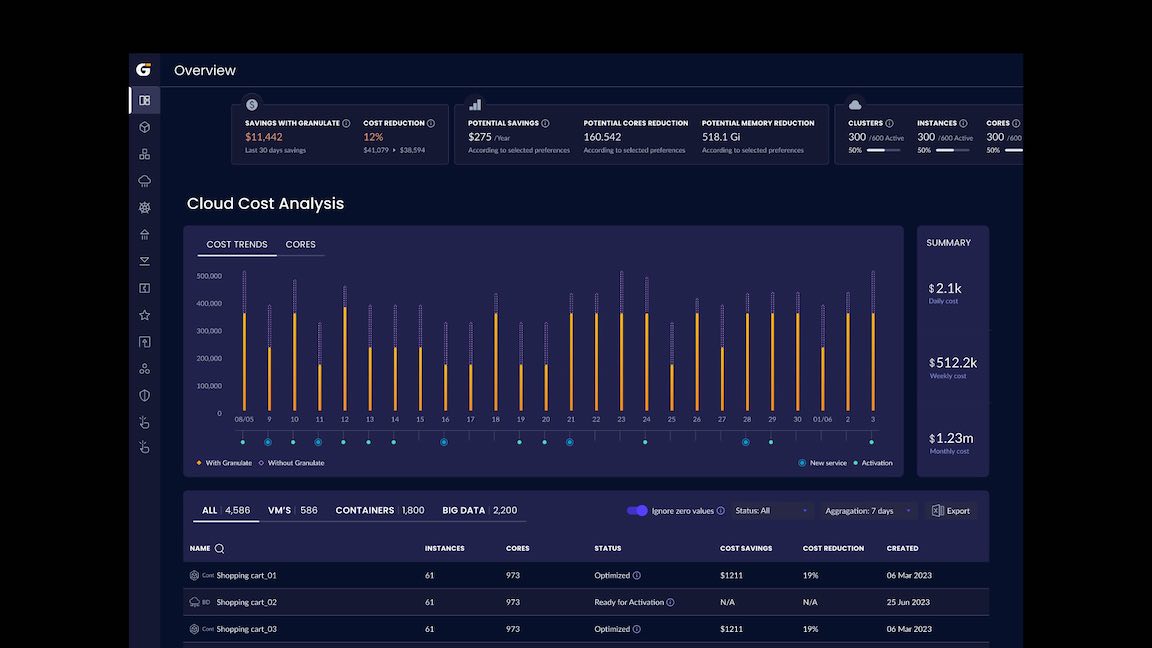

Abb.: Intel Granular Dashboard, Cloud Cost Analysis (Bildquelle: Intel Innovation 2023).

Anmerkung: Um Entwickler bei der schnellen und einfachen Skalierung der Leistung zu unterstützen, fügt Intel Granulate Auto Pilot für die Ressourcenanpassung von Kubernetes-Pods hinzu. Das Tool zur Kapazitätsoptimierung bietet automatische und kontinuierliche Empfehlungen zur Kapazitätsverwaltung für Kubernetes-Nutzer. Dies ermöglicht es ihnen, die Investitionen zu reduzieren, die erforderlich sind, um ihre Kosten-Leistungs-Metriken für containerisierte Umgebungen zu erfüllen. **

(1) Quelle / externer Link > https://www.intel.com/content/www/us/en/events/on-event-series/innovation.html

Weitere Details zu den Ankündigungen (Auszug / Quelle: Intel Originaltext):

„Intel is expanding on its platform security and data integrity protection with several new tools and services, including general availability of a new attestation service. This service is the first in a new portfolio of security software and services called Intel® Trust Authority. It offers a unified, independent assessment of trusted execution environment integrity and policy enforcement, and audit records, and it can be used anywhere Intel confidential computing is deployed, including multi-cloud, hybrid, on-premises and at the edge. Intel Trust Authority will also become an integral capability to enable confidential AI, helping ensure the trustworthiness of confidential computing environments in which sensitive intellectual property (IP) and data are processed in machine-learning applications, particularly inferencing on current and future generations of Intel® Xeon® processors.

AI is an engine of innovation with use cases across every industry, from healthcare and finance to e-commerce and agriculture. “Our AI software strategy is founded on open ecosystems and open accelerated computing to deliver AI everywhere,” said Lavender. “There are endless opportunities to scale innovation and we are creating a level playing field for AI developers.”

Open Ecosystem Facilitates Choice with Optimized Performance

Organizations around the world are using AI to accelerate scientific discovery, transform business and improve consumer services. However, the practical application of AI solutions is limited by challenges that are difficult for businesses to overcome, from a lack of in-house expertise and insufficient resources to properly manage the AI pipeline (including data prep and modeling) to costly proprietary platforms that are expensive and time-consuming to maintain on an ongoing basis.

Intel is committed to driving an open ecosystem that allows for ease of deployment across multiple architectures. This includes being a founding member of the Linux Foundation’s Unified Acceleration Foundation (UXL). This cross-industry group is committed to delivering an open accelerator software ecosystem to simplify development of applications for cross-platform deployment. UXL is an evolution of the oneAPI initiative. Intel's oneAPI programming model allows for code to be written once and deployed across multiple computing architectures, including CPUs, GPUs, FPGAs and accelerators. Intel will contribute its oneAPI specification to the UXL Foundation to help drive cross-platform development across architectures.

Intel is also collaborating with leading software vendors Red Hat, Canonical and SUSE to provide Intel-optimized distributions of their enterprise software releases to help ensure optimized performance for the latest Intel architectures. Today at Innovation, Lavender was joined by Gunnar Hellekson, vice president and general manager for the Red Hat Enterprise Linux business, to announce an expanded collaboration that will see Intel contribute upstream support for the Red Hat Enterprise Linux (RHEL) ecosystem using CentOS Stream. Intel also continues to contribute to AI and machine-learning tools and frameworks, including PyTorch and TensorFlow.

** To help developers scale performance quickly and easily, Intel Granulate is adding Auto Pilot for Kubernetes pod resource rightsizing. The capacity-optimization tool will offer automatic and continuous capacity management recommendations for Kubernetes users. This will enable them to reduce the investment required to meet their cost-performance metrics for containerized environments. Intel Granulate is also adding autonomous orchestration capabilities for Databricks workloads, which will deliver an average of 30% cost reduction and 23% processing time reduction with no code changes.

As the world relies more on AI to solve large and complex problems and deliver real business outcomes, there is a growing need to protect AI models, data and the platforms on which they run from tampering, manipulation and theft. Fully homomorphic encryption (FHE) allows for compute calculations to be performed directly on encrypted data, even though practical implementations are limited by computational complexity and overhead.

Intel said it plans to develop an application-specific integrated circuit (ASIC) accelerator to reduce the million-fold performance overhead associated with a software-only FHE approach. In addition, the company will launch the beta version of an encrypted computing software toolkit, which will enable researchers, developers and user communities to learn and experiment with FHE coding. This will come later this year as part of Intel® Developer Cloud, the general availability of which was announced yesterday, and will include a set of interoperable interfaces to develop FHE software, translation tools and a sample simulator of its hardware accelerator…“

Querverweise:

Unser Beitrag > Angebot zur intelligenten Migration in die Cloud: Zusammenarbeit von HashiCorp und Intel

Unser Beitrag > Intel und der Bund einigen sich auf erweiterten Umfang der Wafer-Fertigung in Magdeburg

Unser Blogpost > Wirtschaftliche Alternativen zu Intel® Optane™ Persistent Memory SCM Technologie