Starnberg, 01. Aug. 2022 - Intel kündigt an, die Storage Class Memory (SCM) Optane™ Produktion einzustellen; zum Hintergrund und welche alternativen Lösungen bieten sich?

Zum Inhalt dieses Blogpost: Künstliche Intelligenz, High-Performance-Computing (HPC), In-Memory-Datenbanken oder Internet of Things (IoT)… Anwendungen werden immer leistungshungriger und stellen auch teils sehr spezifische Leistungsanforderungen an Speichersysteme. Angesichts der fast explosionsartigen Zunahme der Datenmengen ist deshalb der Bedarf an datenzentrierten Lösungen für verschiedene Arbeitslasten so groß wie nie zu vor. Intel hat zusammen mit Micron bereits 2015 angefangen, mit Optane und der 3D-X-Point Technologie als persistenter Speicher (schneller als Flash, aber günstiger als DRAM) die Lücke zwischen DRAM und den preiswerteren Flash-SSD Modulen mit Hilfe einer neuen Storage Class Memory (SCM) Technologie - höchstwahrscheinlich auf Basis von Phase Change Memory, PCM - zu schließen.

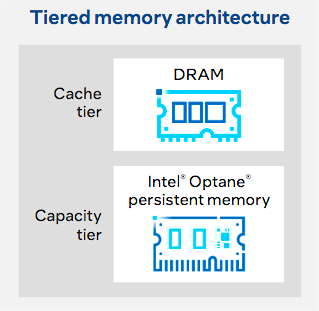

Eine Herausforderung: Optane kann in Form von DIMMs von der Host-System-Software des Servers auf Grund der langsameren Geschwindigkeit gegenüber DRAM (s.a. app-direct-mode) ohne SW-Änderungen nicht direkt adressiert werden. Bis zu 6-fache Leistungswerte im Durchsatz gegenüber NAND-basierten SSDs (Quelle: Intel) und eine über 60 x höhere I/O-Response time bei Random Read Queue Depth von 1-4 sowie Latenzzeiten im Bereich von 7μs -10μs (reads, writes) sind hingegen als Laufwerksleistung höchst respektabel, reichen jedoch nicht an DRAM-Performancewerte heran, weshalb Memory-Tiering als Anwendungsfall einen wichtigen Einsatzbereich darstellt- s.a. Abb. 1 unten.

Die Lösung wurde jedenfalls wohl nicht so gut am Markt angenommen wie erhofft und auch die Leistungswerte blieben gegenüber den Erwartungen zurück (Preis-/Leistung). Ein weiterer Grund: der Bereich passt nicht mehr in die aktuelle Strategie von Intel (der Hersteller hatte ja bereits vor einiger Zeit sein NAND- und Flash-SSD-Geschäft an SK Hynix veräußert). Letzte Woche wurde jetzt offiziell das Produktions-Aus für Optane™ bekannt gegeben (Quelle / Link > https://www.intel.com/content/www/us/en/support/articles/000059551/memory-and-storage/ssd-management-tools.html ).

Abb. 1: Tiered Memory Architektur (Bildauszug / Quelle: Intel Optane Whitepaper).

Es gibt heute weitere Möglichkeiten, mehr Speicher in einen Server zu bekommen, ohne dafür sehr viel teure DRAM-Module beschaffen zu müssen. Der sich gerade weiterentwickelnde Compute Express Link (CXL) als offener Industriestandard ermöglicht Verbindungen mit hoher Bandbreite und niedriger Latenz zwischen dem Host-Prozessor und Geräten wie Beschleunigern, Memory Buffers sowie intelligenten E/A-Geräten. Server sind damit in der Lage, mehr Speicher zu adressieren, indem sie über CXL auf einen externen Memory-Pool zugreifen können, der von mehreren Hosts gemeinsam genutzt wird und in Bezug auf die Speicherkosten pro Server günstiger ist. ( Stichwort: HBM = High-Bandwith-Memory. Link > https://www.computeexpresslink.org/).

Anmerkung: Auch Micron bietet bereits seit dem letzten Jahr keine 3D-X-Point-Technologie mehr an und investiert dafür in CXL (Quelle: https://investors.micron.com/news-releases/news-release-details/micron-updates-data-center-portfolio-strategy-address-growing).

Aktuelle Alternativen zu Intel Optane (kein Anspruch auf Vollständigkeit!):

1. Z-SSD von Samsung

- Die neue Speicherschicht Z-SSD verspricht höchsten Durchsatz bei geringster Latenz und ist laut Samsung insbesondere für Cloud-DBMS, Mem-Cache, In-Memory-Anwendungen und Echtzeitanalyse geeignet. Mit einem Anschluss und 4 Lanes verfügen Z-NAND-Chips nach Anbieterangaben** über eine bis zu 10-mal schnellere Zellen-Lesegeschwindigkeit als herkömmliche TLC-NAND-Chips. Über die PCIe-Schnittstelle verfügbare maximale Datenbandbreite, 1,5 GB LPDDR4-DRAM und einem Hochleistungscontroller soll Z-SSD beim zufälligen Lesen mit 750K IOPS 1,7 Mal schneller sein als ein Samsung PM963 NVMe™ SSD-Drive. **Quelle / Link > https://semiconductor.samsung.com/emea/ssd/z-ssd/

2. KIOXIA-SCM-Lösung XL-FLASH

- Ausgestattet mit XL-FLASH können die PCIe-4.0- und NVMe-1.4-kompatiblen SSDs der FL6-Serie die Leistungslücke zwischen DRAM und (TLC) NAND-Flash-Drives schließen helfen. Die Laufwerke eignen sie sich laut Hersteller*** besonders für latenzempfindliche Anwendungen wie dem Lese-/Schreib-Caching Layer, Storage-Tiering oder Write Logging. Die Dual-Port-FL6-Laufwerke liefern eine Belastbarkeit von 60 DWPD und sind aktuell mit Kapazitäten bis zu 3.200 GB erhältlich. Laut Anbieter sollen Leistungswerte von bis zu 1,5 Mio. zufälligen Lese-IOPS, 400 K zufälligen Schreib-IOPS mit Lese-Latenz von 29 μs und einer Schreib-Latenzzeit von 8 μs, möglich sein (Vergleich: Intel Optane(TM): 7μs -10μs reads, writes). ***Quelle / Link > https://business.kioxia.com/de-de/ssd/enterprise-ssd.html

Anbieter von kompletten Speicher-Subsystemen (hardware / software) wie z.B. VAST Data mit seiner Universal Storage Plattform, die von Anfang an auf Optane-Produkte gesetzt hatten, wurden nun gezwungen, Alternativen zu validieren und zu zertifizieren, wie z.B. das FL6 NAND Produkt von Kioxia. Kommentar Jeff Denworth, Co-Gründer von VAST Data zur Produktionseinstellung von Intel's SCM-Produkt Optane(TM): „Seit Intel SCM eingeführt hat, gab es viele Alternativen von Anbietern wie Samsung und Kioxia. Daher haben wir vor über einem Jahr beschlossen, für Universal Storage eine Multi-Source-Lieferkette zu implementieren. Diese anderen SCM-Quellen greifen auf ihre konventionellen Flash-Lieferketten und Fertigungsprozesse zurück und profitieren daher von den Skaleneffekten, die Flash-Hersteller bei der Herstellung dieser neuen Version von flashbasiertem SCM erzielen. Wir verfolgen bei allem, was wir tun, eine Dual-Vendor-Supply-Chain-Strategie…“

Mein Fazit: Leistungs-sensitive Anwendungen mit zum Teil massiven Datensätzen und unterschiedlichen Workload-Profilen verlangen nach skalierbarer hoher I/O-Leistung bei geringer Latenz zu vertretbaren Kosten. Hochparallele I/O-Architekturen und NVMeoF im Verbund mit QLC-NAND (künftig auch PLC = Penta-level-Cell), Storage Class Memory (SCM) sowie skalierbarer Filesystem Software sind leistungsgerechte und wirtschaftliche Alternativen (OPEX) bei steigenden Apps-Anforderungen. CXL als sich rasch entwickelnder Standard seit 2019 (v.3.0 bereits in Arbeit) sollte deshalb weiter beobachtet werden.

Querverweis:

Unser Blogpost > Der gemeinsame Nenner zwischen Storage, KI und modernen IoT-Anwendungen

Unser Blogpost > Storage für KI: Welche Speichertechnologien sind dafür geeignet?