Starnberg, 14. Jan. 2019 - Ausufernde Speicherkosten mit Hilfe von mehrstufigen hybriden Lösungen, Cloud Computing und dem richtigen Datenmanagement begrenzen...

Um was es hier geht: Cloud Computing scheint auf dem Weg zum künftig bevorzugten Architekturmodell für Unternehmen & Organisationen zu sein und die Fachbereiche sind wesentliche Treiber im Zuge der Digitalen Transformation; dies betrifft auch die Zusammensetzung von IT-Budgets. Direkt verbunden ist das gestiegene Interesse an Cloud Storage Services (CSS), natürlich auch getrieben durch stetig steigende Datenmengen (> 50% p.a.), die regelkonform und kosteneffizient gespeichert und verwaltet werden müssen. Und dies wiederum verlangt nach effektiven hybriden Data Management Strategien in Kombination mit modernen Speichertechnologien (Software Defined; Flash; Cloud Storage).

Auf immer mehr Daten wird aber gleichzeitig immer weniger zugegriffen (cold data); kostenseitig stellt dies nicht nur für Unternehmen, sondern auch für Cloud-Anbieter auf Grund des raschen Datenwachstums zunehmend eine Herausforderung dar. Es kann damit notwendig sein, die Konsolidierung von Festplatten und Bändern zu einer mehrstufigen, unter Einbeziehung von Cloud-Speicherlösungen, logisch einheitlich zu verwaltenden Architektur aufzubauen. Gerade im Zusammenhang mit Archiven wird dieser Ansatz anwendersseitig unterschätzt. Ein Beispiel: Standard Office-Anwendungen erzeugen bislang die Masse aller Geschäftsdaten in der klassischen IT und diese altern schnell, was zu immer mehr Daten mit nur geringer Aktivität (Zugriffshäufigkeit) führt. Eine Speicherung dieser "kalten Daten" auf Band stellt eine geeignete Option dar, um mit HDDs und Flash in der Cloud kostenoptimierte, regelkonforme, mehrstufige und hybride Speicherverwaltungs-Lösung aufzubauen (automatisiertes Data Life-Cycle Management). Damit kann „die Wolke“ als eine weitere, nahtlos integrierte Speicherebene (Tier) im Unternehmen etabliert werden, ohne die Kontrolle über seine Daten zu verlieren.

Speicher- und Datenverwaltungs-Technologien im Fokus

Hochkapazitative Festplatten (SATA mit CMR-/SMR; künftig Seagate HAMR ?) sind die primären Speichermedien für Rechenzentren und Storage-Provider, aber wie steht es um Bandmedien zur kostenoptimierten Cloud-Archivlösung für die Langzeitspeicherung? Fakt ist, dass die Zuverlässigkeit und lange Lebensdauer moderner Bänder wie LTO-7 und LTO-8 in Verbindung mit Verschlüsselung (256-bit AES) Kundendaten „stromlos“ und sicher on-premise und in der Cloud über lange Zeiträume aufbewahren läßt. Das dies nötig ist, zeigt übrigens ein aktueller Trend: wir produzieren z.B. täglich rund 2,5 Trillionen (10 hoch 18) Bytes und sammeln, sprich speichern etwa ein Prozent davon (Quelle: IBM).

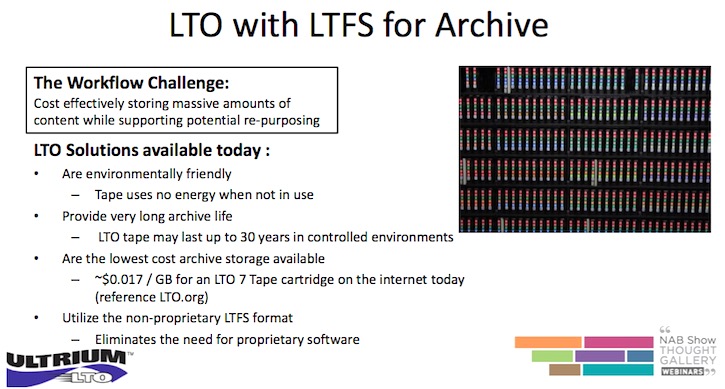

Tape hat sich mit LTO und LTFS (Linear Tape File System) zudem von seiner alten Rolle als primäre Backup-Lösung weit entfernt; insbesondere Datenarchivierungs- und Disaster Recovery (DR) Services profitieren davon. Diverse Entwicklungen führten zu zahlreichen Verbesserungen, darunter Kapazitätssteigerungen durch den Einsatz von BaFe-Medien (LTO-8 bis zu 30 TB/Kassette komprimiert), bessere Bitfehlerraten (BER) 1x10 hoch 19 im Vergleich zur Festplatte, die verlängerte Lebensdauer der Medien (rund 30 Jahre) und schnelle Datenübertragungsraten (max. 750 MB/s). Damit können moderne Tape-basierte Lösungen eine größere Vielfalt an Anwendungen abdecken als früher (Archive, Compliance-Themen, Streaming-Media, Content-Repositories etc.) und das zu durchaus wettbewerbsfähigen Kosten. LTO-9 mit 24 TB pro Bandkassette in ca. zwei Jahren und LTO-10 mit 48 TB in ca. vier Jahren werden Herstellerseitig als die nächsten Entwicklungsziele genannt. IBM hingegen forscht bereits an einem eigenen Enterprise-Tape, das in Zukunft über 300 TB pro Kassette speichern soll. IBM liefert mit seinem TS1160-Bandlaufwerk derzeit native 20 TB mittels proprietärer TS-Formate und kann damit im Bereich seiner Libraries Kapazitäten bis zu 350 PB erreichen. Quantum, Oracle und Spectra Logic bieten Tape-Automatisierungslösungen bis 360 PB bzw. sogar bis zu 2.000 PB.

In weiterer Zukunft (ca. 10-15 Jahre) dürften in Verbindung mit Quantencomputern dann allerdings ganz neue Technologien zu erwarten sein, wie etwa DNA-Storage oder Atomic-Scale Memory (siehe hierzu auch mein Blogpost > DNA Storage vor dem Durchbruch? Alle Daten dieser Welt in einem Kleiderschrank vom 11. Jan. 2019). Aber noch ist es nicht soweit und bleiben wir im Jetzt...

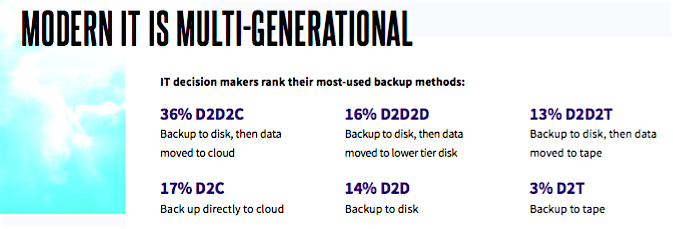

Es sollen an dieser Stelle deshalb auch nicht die Herausforderungen von Tape verschwiegen werden. Disk-to-Disk-to Cloud (D2D2C) löst gerade die bisherige Hierarchie mit D2D2T ab und viele Unternehmen ziehen es zudem vor, solche Anwendungen an spezialisierte Anbieter (Backup/DR-as-a-service) auszulagern. Daran hat auch die Ankündigung neuer LTO-Drives & Medien nichts geändert. Mit Einführung von LTO-8 (12 TB native) unterstützen nur mehr zwei Medienhersteller (Sony, FujiFilm) das LTO-Format.

Tape ist damit zum Archiv-Medium mutiert und steht in starkem Mitbewerb zu Cloud-Archivierungslösungen von Microsoft Azure, AWS oder Google, die allerdings intern selbst wieder Tape verwenden. Weiterhin setzen sich Objektspeicherlösungen mit S3-Schnittstellen / File Gateways zu Cloud Storage Pools immer mehr durch, die als verteilte (n-node) Architektur auf preiswerten SATA HDDs mit Industrie-Standard-Server aufsetzen und statt RAID mit Erasure-Coding arbeiten.

Abb. 1: Auszug aus der Arcserve-Studie - DATA PROTECTION IN THE FOURTH INDUSTRIAL REVOLUTION (Bildquelle: Arcserve, Sept. 2018)

Auch Cloud-Anbieter weisen im Archivbereich nicht immer nur Vorteile auf

Anbieter wie Microsoft (aber auch intern Facebook) nutzen die Vorteile bei der Implementierung von Tape für Massendaten innerhalb ihrer Cloud-Infrastruktur, denn die Speicherung inaktiver Daten (Langzeitspeicherung) ausschließlich auf HDDs im Exabyte-Bereich wird über die Zeit teuer (TCO). Zudem hat sich Tape generell für Unternehmen als „last-line-of-defense“ z.B. gegenüber Ransomware-Attacken und anderen Angriffen bewährt.

Um die Budget- und Geschäftsanforderungen zu erfüllen, setzen IT-Organisationen also wie beschrieben verstärkt auf Cloud-basierte Speicherlösungen. Spezialisierte Provider bieten dazu eine fixe Gebühr für die Speicherung auf Basis Gigabyte (GB) pro Monat mit kostenlosem Upload der Daten über das Portal des jeweiligen (Cloud-)Anbieters. Für den Nutzer sind das Ausgaben, die als Betriebsaufwendungen (OPEX) im Budget erscheinen. Das Verschieben von Langzeitspeicherdaten reduziert damit die Auswirkungen auf das IT-Budget (CAPEX) und macht über das nutzungsabhängige Modell die Abrechnung zudem transparent und einfach. Werden sehr selten Daten aus dem Archiv benötigt, kann dieser Ansatz strategisch und kostenseitig sehr effektiv sein.

Preiswert nur auf den ersten Blick ?

Das Geschäftsmodell von diversen Anbietern wie Amazon Glacier, Google Cloud Storage Nearline, Microsoft oder auch Oracle Archive Storage basiert allerdings auch darauf, dass der Benutzer nicht exakt vorhersagen kann, welche seiner Daten er wann genau benötigt. Cloud-Anbieter verrechnen immer die Kosten für die Rücklieferung der Daten. Der Abruf und Export von Daten basiert auf pro GB-Basis, wobei meist das erste GB frei abrufbar ist. Der Nutzer bezahlt eine Gebühr, um jedes nachfolgende GB unter Verwendung eines gestaffelten Preismodells abzurufen. Entscheidend ist, dass diese gestaffelte Preisgestaltung über den angegebenen Zeitraum beibehalten wird. In vielen Fällen übersteigen jedoch die Datenabruf- und Exportgebühren die reinen Speicherkosten.

Langzeitdaten werden immer häufiger als Quelle für Analysen oder sogar als primärer kostengünstiger Speicher für selten abgerufene Daten angesehen. Für jedes Unternehmen summieren sich dann diese Kosten über den gesamten Lebenszyklus der bei Cloud-Storage-Anbietern gespeicherten Daten. Die Kosten können in kürzester Zeit steigen, indem die abzurufende Datenmenge um nur wenige Prozente verändert wird. Bis die Daten für die Nutzung durch den Endbenutzer vor Ort zurückgeholt werden, sind die Kosten dann oft höher als bei der Verwendung von Primärspeicher-Systemen und on-premise Lösungen (Cloud-Anbieter erheben zusätzliche Gebühren für Befehle, die gesendet werden, um Daten aus dem Langzeitarchiv abzurufen).

Zu beachten ist weiter die Zugriffszeit und -leistung des Netzwerkes: Während sich die Speichermenge jedes Jahr rund verdoppelt, wächst die Netzwerkgeschwindigkeit bislang um Faktoren langsamer. Der Speicherbedarf übertrifft somit die Netzwerkkapazitäten und in der Konsequenz dauert es oft lange, bis sehr große Datenmengen in ein Cloud-Netzwerk migriert oder bei Bedarf wieder ausgelagert werden. Die durchschnittliche Netzwerkleistung ist für die Nutzung der Cloud im Rahmen leistungskritischer Anwendungen somit kritisch und dies trifft auch für die Netzkosten zu.

Tape kann Speicherkosten berechenbarer machen

Unter Berücksichtigung der Kosten für Verwaltung, Strom, Energieverbrauch, Media und Investitionskosten für Hard- und Software bietet die LTO-Bandtechnologie eine niedrigere TCO für selten genutzte Daten. Tape stellt zudem sicher, dass die Daten im Unternehmen über Jahre hinweg ohne Abrufkosten oder Abrufbefehlskosten validiert und gespeichert werden. Auch sind Zuverlässigkeit oder Verfügbarkeit der Langzeit-Archivdaten - unabhängig vom jeweiligen Cloud Service Provider - sichergestellt.

Hinweis: Jedes Unternehmen hat ein anderes Anwendungsfall-Szenario. Um konkret ein auf Ihre Bedürfnisse abgestimmtes Rechenbeispiel über die tatsächlichen Kosten der Datenverwaltung zu erhalten, bietet die ULTIUM LTO Org. (HPE, IBM, Quantum) als Hilfestellung seit 2017 kostenlos ein hierfür entwickeltes LTO TCO Tool, basierend auf branchenspezifischen Informationen an.

Abb. 2: LTO with LTFS for Archiv (Bildquelle: Brad C. Johns Consulting L.L.C. / Ultrium LTO, NAB Show Webinars, 2017, page 7).

Ein Fazit: Statt Techniksilos sind künftige IT-Architekturen ein abstraktes Netz aus cloud-basierten Lösungen und arbeiten as-a-service auf Grundlage einer hybriden Multi-Cloud. Zentral wird damit ein einheitliches, hochautomatisiertes und Plattform-übergreifendes Datenmanagement über lokale- und Cloud-Umgebungen hinweg, das sowohl robust (resilient) als auch hochverfügbar (always-on) bereitsteht. Speichertechnologien spielen dabei wie gesehen eine wichtige Rolle; sie sind aus Datensicht die Basis zur Bereitstellung kosteneffizienter (TCO) skalierbarer und agiler IT-Services, wie sie im Zeitalter der Digitalisierung immer mehr benötigt werden.

Appendix / Querverweis > Links zu Anbieterlösungen (kurze Auswahl ohne Anspruch auf Vollständigkeit):

IBM Q4 Storage Ankündigungen zu End-to-end NVMe, Spectrum Discover und mehr

Multi-Cloud-Lösungsangebote von Dell EMC um neue Referenzarchitekturen erweitert

NetApp und Google bieten Managed Service Cloud Volumes für Google Cloud Platform

Scale-out Enterprise NAS mit Quantum Xcellis shared parallel Filesystem

HPE Discover 2018 Madrid: Cloud-enabled Infrastrukturen und neue Speicherlösungen

Vereinfachtes Speichermanagement mit Scality RING 7.4 Object Storage

LucidLink distributed file service to connect file systems to object-based cloud storage

SUSE Enterprise Storage 5.5 unterstützt Objekt-, Block- und File-Storage

RAID Performance beim Einsatz mit Flash SSDs versus Erasure Coding und RAIN.