Barcelona, Starnberg, 08. Dez. 2023 - Erweiterte Zusammenarbeit mit NVIDIA; Neuerungen unterstützen Modellentwicklung, Datenanalysen, File Storage, KI-Tuning und -Inferenz…

Zur Ankündigungsübersicht: Hewlett Packard Enterprise hat auf seiner Hausmesse HPE Discover Barcelona 2023 Ende November eine Reihe von KI-nativen- sowie Hybrid-Cloud-Angeboten angekündigt. Sie unterstützen laut HPE Modellentwicklung, Datenanalysen, File Storage, KI-Tuning und -Inferenz. Die Grundlage dafür ist eine offene, KI-native – also speziell für KI-Anforderungen entwickelte – Architektur, die darauf ausgelegt ist, den KI-Lebenszyklus zu beschleunigen. Unternehmen müssen ihre Cloud-native Umgebung um einen KI-nativen Ansatz erweitern, wenn sie generative KI, Deep Learning, Computer Vision oder klassisches maschinelles Lernen effektiv nutzen wollen.

Die Plattform HPE GreenLake bietet folgende Attribute (Quelle / Anbieter):

- „Data-first-Pipeline zur Verwaltung öffentlicher und unternehmenseigener Daten über mehrere IT-Generationen hinweg

- Hybrides Design für den KI-Einsatz an jedem Ort, vom Edge bis zur Cloud

- In das gesamte Portfolio integrierte Supercomputer-Funktionen zum Trainieren selbst größter Modelle

- Software für das Management des KI-Lebenszyklus‘, um Workflows für Training, Tuning und Inferenz zu beschleunigen

- Hochleistungs-Netze für Traffic-Management in großen Clustern

- Offenes Ökosystem für Wahlfreiheit ohne Herstellerbindung."

Neue und erweiterte Angebote innerhalb der KI-nativen Architektur von HPE:

Zusammen mit NVIDIA hat HPE ein vorkonfiguriertes Komplettsystem für KI-Tuning- und -Inferenz entwickelt, das für Organisationen jeder Größe geeignet sein soll. Kunden können damit vortrainierte Basismodelle mit privaten Daten anpassen und in den Betrieb bringen. Dabei helfen sog. RAG-Workstreams (Retrieval-Augmented Generation) die Datenqualität und Genauigkeit der Anwendung. zu verbessern. Das neue System umfasst folgende Komponenten:

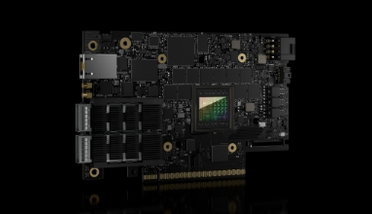

Eine Rack-Scale-Architektur mit dem HPE ProLiant Server DL380a, bestückt mit NVIDIA L40S GPUs, NVIDIA BlueField-3 DPUs und der NVIDIA Spectrum-X Ethernet Networking Platform. Das System wurde für das Feintuning eines Llama-2-Modells mit 70 Milliarden Parametern dimensioniert und umfasst 16 Server des Typs HPE ProLiant DL380a und 64 L40S GPUs.

Das HPE Machine Learning Development Environment stellt neue Funktionen zum schnellen Prototyping und Testen von Modellen bereit. HPE Ezmeral Software vereinfacht mit neuen GPU-fähigen Funktionen die Bereitstellung und beschleunigt die Datenvorbereitung für KI-Anwendungen in der Hybrid Cloud.

Die Software NVIDIA AI Enterprise beschleunigt die Entwicklung und Bereitstellung von KI-Produktionsumgebungen und sorgt dabei für Sicherheit, Stabilität und Verwaltbarkeit. Sie umfasst Nvidias NeMo-Framework, Guardrailing-Toolkits, Werkzeuge für die Datenkuratierung und vortrainierte Modelle zur Optimierung von generativer KI im Unternehmen.

Das neue System ist auch als HPE GreenLake Flex Solution erhältlich: diese umfasst zusätzlich HPE GreenLake for File Storage mit der Software Zerto Cyber Resilience Vault zum Schutz von KI-Modellen und Datenquellen sowie OpsRamp-Software, die für Transparenz und Automatisierung über den gesamten KI-Lebenszyklus in heterogenen Multi-Cloud-Umgebungen sorgen soll.

Neuerungen bei KI-nativer Infrastruktur, Software und Dienstleistungen:

- HPE GreenLake for File Storage erhöht Leistungsdichte und Durchsatz für anspruchsvolle KI-Anwendungen. HPE GreenLake for File Storage ist eine All-Flash-Plattform für unstrukturierte Daten, die vor Ort betrieben, aber aus der Cloud verwaltet wird. Das System unterstützt jetzt NVMe SSDs mit 30 Terabyte und das InfiniBand-Netz NVIDIA Quantum-2. Ziel der Neuerung: KI-Training und -Tuning, die Datenaggregation und -vorbereitung beschleunigen.

- Das HPE Machine Learning Development Environment ist nun als Managed Service auf AWS und anderen Public Clouds verfügbar.

Abbildung: NVIDIA BlueField-3 DPU (Bildquelle: NVIDIA)

HPE Services mit neuen KI-Dienstleistungen:

- Die Dienstleistungen werden von neuen Global Centers of Excellence for AI and Data in Spanien, den USA, Bulgarien, Indien und Tunesien unterstützt.

Taiga Cloud arbeitet mit HPE zusammen, um seine GenAI-Cloud zu betreiben

- Taiga Cloud, ein Unternehmen der Northern Data Group und nach vorliegenden Angaben "Europas erster und größter Cloud Service Provider für generative KI" kooperiert mit HPE um Cloud-Services mit HPE Cray XD Supercomputern zu betreiben. Taiga Cloud bietet Zugang zu über 27.000 NVIDIA H100, A100 und NVIDIA RTX A6000 GPUs, vernetzt mit NVIDIA BlueField DPUs und der NVIDIA Quantum-2 InfiniBand-Plattform.

Verfügbarkeit (Quelle / Anbieter): Das vorkonfigurierte Komplettsystem für generative KI mit Nvidia wird im ersten Quartal des Jahres 2024 bestellbar sein.

Die neuen KI-Dienstleistungen, das HPE Machine Learning Development Environment als Managed Service und die Updates für HPE Ezmeral sind ab sofort verfügbar. HPE GreenLake for File Storage mit 30TB NVMe SSDs und NVIDIA Quantum-2 soll im ersten Halbjahr 2024 verfügbar werden.

Querverweis:

Unser Beitrag > HPE-Cray-EX2500-Supercomputer mit NVIDIA-Superchips: Komplettlösung für generative KI

Unser Beitrag > Deutscher KI-Entwickler Aleph Alpha sichert sich Gesamtfinanzierung von 500 Mio. US-Dollar

Unser Blogpost > Speicheranforderungen bei KI-Anwendungen: Randbedingungen und Einsatzkriterien