Böblingen/Houston, Starnberg, 14. Nov. 2023 - Neues Angebot für Großunternehmen und Forschungseinrichtungen; KI/ML-Software, Hardware, Netzwerke und Dienstleistungen…

Zur Ankündigung: Hewlett Packard Enterprise hat eine Supercomputer-Lösung für generative KI angekündigt, die das Training und Tuning von KI-Modellen mit privaten Datensätzen beschleunigt. Zielgruppen sind Großunternehmen, Forschungseinrichtungen und größere Behörden. Zum Paket gehört eine Software-Suite für Training, Tuning und Entwicklung, flüssigkeitsgekühlte Supercomputer, KI-Beschleuniger, Netzwerke, Speicher und Dienstleistungen. Die HPE Supercomputing-Lösung für generative KI soll laut Anbieter im Dezember 2023 in mehr als 30 Ländern verfügbar sein.

Die Software-Suite ist mit der Supercomputer-Technologie von HPE Cray integriert, die laut Anbieter auf der gleichen Architektur wie der schnellste Supercomputer der Welt basiert und von NVIDIA Grace Hopper GH200 Superchips angetrieben wird. Damit soll die neue Komplettlösung die Skalierbarkeit und Leistung liefern können, die für große KI-Workloads wie das Training von großen Sprachmodellen (LLM) und Deep-Learning-Empfehlungsmodellen (DLRM) erforderlich sind.

Mit dem HPE Machine Learning Development Environment auf diesem System wurde das Open-Source-Modell Llama 2 laut HPE mit 70 Milliarden Parametern in weniger als 3 Minuten feinabgestimmt. (1) Die Lösung sorgte so für eine 2-3-fache Leistungsverbesserung.

Die neue Supercomputer-Lösung für generative KI von HPE umfasst:

KI/ML-Beschleunigungssoftware: Eine Suite von drei Software-Werkzeugen, mit denen Kunden KI-Modelle trainieren, tunen und eigene KI-Anwendungen erstellen können: HPE Machine Learning Development Environment ist eine Softwareplattform für maschinelles Lernen (ML), die die Entwicklung und Einführung von KI-Modellen beschleunigt. Sie umfasst gängige ML-Frameworks und vereinfacht die Datenaufbereitung.

NVIDIA AI Enterprise bietet umfangreiche Frameworks, vortrainierte Modelle und Werkzeuge, die die Entwicklung und Bereitstellung von Produktions-KI vereinfachen können.

Das HPE Cray Programming Environment bietet Programmierern einen kompletten Werkzeug-Satz für die Entwicklung, Portierung, Fehlersuche und Verfeinerung von Code.

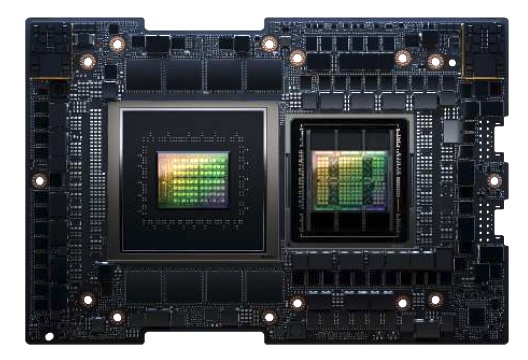

Abb.: NVIDIA GH200 Grace Hopper Superchip (Bildquelle: HPE/NVIDIA)

Anmerkung: Auf der aktuell stattfindenden Supercomputing-Messe SC23 in Denver / Colorado kündigte NVIDIA an, dass der Superchip weltweit in weiteren Systemen zum Einsatz kommt, u.a. in Systemen von Dell Technologies, Eviden, Lenovo, QCT und Supermicro.

Die neue HPE-Lösung Lösung basiert auf der HPE Cray EX2500, System der Exascale-Klasse, und NVIDIA GH200 Grace Hopper Superchips. Sie kann laut Entwickler auf Tausende von Grafikprozessoren skaliert werden, um große KI-Workloads zu unterstützen. Es handelt sich um das erste System mit der Vierfach-GPU-Konfiguration des GH200 Superchips.

HPE Slingshot Interconnect bietet ein offenes, Ethernet-basiertes Hochleistungsnetzwerk zur Unterstützung von Workloads der Exascale-Klasse.

Zum Komplettpaket gehören danach auch HPE Complete Care Services für Einrichtung, Installation und laufende Wartung.

Energieeffizient mit Flüssigkeitskühlung

Schätzungen zufolge wird das Wachstum von KI-Workloads bis 2028 etwa 20 Gigawatt Strom in Rechenzentren (2) erfordern. Um die Auswirkungen ihres CO2-Fußabdrucks zu minimieren, werden Kunden energieeffizientere Lösungen benötigen. Die in der neuen Komplettlösung eingesetzten Supercomputer sind flüssigkeitsgekühlt und bieten damit bis zu 20 Prozent mehr Leistung pro Kilowatt als luftgekühlte Systeme und verbrauchen 15 Prozent weniger Strom. (3) Sechs der zehn energieeffizientesten Supercomputer auf der Green500-Liste wurden nach vorliegenden Angaben von HPE gebaut.

Quelleangaben (HPE):

(1) Unter Verwendung von 32 HPE Cray EX 2500-Knoten mit 128 NVIDIA H100-Grafikprozessoren bei einer Skalierungseffizienz von 97 % wurde ein Llama-2-Modell mit 70 Milliarden Parametern in internen Tests auf einem Korpus von 10 Millionen Token in weniger als 3 Minuten feinabgestimmt. Modellabstimmungscode und Trainingsparameter wurden zwischen den Skalierungsläufen nicht optimiert.

Standard-KI-Benchmarks, BERT und Mask R-CNN, unter Verwendung eines nicht optimierten Systems, bestehend aus einem HPE Cray EX2500 Supercomputer mit einem HPE Cray EX254n Accelerator Blade mit vier NVIDIA GH200 Grace Hopper Superchips. Die unabhängig durchgeführten Tests zeigten eine 2-3-fache Leistungsverbesserung im Vergleich zu den von MLPerf 3.0 veröffentlichten Ergebnissen für ein A100-basiertes System mit zwei AMD EPYC 7763 Prozessoren und vier NVIDIA A100 GPUs mit NVLINK-Verbindungen.

(2) Avelar, Victor; Donovan, Patrick; Lin, Paul; Torell, Wendy; and Torres Arango, Maria A., The AI disruption: Challenges and guidance for data center design (White paper 110), Schneider Electric.

(3) Basierend auf internen Leistungstests von HPE im April 2023 wurde festgestellt, dass flüssigkeitsgekühlte Lösungen eine Leistungssteigerung von bis zu 20 Prozent pro Kilowatt gegenüber luftgekühlten Lösungen ermöglichen und 15 Prozent weniger Strom verbrauchen.

Querverweis:

Unser Beitrag > Anforderungen von GenAI an die Unternehmens-IT und der Faktor komplexes Datenmanagement

Unser Beitrag > Übersicht zur HPE Discover 2023: GreenLake Erweiterungen zu KI für MMLs und Cloud Services

Unser Beitrag > Micron 9400 NVMe SSD: Neue Hochleistungs-Drives für mixed Workloads in Rechenzentren