Dynamische Applikationsentwicklung, Digitalisierung, AgenticAI, RAG oder MCP. Die Initiativen werden ihr Potenzial nur dann entfalten können, wenn die Unternehmens-IT dafür hinreichend vorbereitet und ausgestattet ist...

Zum Hintergrund des Blogposts

Ein wesentlicher Katalysator für weiter steigende Datenmengen sind moderne Anwendungen, vor allem im Zusammenhang mit KI. Dem gegenüber steht eine Infrastruktur-Komplexität mit steigende Kosten, die es gilt, über Plattform-Konsolidierung, Automatisierung, Unified Data Ops, Speicheroptimierungen und weitere Maßnahmen möglichst umfassend zu adressieren.

1. Die Vogelperspektive

Der KI-Wertbeitrag für die Digitalisierung hängt wesentlich von der Entwicklung einer datenzentrierten Anwendungs-Modernisierung ab. Dazu gehören Verbesserungen beim Echtzeit-Datenzugriff soeie ein hierfür optimiertes Daten- und Speichermanagement.

Komplexe Datenbestände über unterschiedliche Tools und Plattformen hinweg zu vereinheitlichen, ist eine der Herausforderungen, um zunehmend heterogene Datenplattformen mittels Orchestrierung im Unternehmen wirtschaftlich zu betreiben. Dabei ist die Gewährleistung von hohen Datenqualitäts- und Sicherheitsstandards zentral.

Grundsätzlich sind Unternehmensdaten immer nur dann wertvoll, wenn sie in einem sinnvollen betrieblichen Zusammenhang gestellt werden können. Neue Technologien werden ihr Potenzial somit erst dann entwickeln, wenn man in der Lage ist, die Unternehmensbereiche mit den KI-Möglichkeiten wertschöpfend zu verknüpfen (s.a. AgenticAI, MCP). Eine moderne Daten- und Speicherverwaltung ist deshalb für den IT-Wertbeitrag entscheidend (s.a. Stakeholder Value).

Aus übergeordneter Sicht sind Themen zu berücksichtigen, die nur bedingt mit Technologie zu tun haben: wie zum Beispiel gelingt der Spagat zwischen innovativen KI-Anwendungen und wachsenden Anforderungen an Transparenz, Governance, Rechtssicherheit, Ethik oder lokalen- sowie EU-Compliancevorgaben?

2. Datenmanagement und KI

Inzwischen sind fast alle zentralen Infrastrukturbereiche (Hardware, Software, Prozesse) von KI betroffen. Beispiel: Backup-Restore, Datenbanken, aktive Archive, Netzwerke, Speicherverwaltung, Datenmanagement usw.

Data Lakes und Multi-Petabyte-Archive stellen für KI-Projekte zentrale Datenquellen bereit. Diese bestehen primär aus semi- und unstrukturierten Daten, die mit Hilfe von DL, ML und Big Data Analytics weiterverarbeitet werden. Über leistungsfähige Datenspeicher (parallel I/O, RAG-optimiert etc.) lassen sich komplexe Trainingsmodelle (LLMs) aufbauen. Anwendungen mit Kapazitäten im Petabyte-Bereich mit unterschiedlichen Formaten bzw. I/O-Workloadprofilen stellen dabei besondere Anforderungen an die Software- und Datenverwaltungsebene.

3. Technologieaspekte im Detail

Potentielle Infrastruktur-Engpässe liegen auf der Server-, Netzwerk und Speicherebene. Die erfolgreiche Umsetzung von KI-Initiativen kann damit nur über eine erfolgreiche Erweiterung sowie Modernisierung dieser IT-Infrastrukturelemente und des Storage (Hardware / Software / Cloudservices) erreicht werden. Daneben spielt aber auch die Energieeffizienz eine wichtigere Rolle.

Die Weiterentwicklung von Rechenzentrum-Infrastrukturen im Zusammenhang mit KI ist zudem unter dem Aspekt der Energieeffizienz relevant (PUE, CO2, Energiekosten), da mit High-Density-Architekturen (GPUs, NVMe, Storage etc.) der Energieverbrauch weiter ansteigt.

IDC z.B. geht davon aus, dass sich der weltweite Stromverbrauch von Rechenzentren zwischen 2023 und 2028 mit einer durchschnittlichen jährlichen Wachstumsrate (CAGR) von 19,5 % mehr als verdoppelt; im Jahr 2028 sollen dann bereits 857 Terawattstunden (TWh) erreichen werden.

KI-Workloads sind so für einen wachsenden Anteil des gesamten Stromverbrauchs in RZ’s verantwortlich (Quelle: IDC, AI Datacenter Capacity, Energy Consumption, and Carbon Emission Projections, May 2024).

Weitergehende Anforderungen durch KI an Server, Netze und Storage:

Anwendungen mit massiven Datensätzen benötigen konstant hohe I/O-Leistungswerte (IOPS, GB/s) und je nach Profil geringe Latenzen. Hochparallele I/O-Architekturen für Server und Storage im Verbund mit HDDs, NAND Flash sowie Storage Class Memory sind dafür die Basis. Gesteuert wird die Hardware über Software-definierte Systeme auf Server- bzw. Appliance-Ebene.

Beispiel: moderne Hochleistungs-Filesysteme integrieren NVMe-basierten Flash-Speicher und HDDs auf der I/O-Ebene mit GPU-/CPUs von Servern, Objektspeicher und Interconnects mit geringer Latenz innerhalb von Fabric-Architekturen mit NVMeoF oder Infiniband.

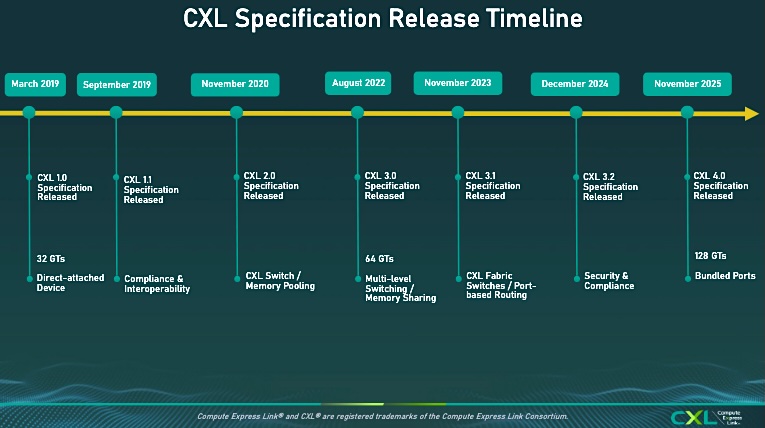

Auf der Host-Schnittstellenseite kristallisiert sich CXL - Compute Express Link - als OPEX-Variante heraus. Er wurde als Standard in 2019 veröffentlicht und ersetzt Gen-Z. Als offener Industriestandard wurde CXL für Verbindungen mit hoher Bandbreite und niedriger Latenz zwischen Host-Prozessor und Geräten wie Beschleunigern, Memory Buffers und intelligenten E/A-Devices konzipiert.

Anmerkung: Ab CXL 3.0 (aktuell: v.3.2 / Juli 2025) wurden Fabric-Funktionalitäten eingeführt, die über die Tree-basierte Architektur von PCIe und früheren CXL-Generationen hinausgehen.

Neue CXL 4.0 Spezifikation (Bildquelle: CXL Consortium, 2026).

Externer Link > https://www.computeexpresslink.org/

Wichtige Merkmale von CXL 4.0 (Quelle: CXL Consortium)

"Verdoppelt die Bandbreite auf 128 GTs ohne zusätzliche Latenz. Ermöglicht einen schnellen Datentransfer zwischen CXL-Geräten und verbessert so direkt die Systemleistung. Behält die zuvor aktivierten CXL 3.x-Protokollverbesserungen mit dem 256B-Format bei.

Flit-Format Einführung des Konzepts der nativen x2-Breite zur Unterstützung eines erhöhten Fan-outs in der Plattform

Unterstützung von bis zu vier Re-timern für eine erhöhte Kanalreichweite. Implementierung von CXL-gebündelten Port-Funktionen

Möglichkeit, Geräteports zwischen Host- und CXL-Beschleunigern (Geräte vom Typ 1/2) zu kombinieren, um die Bandbreite der Verbindung zu erhöhen

Verbesserungen der Speicher-RAS. Erhöht die Zuverlässigkeit, Fehlererkennbarkeit und Wartungseffizienz.

Fortgesetzte vollständige Abwärtskompatibilität mit CXL 3.x, 2.0, 1.1 und 1.0".

Latenzen und Durchsatz der Speichersysteme wirken sich direkt auf die Leistung eines KI-Gesamtsystems aus. Eine Übersicht mit weiteren technischen Details:

Bei Deep Learning ist der Data-Ingest ein Streaming sequentieller Schreibvorgänge. Die weiteren Prozesse bestehen auch aus kleinen „random“ Lese-Operationen. KI wird Speicherseitig deshalb bereits zur Mustererkennung beim Datenzugriff selbst eingesetzt. Die Daten werden dazu pro-aktiv in den Cache verlagert, noch bevor sie vom User benutzt werden (Anmerkung: Deep Neural Networks als massiv parallel vernetzte Modelle sind sehr leistungsfähig, d.h. benötigen eine entsprechende GPU-Performance).

Auch ML-Implementierungen sind stark auf GPU-basierte parallele Berechnungen angewiesen. Sie benötigen meist einen schnellen Speicher mit DRAM, Persistent Memory und NAND Flash, aber die zufällige Leseleistung bei geringer Warteschlangen-Tiefe ist für NAND Flash SSDs aus Performance-Sicht kritisch.

Persistent Memory kann als Alternative je nach Anwendung eine 5-bis 10-fache Leistung gegenüber Standard NAND Flash SSDs bei Random Read Queue Depth (QD) von 1-4 liefern, dies allerdings zu höheren Kosten wie TLC oder QLC.

Serverseitig sollte berücksichtigt werden, dass ältere Hardware-Systeme moderne Befehlssatzarchitekturen mit Multithreading nicht unterstützen, so wie es KI verlangt. VNNI, Vector Neural Network Instructions für die maschinelle Verarbeitung von Bild- und Audiodateien über künstliche neuronalen Netzen (CNNs) sei als Beispiel erwähnt.

FPGAs (Field Programmable Gate Arrays) werden aus Kosten- und Performance-Gesichtspunkten jetzt häufiger eingesetzt. Speziell der Energieverbrauch von komplexen KI-Algorithmen soll damit adressiert werden. Mit schnellen lokalen FPGA-on Chip Speichern lassen sich zudem auch größere Datenmengen in Echtzeit verarbeiten.

NVMeoF und RDMA über 100 GBE (auch mit InfiniBand) sind Hardware- und Protokollseitig für den Storage- und Applikationen wichtig für Low-latency, high Performance I/O. Hohe Random-E/A-Leseleistung bei geringer Warteschlangentiefe (QD) ist ein weiteres Leistungskriterium.

Kombinationen aus QLC-NAND Flash (Kapazität, Preis) und Storage Class Memory (Leistung) stellen eine leistungsfähige Basis zum Aufbau skalierbarer Storage-Plattformen für KI-Infrastrukturen dar. QLC kann seine Vorteile gegenüber SATA-HDDs auf Drive-Ebene auspielen (keine drehende Mechanik), falls deutlich mehr gelesen als geschrieben wird. Anders verhält es sich bei Object Storage und inaktiven Datenarchiven, bei denen neben Tape auch HDDs (auch SMR) eine Rolle spielen.

GPUDirect Storage ermöglicht einen direkten DMA-Datenpfad zwischen GPU-Speicher und lokalem oder entferntem Speicher, wodurch eine Kopie in den Systemspeicher durch die CPU vermieden wird. Der direkte Pfad erhöht die System-Bandbreite und verringert Latenzzeiten und die Auslastung von CPU und GPU (Quelle: NVIDIA, externer Link > https://www.nvidia.com/en-us/data-center/magnum-io/ ).

Weitere Anforderungen die ebenfalls den Storage betreffen, liegen im verstärkten Edge-Datenwachstum. Software Definierte IT-Architekturen anstelle verteilter (Speicher-)Silos, die zunehmend kostenintensiv und schwerer zu verwalten sind, können dabei als Blueprint dienen.

4. Kalte Daten und Tape Storage

Kapazität, Preis und Sicherheit sind wesentliche Gründe, weshalb Bänder im Kontext von KI und Digitalisierung eine Renaissance erfahren haben. (1) Die aktuellste LTO-10 Bandgeneration liefert jetzt bis zu 40 TB nicht-komprimierter Speicherkapazität bei max. 400 MB/s, Air-Gap beim Medium und ein sehr gutes €/TB Verhältnis gegenüber HDD-Konfigurationen und Flash.

Bedingt durch die Tatsache, das Daten auf Tape kosteneffizient vor Cyberangriffen geschützt werden können, bietet sich die Technologie weiter für sichere Backup-Kopien an.

Aufgrund der niedrigen Medienkosten und hoher Data Reliability* ist der Aufbau von aktiven und passiven Archiven im Bereich großer Datenmengen auf Basis von Tape derzeit konkurrenzlos.

Bandspeicher sind nicht für alle Workloads und Daten geeignet, aber für inaktive Daten aufgrund der niedrigen Speicher- und Energiekosten im Petabyte-Bereich und darüber hinaus das Medium der Wahl.

Bildquelle: Ultrium LTO, Technical Whitepaper

*Im Bild: LTO vs HDD UBER Comparison. "Reliability of the LTO-9 error correction codes to support LTO-9 user data reliability being better than 1 uncorrectable error event in 1E-20 user bits transferred". Anmerkung: UBER steht für „uncorrectable bit error rate“. HDD und LTO hier mit jeweils 18TB Kapazität als Basis. Quelle: Ultrium LTO, Technical Whitepaper.

KI-Datenmigration auf Tape

Durch die Verlagerung von wenig genutzten sowie älteren inaktiven LLMs auf Bandspeicher (lokal oder über S3 in der Cloud) lassen sich Energieeinsparungen erzielen und gleichzeitig vorhandene HDD-Kapazitäten für andere Anwendungen freisetzen. Dies kann wiederum helfen, den Energiebedarf aktueller High-End-GPUs zu kompensieren.

S3 und Tape-Archive

Deep-Archives mit modernen automatisierten Tape-Robotic-Systemen vor-Ort im Rechenzentrum (private Cloud / Private Cloud as a Service, PCaaS) ermöglichen es über spezialisierte Softwarelösungen mit S3, kalte Langzeitdaten in (AWS) Glacier-Services zu integrieren.

Reduzierte Infrastrukturkosten, geringerer Platzbedarf im Rechenzentrum sowie weniger Wartungs-, Strom-/Kühlungskosten können als Hybrider Cloud-Ansatz auch innerhalb von Colocation-RZs genutzt werden.

Komplexe Tasks zur Bedienung der Bandlaufwerke entfallen durch die hochgradige Automatisierung über Software und die moderne Library-Architektur, sodaß keine teuren Spezialisten dafür erforderlich sind.

Beispiel: Mit S3 lassen sich Anwendungen direkt auf Band schreiben und lokale Deep-Archive-Speicherumgebungen aufbauen. Der Restore von Daten aus dem Archiv ist lokal dann bereits im Minutenbereich möglich.

Bei Cloud-Speicherinfrastrukturen wie S3 Glacier sind Restore-Zeiten (je nach SLA) zwischen 4 Std. bis max. 48 Std. (im Mittel weniger als 12 Std.) für diese Art von Anwendungen wirtschaftlich und realistisch. Falls die Daten sowohl vor Ort als auch in der Cloud gespeichert werden, lässt sich für sichere Backup-Kopien zudem eine 3-2-1-1-Sicherungsstrategie umsetzen.

Bildquelle: Information Storage Industry Consortium (INSIC).

Anmerkung: Nach Untersuchungen von Furthur Market Research und Brad Johns Consulting können durch die Speicherung von Daten auf Band, das als Airgap oder Langzeit-Deep Archiv dient, die CO2e-Emissionen um bis zu 97 % und der Energieverbrauch um bis zu 99 % reduziert werden.

Fazit

KI-Workloads – und zwar nicht nur solche, die generative KI beinhalten – benötigten optimierte Speicherplattformen (Hardware, Software, Services). Umgekehrt kann die KI bei der Automatisierung der Speicherverwaltung im Zuge stetig steigender Datenmengen unterstützen. Viele Anbieter verfügen bereits über KI-gestützte Verfahren und Assistenten, die Probleme im Speicherbereich, wie z.B. Ransomware-Angriffe, proaktiv erkennen und abwehren können.

Die Objektspeicherung ist besonders für große Kapazitäten von unstrukturierten Datenmengen sinnvoll. Dies gilt auch für hybride Cloud-Deployments in Verbindung mit inaktiven Daten. Wichtig im Cloud-Umfeld ist es, die Daten im Ruhezustand und auch während der Übertragung zu verschlüsseln. Cyberresilienz bedeutet in diesem Zusammenhang auch, die Sicherheit von Endpunkten und Backup-Daten mit Verfahren wie Air-Gap, Immutable Snapshots, Object-Lock etc. zu schützen.

Autor: N.Deuschle, Business Consulting & Research (Juli 2025 mit Update Feb. 2026).

(1) Quelle / Nachtrag:

Die LTO Program Technology Provider HPE, IBM und Quantum Corp. haben am 22. Juli 2025 ihre jährlichen Absatzzahlen von Tape-Medien veröffentlicht. Der Report zeigt "176,5 Exabyte (EB) an ausgelieferter Bandkapazität (komprimiert) für das Jahr 2024, was einem Wachstum von 15,4 % gegenüber 2023 entspricht. Die Gründe: Verstärkte Implementierung von künstliche Intelligenz und maschinelles Lernen in den Unternehmen; dazu ein erhebliches Wachstum bei unstrukturierter Daten und die Verlagerung hin zu kostengünstigeren Hybrid-Cloud-Umgebungen."

Externer Link > LTO Consortium.

Querverweise:

Unser Beitrag > Memory Centric Storage MCSS: Fraunhofer ITWM zeigt neues Storagesystem erstmals auf ISC 2025

In unserem Experten-Podcast nachgefragt: IT-Infrastruktur-Anforderungen für KI-Projekte im Unternehmensmaßstab

Unser Blogpost > Datenintensive KI-Applikationen und steigende Anforderungen an die Speicherinfrastruktur