KI-Agenten mit Docker Compose, offenen Standards und Cloud-Anbindung wie gewohnte containerbasierte Anwendungen entwickeln und betreiben…

Ankündigungsübersicht

Docker hat auf dem WeAreDevelopers World Cogress in Berlin im Juli diesen Jahres umfassende Erweiterungen vorgestellt, mit denen sich KI-gestützte Agentenanwendungen künftig mit Docker Compose leichter umsetzen und in produktive Umgebungen überführen lassen sollen. (1)

Neu sind u. a. eine Cloud-Offload-Funktion für rechenintensive Workloads sowie erweiterte Integrationen mit Plattformen wie Google Cloud, Azure und gängigen AI-SDKs. Die Neuerungen sind gedacht, um die Entwicklung agentenbasierter Anwendungen (Agentic Applications) zu vereinfachen. Docker bringt dazu komplexe KI-Technologien in die tägliche Entwicklerpraxis. Außerdem erweitert der Anbieter die Integrationen mit Cloud- und KI-Plattformen wie Google Cloud, Microsoft Azure, CrewAI, Embabel, LangGraph, Sema4.ai, Spring AI und Vercel AI SDK.

Hintergrund

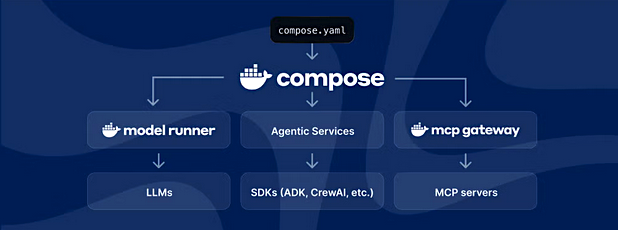

Nach Ansicht von Tushar Jain, EVP of Engineering bei Docker entwickeln sich agentenbasierte Applikationen zwar schnell weiter, aber "ihre produktive Umsetzung ist nach wie vor zu komplex...". Docker Compose als Werkzeug zur Definition und Orchestrierung von Multi-Container-Anwendungen macht Funktionsseitig jetzt den nächsten Schritt. Agentenarchitekturen – bestehend aus Modellen und Tools – sollen sich danach künftig ebenso deklarativ in YAML-Dateien definieren und operationalisieren lassen wie gewohnte Container-basierte Anwendungen.

Folgende Möglichkeiten ergeben sich daraus (Quelle: Docker):

"Agenten, KI-Modelle und Tools als Compose-Services in einer Datei deklarieren

Workloads lokal ausführen oder direkt in die Cloud (z. B. Google Cloud Run oder Azure Container Apps) deployen

Über Open-Source-Model Context Protocol (MCP) sicher auf externe Tools zugreifen

Vollständige Agenten-Stacks inklusive Versionierung und Sharing ohne Änderungen am Infrastruktur-Code bereitstellen."

Abb.: Docker Compose (Bildquelle: Docker).

Docker Offload – Cloud Power für lokale Workflows

Mit Docker Offload (laut Anbieter aktuell im geschlossenen Beta-Test) adressiert Docker einen zentralen Engpass bei KI-Anwendungen: lokale Rechner-Power reicht oft nicht aus für GPU-intensive Modelle. Offload erlaubt es, rechenintensive Workloads einfach in die Cloud zu verlagern, ohne ihre lokalen Workflows zu verändern. Docker Offload bietet dazu u.a.:

„Zugriff auf Cloud-GPU-Ressourcen bei gleichbleibender lokaler Entwicklungsgeschwindigkeit

Ausführung großer Modelle und Multi-Agent-Systeme in performanten Umgebungen

Flexible Steuerung des Offloads je nach Datenschutz-, Kosten- oder Performance-Anforderungen

Regionale Datenhoheit durch georedundante Steuerung der Ausführungsorte. Die Funktion ist direkt in Docker Desktop integriert – auch der gewohnte Befehl docker compose up nutzt bei Bedarf die zusätzliche Cloud-Leistung.“

Die neuen Funktionen werden durch verschiedene Partnerschaften flankiert:

Google Cloud: Unterstützung des Compose Specs in Cloud Run ermöglicht serverlose Deployments mit gcloud compose up.

Microsoft Azure: Unterstützung für Azure Container Apps folgt zeitnah.

KI-Frameworks: Compose-Integrationen für u.a. CrewAI, Embabel, LangGraph, Google ADK, Spring AI und Vercel AI SDK.

(1) Quelle / externer link > https://www.wearedevelopers.com/world-congress

Zur Verfügbarkeit (Quelle: Docker):

- Docker Compose für Agenten-Workloads: ab sofort allgemein verfügbar

- Docker Offload: als geschlossene Beta für registrierte Entwickler:innen

- Google Cloud Run-Integration: ab sofort live

- Azure Container Apps-Support: folgt in Kürze

- MCP Gateway & Docker Hub MCP Server: Open Source.

Querverweis:

Unser Blogpost > Container-native Virtualisierung mit KubeVirt

Unser Beitrag > OpenCloud startet mit Filesharing und File-Managementlösung als SaaS- oder on-premise Angebot

Unser Blogpost > Container, Virtualisierungstechnologie und Storage. Ein Überblick zu gängigen Einsatzszenarien