Aktuelle Kooperation für mehr Auswahl, Flexibilität und Effizienz von KI-Workloads in der Produktion. Red Hat AI auf AWS-KI-Chips Trainium und Inferentia...

Hintergrund

Das Aufkommen der generativen KI und der damit verbundene Bedarf an skalierbarer Inferenz zwingen Unternehmen dazu, ihre IT-Infrastruktur neu zu bewerten. IDC prognostiziert dabei, "dass bis 2027 40 % der Unternehmen maßgeschneiderte Siliziumchips, darunter ARM-Prozessoren oder KI/ML-spezifische Chips, einsetzen werden, um den steigenden Anforderungen an Performanceoptimierung, Kosteneffizienz und spezialisierte Rechenleistung gerecht zu werden“. Dies zeigt den Bedarf an optimierten Lösungen, die die Rechenleistung verbessern, die Kosten minimieren und schnellere Innovationszyklen für leistungsstarke KI-Anwendungen ermöglichen. (1)

(1) Quelle: (1) IDC FutureScape: Worldwide Cloud 2025 Predictions, 28. Oktober 2024, Doc #US52640724

Ankündigungsübersicht

Red Hat gab am 3. Dez. 2025 seine erweiterte Zusammenarbeit mit Amazon Web Services (AWS) bekannt, in deren Rahmen generative KI für Unternehmen auf AWS mit Red Hat AI und AWS AI Silicon bereitgestellt wird. IT-Entscheidungsträgern soll so die Flexibilität gegeben werden, (Zitat) „hochperformante, effiziente KI-Inferenz in großem Maßstab auszuführen, unabhängig von der zugrunde liegenden Hardware“.

Die Zusammenarbeit bietet Unternehmen die Möglichkeit, eine Full-Stack-Gen-AI-Strategie aufzusetzen, indem die umfassenden Plattformfunktionen von Red Hat mit der AWS-Cloud-Infrastruktur und den AI-Chipsätzen AWS Inferentia2 und AWS Trainium3 kombiniert werden. Zu den wichtigsten Aspekten der Zusammenarbeit gehören laut Entwickler:

"Red Hat AI Inference Server auf AWS-KI-Chips: Der Red Hat AI Inference Server, der auf vLLM basiert, wird auch mit AWS-KI-Chips wie AWS Inferentia2 und AWS Trainium3 nutzbar sein, um eine gemeinsame Inferenzschicht bereitzustellen, die jedes KI-Modell unterstützen kann. Damit können Unternehmen eine höhere Performance, geringere Latenz und Kosteneffizienz für die Skalierung von KI-Produktionsbereitstellungen erzielen – mit einer um 30 bis 40 % besseren Preis-Leistungs-Bilanz als bei aktuellen, vergleichbaren GPU-basierten Amazon-EC2-Instanzen.

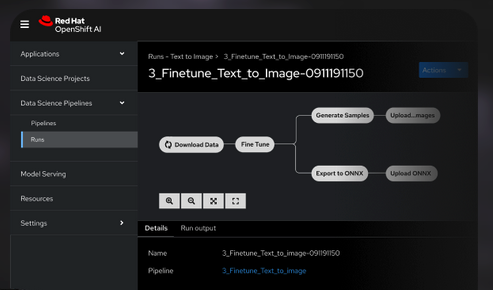

Bereitstellung von KI auf Red Hat OpenShift: Red Hat arbeitete mit AWS zusammen, um einen AWS Neuron Operator für Red Hat OpenShift, Red Hat OpenShift AI und Red Hat OpenShift Service auf AWS zu entwickeln. Eine umfassende und vollständig verwaltete Anwendungsplattform auf AWS bietet Unternehmen einen nahtlosen, unterstützten Weg, ihre KI-Workloads mit AWS-Beschleunigern auszuführen.

Einfacher Zugriff und leichte Bereitstellung: Durch die Unterstützung von AWS-KI-Chips bietet Red Hat seinen Kunden auf AWS einen verbesserten und einfacheren Zugriff auf stark nachgefragte Beschleuniger mit hoher Kapazität. Darüber hinaus hat Red Hat kürzlich die amazon.ai Certified Ansible Collection für Red Hat Ansible Automation Platform veröffentlicht, um die Orchestrierung von KI-Services auf AWS zu ermöglichen.

Beitrag zur Upstream-Community: Red Hat und AWS arbeiten gemeinsam an der Optimierung eines AWS-KI-Chip-Plugins, das an vLLM weitergeleitet wird. Als führender kommerzieller Mitwirkender an vLLM setzt sich Red Hat dafür ein, vLLM auf AWS zu unterstützen, um die KI-Inferenz- und Trainingsfunktionen für Benutzer zu beschleunigen. vLLM ist auch die Grundlage von llm-d, einem Open-Source-Projekt, das sich auf die Bereitstellung von Inferenz in großem Maßstab konzentriert und jetzt als kommerziell unterstützte Funktion in Red Hat OpenShift AI 3 verfügbar ist."

Bildquelle: Red Hat OpenShift AI.

Zur Verfügbarkeit (Quelle, Anbieter): Der AWS Neuron Community Operator ist ab sofort im Red Hat OpenShift OperatorHub für Kunden verfügbar, die Red Hat OpenShift oder Red Hat OpenShift Service auf AWS verwenden. Die Unterstützung von Red Hat AI Inference Server für AWS-AI-Chips soll voraussichtlich im Januar 2026 in einer Entwickler-Vorschau verfügbar sein.

Querverweis:

Unser Beitrag > Update zum Red Hat Summit und AnsibleFest 2025 in Boston (MA)

Unser Beitrag > Update zur AWS re:Invent 2025 mit einem Überblick zu wesentlichen Ankündigungen und Neuerungen

Unser Beitrag > Cloudkosten optimieren: Neue FinOps Lösung von Apptio auf Basis IBM Cloudability- und Kubecost 3.0