Unternehmen haben in der Regel keinen Mangel an Daten – im Gegenteil. Aufgrund der Datenflut besteht die Herausforderung darin, die wirklich relevanten Informationen herauszufiltern, um daraus Erkenntnisse für die Entwicklung von adaptiven Anwendungen zu gewinnen. Cloud-Datenbank-Plattform-Anbieter Couchbase zu den Gründen, weshalb dies in der Praxis häufig scheitern kann…

Zum Hintergrund

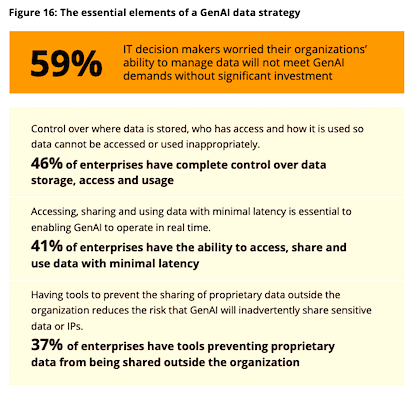

Die aktuelle Couchbase-Studie "Digital Modernization in 2025" zeigt (1), dass mit lediglich 17 Prozent nur eine Minderheit der Unternehmen in der Lage ist, Echtzeitanalysen für große Datenmengen auch durchzuführen.

- 41 Prozent befürchten danach, innerhalb der nächsten drei Jahre vom Markt zu verschwinden, falls sie es nicht schaffen, den Nutzererwartungen mit hyperpersonalisierten Apps gerecht werden zu können.

- Dringend gefordert sind adaptive Anwendungen, die sich dynamisch an wechselnde Faktoren wie Kundenwünsche oder Art der Umgebung anpassen. Handelsunternehmen können so beispielsweise passende Produkt- oder Serviceangebote zur richtigen Zeit am richtigen Ort platzieren oder personalisierte Reisen über eine Booking-App anbieten, die mit Echtzeit-Informationen ständig aktualisiert wird.

Viele Unternehmen kämpfen derzeit mit einer unzulänglichen Datenbasis. Spezialist Couchbase kommentiert nachfolgend für Sie die aus Sicht des Anbieters wichtigsten Hürden auf dem Weg zu Echtzeit-Analysen:

-

Keine klaren Zielvorgaben

Ohne klare Zieldefinition kann es keine Zielerreichung geben. Die Festlegung transparenter, messbarer Ziele muss daher am Anfang jedes Echtzeitanalyse-Projekts stehen. Das kann für Handelsunternehmen beispielsweise die Erhöhung der Kundenbindungsrate um einen vorgegebenen Prozentwert innerhalb eines bestimmten Zeitraums sein. Diese Vorgaben sind die Ausgangsbasis für die Datenselektion und die damit zu fahrenden Analysen. Nur so lassen sich praxisnahe Erkenntnisse gewinnen und nach Ablauf der Frist Erfolg oder Misserfolg messen.

-

Fokus auf Geschwindigkeit statt auf Datenqualität und Genauigkeit

Aktualität und Time-to-Market sind bei der Entwicklung adaptiver Applikationen wichtige Ziele. Trotzdem sollte die Geschwindigkeit dabei nicht an erster Stelle stehen. Wichtiger ist die Qualität der Daten: Veraltete oder unvollständige Datensätze führen zu ungenauen Ergebnissen. Die Datenvalidierung und -bereinigung hat daher Vorrang, um die Datenintegrität zu gewährleisten und das Vertrauen der Kunden in die Anwendung nicht zu enttäuschen.

Bildquelle: CIO SURVEY Digital Modernization in 2025. Are Data Strategies Ready for the AI Age? A Couchbase research report: Investigating how digital modernization strategies are adapting to the rise of artificial intelligence. Quelle / externer Link > https://www.couchbase.com/content/cio-survey-digital-modernization-in-2025

-

Wichtigkeit des Kontexts ignorieren

Um brauchbare Erkenntnisse zu gewinnen, sollten die Echtzeitdaten in ihrem Kontext analysiert werden, um Korrelationen aufzudecken. Für den plötzlichen Anstieg der Verkaufszahlen eines bestimmten Artikels kann eine Werbekampagne, Warenverknappung oder erhöhte Verbrauchernachfrage verantwortlich sein. Solche Kontextvariablen müssen abgeklärt werden. Dabei darf ein wichtiger Punkt nicht vergessen werden: Erkenntnisse über Korrelation sind zwar wichtig, aber nicht gleichbedeutend mit kausalen Zusammenhängen.

-

Ungeeignete Analyse-Tools einsetzen

Die Qualität der Verarbeitung und Visualisierung von Echtzeitdaten hängt entscheidend vom Einsatz der richtigen Technologien ab. Die eingesetzte Datenbank-Architektur sollte bei der Verarbeitung von Echtzeitdaten sowohl operative als auch analytische Arbeitslasten verarbeiten und korrelieren können. Das macht komplexe Data Warehouses samt den zeitraubenden Extract-Transform-Load (ETL)-Prozessen überflüssig, beschleunigt die Prozesse und reduziert sowohl die Komplexität als auch die Kosten.

Fazit Gregor Bauer, Manager Solutions Engineering CEUR bei Couchbase: „Der Druck auf Unternehmen wächst, ihren Kunden personalisierte Apps bereitzustellen, die sich an deren aktuellen Wünschen, Vorstellungen und Möglichkeiten orientieren. Datenqualität und -integrität sind der Schlüssel dafür…“.

Querverweis:

Unser Beitrag > Welche Graphdatenbank für welchen Anwendungsfall?

Unser Beitrag > Confluent mit Databricks Kooperation zur Integration von Echzeitdaten im KI-Stack

Unser Beitrag > Automatisierte Datenverwaltung: Denodo Platform 9.1 mit erweiterten Data Lakehouse Funktionen und AI SDK