Im Schnittpunkt zwischen KI und modernen Anwendungen liegen potentielle IT-Infrastruktur-Engpässe, doch wie kann man diese vermeiden? Ein Überblick zu gestiegenen Leistungsanforderungen an die Speicherinfrastruktur; mit Informationen zur aktuellen NVIDIA Spectrum-X Ethernet Platform…

Hintergrund

KI-Applikationen und deren Entwicklung stellen andere Anforderungen an die Speicherinfrastruktur als klassische transaktionsorientierte Enterprise-Workloads. Ein East-West-Netzwerk, das GPUs verbindet, ist für die Leistung von KI-Anwendungen von zentraler Bedeutung, aber ebenso wichtig ist die Speicherinfrastruktur, die High-Performance Storagesysteme verbindet.

Ohne schnellen Zugriff auf die Daten kein vernünftiger KI-System-Output. In Bezug auf die Auswahl und das Sizing einer möglichst leistungsfähigen KI-Infrastruktur aus Storage- und Speichernetzwerksicht ergeben sich eine Reihe anwendungsbezogener Fragen:

- Welche Modelle und Workloads stehen im Fokus? GPU-Anzahl, Trainingsbedarf, Data Lakes, Inferenz, RAG? Welche Anforderungen haben die einzelnen Phasen des KI-Prozesses? Geht es um große Sprachmodelle (LLMs) und-/oder kleinere Varianten? Welche Rolle spielt der Einsatz von Vektordatenbanken? Wie schnell sollen Analysedaten für Inferenz und Feinabstimmung bereitstehen? Wie können umfangreiche Datensätze kosteneffizient gesichert werden.

- Was bedeuten Latenzen und-/oder der begrenzte Durchsatz meiner Speichersysteme; wie wirkt sich das auf die Leistung des KI-Gesamtsystems aus? Bei komplexen Deep Learning Algorithmen mit hochparallelen Berechnungen bedeutet ein langsamer Speicher immer auch eine reduzierte maschinelle Lernleistung und damit Mehrkosten.

- Die zufällige Leseleistung bei geringer Warteschlangen-Tiefe (queue depth, QD) ist bei NAND Flash wie QLC aus Performance-Sicht bei Enterprise-Workloads nicht unproblematisch und in der Praxis ein gutes Leistungskriterium für die Systemperformance. Persistent Memory auf Basis Storage Class Memory bietet sich als Ergänzung für DRAM an, allerdings zu höheren Kosten. Dafür kann SCM eine 5-bis 10-fache Leistung gegenüber SSDs bei einer Random Read Queue Depth Range von 1-4 erzielen.

- Aus KI-Applikationssicht soll eine hohe "Ingest"-Bandbreite für Zugriffsmuster von kleinen bis großen Files zur Verfügung stehen. Bei kleineren Datensätzen eher unkritisch, weil neuronale Netzwerke innerhalb jeder Trainingseinheit auf die gleichen Daten zugreifen; diese können lokal auf Flash oder RAM zwischengespeichert werden. Bei vielen großen Datensätzen ergeben sich jedoch Herausforderungen in Bezug auf den „richtigen“ Storage, Protokolle, Filesysteme, Server-Technologien, disaggregierte Architekturen vs. Hyperconverged, Netzwerkkomponenten usw.

A) Ethernet-Netzwerkplattform für KI

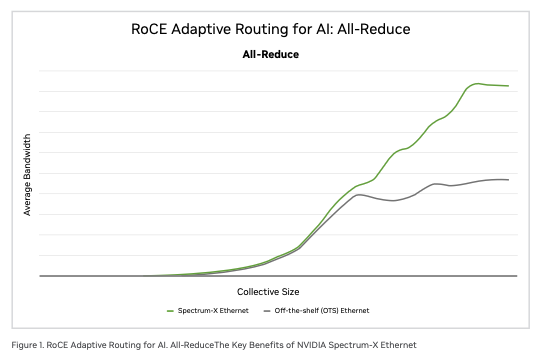

NVIDIA hat seine Spectrum-X-Netzwerkplattform funktional auf die Datenspeicher-Struktur und damit das entstehende Storage-Ökosystem ausgeweitet. Spectrum-X führte dazu Neuerungen ein, die von InfiniBand übernommen wurden. Darunter sind Funktionen wie RoCE (RDMA over Converged Ethernet aka „Rocky“)* Adaptive Routing und RoCE Congestion Control. In Verbindung mit der jeweiligen Speicherstruktur ist NVIDIA somit in der Lage, die Leistung und Netzwerknutzung von KI-Storage-Workloads zu erhöhen. Laut NVIDAI ist Spectrum-X ein „komplett standardbasiertes Ethernet mit Unterstützung für offene Ethernet-Stacks (SONiC) im Cloud-Maßstab.“

*Hinweis: RoCE v2 als Ethernet-Netzwerkprotokoll kann geroutet werden (Layer 3), was eine größere Skalierbarkeit über verschiedene Netzwerke hinweg ermöglicht. Adaptives Routing von Spectrum-X soll laut Entwickler nun Flusskollisionen mindern und die effektive Netzbandbreite weiter erhöhen.

Die Speicherleistung ist höher als bei RoCE v2, das derzeit von vielen Rechenzentren für KI-Rechen- und Speichernetzwerk-Infrastrukturen verwendet wird. Dazu wird NVIDIA mit Spectrum-X 200G Silicon Photonics Co-Packaged Optik-basierte Netzwerkswitches zur Skalierung von KI-Fabriken verfügbar machen. Der aktuelle NVIDIA Quantum-X Photonics-InfiniBand-Switch verbindet laut Entwickler über 10.000 GPUs in einer nicht blockierenden zweistufigen Fat-Tree-Topologie mit 800 Gbit/s.

Abb.: NVIDIA Spectrum-X Ethernet Platform. Ethernet purpose-built for AI, Datasheet (Bildquelle: NVIDIA).

Anbieter wie DDN, Dell Technologies, Hewlett Packard Enterprise, Hitachi Vantara, IBM, NetApp, Nutanix, Pure Storage, VAST Data und WEKA, arbeiten mit NVIDIA zusammen, um KI-optimierte Data Storage Plattformen anzubieten und weiterzuentwickeln. Quelle / externer Link > https://www.nvidia.com/de-de/networking/spectrumx/

B) Aspekte im Zusammenhang mit KI und Storage: Wie kann NFS für die KI-Entwicklung genutzt werden?

Für viele Workloads ist NFS in der Regle ausreichend, vor allem auf Enterprise-NAS-Systemen mit Caching und Load Balancing. Weniger anspruchsvolle Inferenz-Workloads oder auch modulares KI-Training mit reduzierten parallelen Datenzugriffen fallen z.B. in diese Kategorie. Für sehr Rechen- und datenintensive KI-Training-Workloads wie Deep Learning, HPC-Simulationen und weiteren Big Data Anwendungen kann je nach Umfang eine Standard NFS-Implementierung jedoch zum Engpass werden.

Alternativen sind parallele Dateisysteme oder moderne Enterprise-Scale-Out-NAS-Lösungen, falls Workloads von intelligenten Caching-Mechanismen wie z.B. SSD-basierten Read-Caching-/Tiering profitieren. Dazu gehören scale-out Enterprise NAS-Systeme, die parallele NFS-Cluster-Software nutzen, um NFS-Performance-Bottlenecks zu minimieren. Wobei NFS natürlich nicht immer das alleinige Problem ist, sondern Engpässe auch an anderen Stellen der Systemumgebung auftauchen können.

Standard NFS ist anfällig für einzelne Fehlerpunkte, wie die Verbindung eines einzelnen Mount-Points. Das bedeutet, ein Link-Failover kann dann nicht durchgeführt werden und die Host-Dienste sind unterbrochen.

NFS-Multipathing kann sicherstellen, dass mehrere Verbindungen zwischen Client und dem Server für jeden einzelnen Mount-Point verbunden sind, um die E/A-Übertragung über diese Verbindungen durchzuführen. Die Leistung wird damit verbessert. Auch wird der Verbindungsstatus regelmäßig überprüft, um eine schnelle E/A-Ausfallsicherung bei einem Verbindungsfehler zu gewährleisten.

Wenn ein Unternehmen leistungsstarke KI-Modelle trainiert, ist eine Scale-Out-Storagelösung sinnvoll. Fragen in dem Zusammenhang sind, ob Objekt Storage, File- und Blockstorage als integrierter Ansatz existiert, ggf. separat beschafft werden muss und welche Schwerpunkte aus Anwendungssicht gesetzt werden. Weitere Kriterien, welches scale-out-System zu den jeweiligen KI-Use Cases am besten passen, können sein:

Maximale I/O Performance und massive Datenmengen wie zum Training von ML-Modellen mit vielen GPUs. Wird neben File & Objektspeicher noch Block-Storage benötigt?

Open-Source-Alternativen mit nativer Integration in Kubernetes, OpenStack & S3. Sind mögliche Erweiterungen zu meiner vorhandenen Enterprise Scale-out NAS-Lösung ausreichend?

C) Übersicht zu wichtigen Leistungsanforderungen in Bezug auf den Storage:

1. Skalierbare Speicherkapazitäten: KI-Modelle erfordern je nach Modell sehr große Datenmengen für Training und Inferenz. Dynamisch erweiterbare Lösungen für NAS sowie Object Storage und ggf. Blockstorage sind nötig, inkl. der Möglichkeit zur Cloud-Integration, um maximale Flexibilität und Skalierbarkeit zu erreichen.

2. Kompression- und Deduplizierungstools um den Speicherbedarf zu reduzieren und Kosten zu senken: High-Density-Architekturen reduzieren Platzbedarf und Komplexität.

3. Hohe IOPS-Leistung bei geringer Latenz: KI-Workloads benötigen auf Grund des datenintensiven Charakters schnelle Lese- und Schreibzugriffe. NVMe-SSDs und persistenter Speicher wie Storage-Class Memory (SCM) sind dafür konzipiert, ergänzt um den begrenzten Einsatz von DRAM für Caching.

4. Hohe Bandbreite: Für das Training großer Modelle werden Daten in großem Umfang geladen. RDMA (Remote Direct Memory Access), 100 GBE+, InfiniBand, NVMe und RoCE sind Technologien der Wahl.

5. Parallelität: Der Speicher muss sich einfach erweitern lassen. Scale-up-/ scale-out-Architekturen zur parallelen Datenverarbeitung bieten sich an.

6. Unterstützung für verteilte Dateisysteme: Distributed Workloads profitieren von distributed scale-out Filesystemen; S3 Object Storage ist für große KI-Datasets sinnvoll. Große Speichercluster können aus CAPEX-Sicht teuer sein, weshalb Tiering-Konzepte mit SSD für Hot Data, HDD für Cold Data und Active Archiving Technologien mit Tape in Frage kommen können.

6. Datenpersistenz und Verfügbarkeit: Ausfallsicherheit und Redundanz durch verteilte Storage-Cluster. Snapshots, Replikation und moderne Backup-Technologien sind zu berücksichtigen.

7. Sicherheit und Datenschutz: Verschlüsselung, Zugriffskontrolle und Prozesse wie Auditing für sensible Daten und Governancethemen. (EU-)DSGVO- und Compliance-Konformität gewährleisten.

8. Kritischer Faktor Metadaten: Metadaten-Operationen stehen für rund 50 % aller Filesystem-Operationen. Die Skalierung von Metadaten ist im Vergleich zum Speichersystem - das den I/O Durchsatz idealerweise linear skaliert - komplexer. Dies liegt primär in der hierarchisch und voneinander abhängigen Natur der Dateisystem-Metadaten.

Die Anzahl an Metadaten-Operationen bei großen KI- und HPC-Workloads steigt weiter an. Kritische Faktoren sind neben der Verarbeitungsleistung deshalb die Verfügbarkeit von Metadaten. Auch ist eine möglichst einfache Verwaltbarkeit ohne weitere manuelle Interventionen bzw. zusätzliche Konfigurationsarbeiten gewünscht. Ein Beispiel ist CephFS: hier werden die Metadaten von den eigentlichen Daten entkoppelt, um den RADOS Cluster (Reliable Autonomic Distributed Object Store = Ceph object storage cluster) mit zusätzlichen Workloads nicht zu belasten. Die Metadaten werden von einem Cluster von Metadatenservern (MDS) verarbeitet. CephFS verteilt die Metadaten über sog. Dynamic Subtree Partitioning auf die MDSs.

Andere kommerziell verfügbare Filesystem speichern wiederum die Metadaten in einem verteilten und replizierten Key-Value-Store zur schnellen Metadaten-Speicherung über eine File Query Engine. Dann wird weder eine Kopie der Datei-Metadaten benötigt, die synchron gehalten werden muss, noch ist eine weitere Datenbanksystem-Schicht erforderlich.

Fazit

Nicht immer muss für KI-Projekte komplett neu beschafft werden (CAPEX). Wenn man startet, kann es besonders für viele kleinere- und mittlere Unternehmensgrößen und Projekte sinnvoll sein, bewährte vorhandene Enterprise Storage Funktionen mit KI-spezifischen Anforderungen zu kombinieren.

Enterprise-Storage bedeutet hohe Zuverlässigkeit, einfache Integration in bestehende IT-Umgebungen sowie umfassenden Support. Kombiniert mit KI-spezifischen Leistungsmerkmalen und den o.g. Kriterien wie hohe Bandbreiten, niedriger Latenz, parallele Datenzugriffen und flexible Skalierbarkeit ergibt sich eine Lösung mit Potential, die es ermöglicht bei Bedarf schrittweise auf spezialisierte, leistungsfähigere Systeme umzusteigen, falls die Projektanforderungen wachsen.

Bei KI ist es wichtig, die Speicherarchitektur stets im Auge zu behalten und wo nötig, gezielt zu modernisieren. Organisationen sind dann in der Lage, das Potenzial und die damit verbundenen Vorteile und Versprechen für die Anwendungsebene schneller auszuschöpfen.

Autor: Norbert Deuschle

Stand: Ende 2025

Hinweis: Dieser Beitrag ist ein Update meines Blogs „Datenintensive KI-Applikationen und steigende Anforderungen an die Speicherinfrastruktur“ von Mai 2025.

Weiterer Querverweis > Wie Künstliche Intelligenz die Anforderungen an IT-Infrastruktur und Datenspeicher erhöht