KI‑fähige Lösung zur vereinfachten Bereitstellung hoch-integrierter Plattformen für beschleunigte Rechen- und Speichernetzwerke in S3‑kompatiblen Enterprise‑Umgebungen…

Ankündigungsübersicht

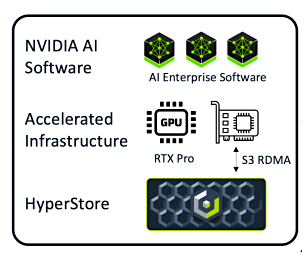

Cloudian - Anbieter softwaredefinierter Objektspeicherlösungen - hat am 30. Sept. 2025 offiziell die Cloudian HyperScale AI Data Platform vorgestellt. Die KI‑fähige Lösung basiert auf S3‑API‑Storage, ist kompatibel mit bestehenden Datensätzen und Anwendungen und soll sich bis in den Exabyte‑Bereich skalieren lassen. Die Plattform unterstützt das S3‑Speicherprotokoll über Remote Direct Memory Access (RDMA).

Die in Zusammenarbeit mit NVIDIA entwickelte S3‑over‑RDMA‑Schnittstelle steigert die Leistung zusätzlich, indem sie höhere Lese‑ und Schreibdurchsätze liefert und den Zugriff auf KI‑Speicherressourcen optimiert. Entwicklungsziel war ein beschleunigtes Computing mit integrierter Vektordatenbank‑Funktionalität direkt auf der Speicherebene (Anmerkung: s.a. unser Beitrag > Integration von Cloudian S3 Objektspeicher mit NVIDIA GPUDirect Storage).

Hintergrund

Die Cloudian HyperScale AI Data Platform wurde auf den Markt gebracht, um eine der zentralen Herausforderungen von Unternehmen bei der Einführung von Agentic AI und GenAI zu lösen: Umfangreiche unstrukturierten Datenbestände sofort für KI‑Anwendungen erschließen und nutzbar machen. Die Plattform basiert auf der NVIDIA RTX PRO 6000 Blackwell Server Edition GPU und folgt dem Referenzdesign der NVIDIA AI Data Platform. Hiermit sollen Organisationen auf die 90 % ihrer Daten zuzugreifen können, die unstrukturiert vorliegen – so etwa Berichte, Handbücher, Präsentationen und Multimediainhalte, die das interne Wissen ausmachen.

Komplexe Infrastrukturanforderungen eliminieren

KI‑Implementierungen erfordern in der Regel komplexe Filesysteme und separate Vektordatenbanken, um die nötige Performance zu erreichen. Mit Hilfe der neuen Cloudian HyperScale AI Data Platform sollen Unternehmen KI‑Applikationen direkt auf den nativen S3‑kompatiblen Datenquellen betreiben können – ohne zusätzliche Dateisystemebenen oder eine separate Vektordatenbank‑Infrastruktur. Dieser Ansatz reduziert laut Entwickler die Komplexität, beschleunigt Implementierungen und erlaubt es, bestehendes IT‑Know‑how und vorhandene Infrastruktur-Investitionen besser zu nutzen.

Unternehmensdaten in KI‑fähige Informationen verwandeln

Die Lösung bringt KI‑Rechenleistung direkt an die Datenspeicher und macht diese automatisch zur KI‑fähigen Infrastruktur. Mittels einer in die Speicherebene integrierten Vektordatenbank werden multimodale, unstrukturierte Inhalte automatisch aufgenommen, eingebettet und indiziert. Damit lassen sich Daten über Vektorsuchschnittstellen sofort finden und für Retrieval‑Augmented‑Generation‑Workflows (RAG) bereitstellen. Dieser Ansatz soll sicherstellen, dass KI‑Agenten in der gesamten Firma Informationen nahezu in Echtzeit auffinden, durchsuchen und analysieren können; Datensilos werden damit aufgelöst.

Bildquelle: Cloudian HyperScale® AI Data Platform.

Kommentarauszug Justin Boitano, Vice President, Enterprise AI Products bei NVIDIA: „Der Erfolg von KI in Unternehmen hängt davon ab, unnötige Datenbewegungen zu vermeiden und Rechenleistung dorthin zu bringen, wo die Daten liegen…“.

Zentrale Funktionsmerkmale der neuen Plattform (Quelle, Anbieter):

„Weniger Infrastrukturkomplexität: Integrierte Vektordatenbank‑Funktionen machen das Design und den Betrieb separater Dateisysteme und Vektordatenbanken überflüssig – und damit auch spezialisiertes Fachwissen.

Automatisierte KI‑Readiness: Daten werden beim Speichern sofort klassifiziert, mit Echtzeit‑Metadaten angereichert und vektorisiert – manuelle Datenaufbereitung und aufwändige Bereitstellungen entfallen.

Native S3‑API: Volle Interoperabilität mit dem breiten Ökosystem von KI‑Tools für die S3‑API sowie direkter Zugriff auf bereits im S3‑Format gespeicherte Daten – dem De‑facto‑Standard für cloudbasierte Informationen.

Hohe Performance: RDMA‑Netzwerke ermöglichen S3‑Objektspeicher mit direkten Datenpfaden zwischen Storage, Systemspeicher und GPU‑Speicher – für extrem geringe Latenzen und bis zu 35 GB/s pro Knoten (Reads), skalierbar bis auf Terabytes pro Sekunde.

Skalierung: Basierend auf Cloudians Exabyte‑skalierbarer Plattform unterstützt die Lösung riesige Vektordatensätze mit konsistentem, hochperformantem Zugriff – ohne architektonische Limitierungen.

Datensouveränität: Die On‑Premises‑Infrastruktur gewährleistet volle Kontrolle über sensible Daten – mit robusten Sicherheitsmechanismen, Enterprise‑tauglichen Zugriffskontrollen und Governance‑Richtlinien. Unternehmen behalten Eigentum und Kontrolle über ihre Daten und können dennoch KI-Innovationen vorantreiben.

Einheitliche Architektur: Reduziert die Komplexität und Kosten separater Systeme für Daten, Metadaten und Vektordatenbanken, indem alle Funktionen in einer einheitlichen Plattform zusammengeführt werden.

Unternehmensreife KI‑Infrastruktur für die Ära der KI‑Agenten: Durch die Kombination aus beschleunigtem Computing und integrierten Vektordatenbank‑Funktionen direkt auf der Speicherebene macht die HyperScale AI Data Platform den Aufbau und Betrieb komplexer, separater KI‑Infrastrukturen überflüssig. Dieser Ansatz ermöglicht eine schnelle Bereitstellung auf Basis vorhandener IT‑Fähigkeiten und bestehender Infrastruktur.“

Wesentliche Komponenten der Lösung sind NVIDIA RTX PRO 6000 Blackwell GPUs, NVIDIA BlueField DPUs und NVIDIA AI Enterprise Software – darunter NVIDIA NIM und NVIDIA NeMo Retriever Microservices. NVIDIA Spectrum‑X Ethernet‑Networking bietet mit RDMA und direkten Datenpfaden zwischen Storage, Systemspeicher und GPU‑Speicher eine extrem niedrige Latenz und laut Anbieter bis zu 35 GB/s pro Knoten (Read), skalierbar bis auf Terabytes pro Sekunde.

Fazit der Ankündigung: Die Lösung adressiert die Herausforderung, KI‑Agenten zentral in Geschäftsprozesse zu integrieren. Organisationen können dann KI‑Anwendungen entwickeln, die sicher und schnell auf Unternehmensdaten zugreifen, bei voller Kontrolle über ihre Daten.

Querverweis:

Unser Beitrag > Hybride Datenarchitekturen als entscheidender Faktor zur sicheren und beschleunigten KI-Integration

Unser Beitrag > Neo4j Graphdatenbank Infinigraph unterstützt kombinierte Operationale- und Analytische-Workloads

Unser Beitrag > Dell Technologies- und NVIDIA AI Data Platform: Neues Referenzdesign für GPU-beschleunigte Architektur