Im Test: OpenFlex™ Data24 4000 Series NVMe-oF™ Speicherplattform in Kombination mit KIOXIA NVMe SSDs und AI Data Server von PEAK:AIO für KI-Workloads…

Hintergrund

KI-Anwendungen werden komplexer und datenintensiver. Damit steigen auch die Anforderungen an Speichersysteme, um mit den schnellen Recheninfrastrukturen Schritt zu halten. Um die Leistungsfähigkeit der OpenFlex™ Data24 4000 Series NVMe-oF™ Speicherplattform zu validieren, veröffentlichte Western Digital am 4. Aug. 2025 die Testergebnisse auf Basis des MLPerf® Storage V2 Benchmarks. (1) Sie belegen laut Hersteller, dass das OpenFlex Data24 EBOF („Ethernet Bunch of Flash“) den Anforderungen moderner KI-Workloads gewachsen ist.

Reale Testszenarien für KI

Die OpenFlex Data24 NVMe-oF Speicherplattform von Western Digital nutzt die Leistung von NVMe-Flash über Ethernet-Fabrics, um latenzarmen und gemeinsam nutzbaren Speicher für skalierbare, disaggregierte KI-Infrastrukturen bereitzustellen. GPU-/CPU-Rechenleistung und Speicher können damit unabhängig voneinander skaliert werden.

Um realistische Einsatzszenarien abzubilden, in denen Speichersysteme mit der hohen Datenrate moderner GPU-Infrastrukturen mithalten, arbeitet Western Digital mit PEAK:AIO zusammen. Die softwaredefinierten Storage-Lösungen (SDS) des Unternehmens sind danach in der Lage, große Datenmengen schnell aufzunehmen, zu verarbeiten und bereitzustellen.

Die Tests basierten auf einer Konfiguration mit KIOXIA CM7-V Series NVMe SSDs, die aufgrund ihrer Perfomance für KI-Anwendungen ausgewählt wurden. In der OpenFlex Data24-Plattform liefern sie nach vorliegenden Angaben dauerhaft hohe Datenraten an GPU-Client-Nodes – und zeigt die Vorteile disaggregierter Speicherarchitekturen im KI-Betrieb auf.

Benchmark-Ergebnisse mit MLPerf Storage V2

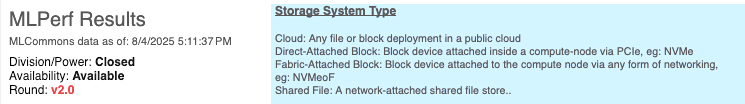

Die Testergebnisse im MLPerf KI-Benchmarks zeigen, dass die o.g. Architektur sowohl hohe Leistung unter Last als auch eine effiziente Skalierung ermöglicht – unabhängig davon, ob SDS eingesetzt wird oder nicht. (1)

MLPerf Storage verwendet GPU-Client-Nodes – Systeme, die das Verhalten eines KI-Servers beim Zugriff auf den Speicher während des Trainings oder der Inferenz simulieren – und erzeugt so realitätsnahe I/O-Lastprofile. So lässt sich beurteilen, wie gut ein Speichersystem verteilte KI-Umgebungen mit mehreren gleichzeitig aktiven GPU-Clients bewältigen kann. Im Rahmen der MLPerf Storage Tests werden über verschiedene Deep-Learning-Modelle hinweg unterschiedliche Anforderungen an die Storage-I/O-Performance gestellt – etwa in Bezug auf Durchsatz und parallele Zugriffe. Zur Bewertung verwendet MLPerf mit 3D-UNet und ResNet-50 zwei zentrale Benchmarks:

3D-UNet Workload

3D-UNet ist ein Deep-Learning-Modell für medizinische Bildgebung und volumetrische Segmentierung. Aufgrund der großen 3D-Datensätze und der intensiven, sequenziellen Lesezugriffe stellt es hohe Anforderungen an die Speicherinfrastruktur – und eignet sich daher besonders gut zur Bewertung von Systemen mit dauerhaft hoher Bandbreite und niedriger Latenz in Multi-Node-KI-Workflows. Testergebnis (Quelle: WDC, Benchmark).

Das OpenFlex Data24 von Western Digital erreichte eine konstante Lesedurchsatzrate von 106,5 GB/s (99,2 GiB/s) und versorgte 36 simulierte H100-GPUs über drei physische Client-Nodes – laut WDC Beleg für die Fähigkeit, mit dem EBOF bandbreitenintensive und hochparallele Trainingsaufgaben zu bewältigen.

In Kombination mit dem PEAK:AIO AI Data Server lieferte das OpenFlex Data24 eine Durchsatzrate von 64,9 GB/s (59,6 GiB/s) – genug, um 22 simulierte H100-GPUs mit nur einem Head-Server und Single Client Node vollständig auszulasten.

ResNet-50 Workload

ResNet-50 ist ein weit verbreitetes Convolutional Neural Network (CNN) zur Bildklassifikation. Als Benchmark misst es den Trainingsdurchsatz und stellt ausgewogene Anforderungen an Rechenleistung und Datentransfer.

Aufgrund der Kombination aus zufälligen und sequentiellen I/O-Mustern bei mittelgroßen Bilddateien eignet sich der Test besonders, um die Effizienz eines Systems im Umgang mit kleinen Dateien und schnellen Iterationszyklen zu bewerten.

Ergebnis: Das Western Digital OpenFlex Data24 erzielte bei 186 simulierten H100-GPUs über drei Client-Nodes danach höchste Leistungswerte, was die effiziente Nutzung der vorhandenen Speichermedien zeigt.

Mit dem PEAK:AIO AI Data Server konnte das System dadnach 52 simulierte H100-GPUs über einen Head-Server und Single Client Node vollständig auslasten.

(1) Bildquelle: MLPerf Storage Benchmark Suite.

Externer Link > https://mlcommons.org/working-groups/benchmarks/storage/

Kommentarauszug Uwe Kemmer, Director EMEA Field Engineering bei Western Digital: „Die Ergebnisse zeigen eindeutig, dass unsere disaggregierte Architektur eine starke Grundlage für kommende KI-Infrastrukturen darstellt. Bei maximierter GPU-Nutzung können Platzbedarf und Komplexität reduziert und so Gesamtbetriebskosten gesenkt werden…“.

Fazit

Western Digitals OpenFlex Data24 ermöglicht in Kombination mit RapidFlex™-Netzwerkadaptern den direkten Anschluss von bis zu 12 Hosts ohne zusätzlichen Switch. Eine planbare Skalierung von KI-Infrastrukturen – ohne hohe Anfangsinvestitionen oder übermäßigen Stromverbrauch - ist damit für Unternehmen möglich.

Querverweis:

Unser Beitrag > Neue KIOXIA AiSAQ Softwareversion vereinfacht SSD-Einsatz für Vektordatenbanksuchen in RAG-Systemen

Unser Blogpost > Wie Künstliche Intelligenz die Anforderungen an IT-Infrastruktur und Datenspeicher erhöht

Unser Beitrag > KI und GPU-Workload-Anforderungen: Storage mit HBM Memory im KI-Daten-Lebenszyklus